Edge AI bezeichnet die Bereitstellung von KI-Algorithmen und KI-Modellen direkt auf lokalen Edge-Geräten. Da die Anzahl der Internet of Things (IoT)-Geräte weiterhin zunimmt, wächst die Nachfrage nach effizienter Datenverarbeitung. Die Optimierung dieser Modelle für ressourcenbeschränkte Umgebungen bleibt jedoch eine Herausforderung. In diesem Blogbeitrag untersuchen wir Splitting Stump Forests (SSF), eine leistungsstarke Kompressionstechnik für Baum-Ensemble-Modelle, die eine effiziente Bereitstellung von Edge AI ermöglicht.

Wie IoT das tägliche Leben verändert

Haben Sie sich jemals gefragt, wie ein intelligentes Thermostat die Temperatur in Ihrem Haus anpasst? Oder wie Ihre Smartwatch Ihre körperliche Aktivität überwacht und sogar Ihre Schlafmuster analysiert? Oder wie eine Sicherheitskamera Ihr Gesicht erkennt?

Diese Errungenschaften sind alle durch die Innovationen des Internet of Things (IoT) möglich. Diese Technologie basiert auf Sensoren, die Daten sammeln, die dann an Cloud-Server gesendet werden, um Algorithmen zur Vorhersage und Reaktion auf Ihre Bedürfnisse auszuführen. Da unsere Umgebung zunehmend „intelligent“ wird, wird die weltweite Anzahl von (IoT)-Geräten bis 2030 auf über 40 Milliarden geschätzt. Mit diesem Wachstum steigt auch der Bedarf an schnellerer, effizienterer Datenverarbeitung. Hier kommt Edge AI ins Spiel.

Was ist Edge AI?

Edge AI ist die Bereitstellung von KI-Algorithmen und -Modellen direkt auf lokalen Edge-Geräten.

Viele Anwendungen erfordern Echtzeitentscheidungen, wie z. B. intelligente Kameras zur sofortigen Bedrohungserkennung, autonome Fahrsysteme zur Anpassung ihres Weges und industrielle Sensoren zur sofortigen Anomalieerkennung.

Diese Herausforderung treibt die Einführung von Edge AI voran. Durch die lokale Verarbeitung von Daten reduziert oder eliminiert Edge AI die Notwendigkeit der Datenübertragung und adressiert Bedenken wie Konnektivität, Kommunikationskosten, Netzwerklatenz und Datenschutz. Während die Edge-Bereitstellung die Reaktionsfähigkeit verbessert, erfordert das Erreichen einer höheren Vorhersagegenauigkeit oft die Verwendung von Ensemble-Modellen.

Ensemble Models auf IoT-Geräten: Was ist die Herausforderung?

Ensemble-Modelle übertreffen oft einzelne Klassifikatoren bei verschiedenen maschinellen Lernaufgaben. Ein Random Forest beispielsweise reduziert die Varianz der Vorhersagen im Vergleich zu einem einzelnen Entscheidungsbaum und verbessert so die Gesamtleistung des Modells. Allerdings sind die Kosten für die Verwendung von Random Forests für ressourcenbeschränkte Geräte erheblich höher. Die Verwendung nur weniger kleiner Bäume in einem Random Forest kann die Vorhersageleistung begrenzen, während größere, leistungsfähigere Modelle oft schwierig auf Geräten mit begrenztem Flash-Speicher bereitzustellen sind. Dies führt zur folgenden Frage:

Können wir die Modellgröße reduzieren, ohne die Vorhersageleistung zu beeinträchtigen?

Um dies zu adressieren, präsentieren wir Splitting Stump Forests (SSF), ein Kompressionsschema, das speziell für Baum-Ensemble-Modelle, insbesondere Random Forests, entwickelt wurde. Im folgenden Abschnitt erklären wir die Methode im Detail.

Splitting Stump Forests (SSF)

Um eine effiziente Komprimierung zu erreichen, extrahiert unser Ansatz (1) eine Teilmenge von Testknoten aus einem trainierten Random Forest, um ein leichtgewichtiges Ensemble von Splitting Stumps zu erstellen, das nur wenige Kilobyte Speicher benötigt. Danach (2) werden Eingabedaten in eine Multi-Hot-Codierung transformiert und (3) ein linearer Klassifikator wird verwendet, um die transformierten Daten in die Ziel-Domäne abzubilden.

Abbildung 1 zeigt die Vorgehensweise in den drei oben beschriebenen Hauptschritten.

Erster Schritt: Auswahl informativer Split-Knoten

Der erste Schritt von Splitting Stump Forest wählt eine Teilmenge informativer Splits aus einem trainierten Random Forest aus.

Um dies zu erreichen, schlagen wir ein Auswahlkriterium vor, das Split-Bedingungen bevorzugt, die zu ausgewogenen Unterbäumen führen. Insbesondere bewerten wir jeden Knoten im Entscheidungsbaum basierend auf dem Gleichgewicht der Trainingsstichproben zwischen seinen linken und rechten Ästen.

Um zu verstehen, warum wir ausgewogene Knoten auswählen, werfen wir einen genaueren Blick auf Abbildung 2. Sie zeigt die Entscheidungsgrenzen sowohl von Random Forests als auch von Splitting Stump Forests auf zweidimensionalen Projektionen der Statlog- und Rice-Datensätze. Im Falle von Random Forests könnten Ihnen kleine, diskontinuierliche Regionen auffallen. Sie treten auf, wenn das Split-Kriterium einen relativ kleinen Teil der Trainingsdaten mit reinen Labels abschneidet. Dies könnte sich nachteilig auf die Generalisierung auswirken, da es zu Overfitting führt und das Modell empfindlicher gegenüber Rauschen und Ausreißern macht.

Abbildung 2: Beispiel für Entscheidungsgrenzen bei der Datenklassifizierung zwischen Random Forests (RF) und Splitting Stump Forests (SSF) auf zweidimensionalen Projektionen von zwei Datensätzen.

Aber hier ist der überraschende Teil: Die Methode der Splitting Stump Forests erreicht fast das gleiche Maß an Genauigkeit, obwohl sie nur 0,2 % der gesamten Knoten verwendet, die vom Random Forest eingesetzt werden.

Beeindruckend, oder? Sehen wir uns nun an, was nach der Auswahl dieser ausgewogenen Knoten passiert.

Zweiter Schritt: Umwandlung von Knoten in Stumps

Das Ergebnis des vorherigen Schritts ist eine Menge isolierter Knoten, die jeweils ein Merkmal und einen Split-Wert repräsentieren, aber noch kein strukturiertes Modell bilden. Um dies zu lösen, fügen wir jedem Knoten zwei Blätter hinzu und verwandeln ihn so in die Wurzel eines einfachen Entscheidungsbaums mit nur einer Ebene. Jetzt kann man die Eingabedaten in einen neuen Merkmalsvektor abbilden, wobei der Wert ‚1‘ im Merkmalsvektor anzeigt, dass die Split-Bedingung seines Wurzelknotens erfüllt ist.

Dritter Schritt: Leichtgewichtige Trainierung von Splitting Stump Forests

Um die Bereitstellung auf Geräten mit begrenzten Ressourcen zu ermöglichen, verwenden wir ein lineares Modell, um die individuellen Vorhersagen der Entscheidungsbäume zu kombinieren. Durch die Anwendung von logistischer Regression modellieren wir die Beziehung zwischen den transformierten Merkmalsvektoren und der Zielvariablen. Das Ergebnis ist ein Modell, das nicht nur ressourcenschonend, sondern auch leicht interpretierbar ist.

Erforschung der Leistung von Splitting Stump Forests

Um die Leistung von Splitting Stump Forests (SSF) zu testen, haben wir es auf 13 Benchmark-Klassifikationsdatensätzen, hauptsächlich aus dem UCI-Repository, mit unterschiedlichen Eigenschaften bewertet. Diese vielfältige Auswahl ermöglichte eine Bewertung über verschiedene Komplexitäten hinweg. Wir haben Random Forests mit der Gini-Index-Reduktion für das Splitting trainiert, indem wir die maximale Tiefe einzelner Entscheidungsbäume und die Gesamtzahl der Entscheidungsbäume variiert haben.

Wenn es um die Vorhersageleistung geht, übertraf SSF in den meisten Läufen die ursprünglichen Random Forests und modernste Methoden. Noch beeindruckender ist, dass SSF die Modellgröße im Vergleich zu anderen Methoden um zwei bis drei Größenordnungen erheblich reduzierte und seine Inferenzzeit schneller war als die der leistungsstärksten Modelle konkurrierender Methoden. Darüber hinaus bestätigen die Ergebnisse, dass die ausgewählten Testknoten informativ und nicht zufällig sind.

Analyse der Vorhersageleistung unter Speicherbeschränkungen

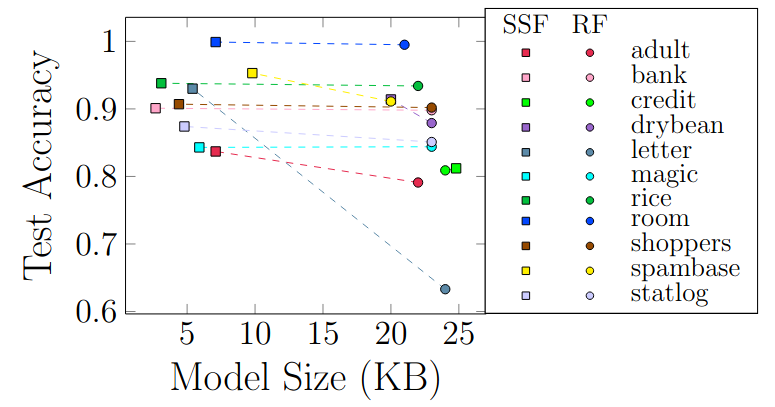

Aufgrund von Speicherbeschränkungen bei kleinen Smart Devices analysieren wir die Leistung von Splitting Stump Forest innerhalb eines strikten Speicherbudgets. Um Geräte mit begrenzter Speicherkapazität zu berücksichtigen, haben wir die besten Modelle ausgewählt, die in nur 32 KB oder 16 KB Speicher passen. Solche Modelle eignen sich für den Einsatz auf Mikrocontroller-Einheiten wie Arduino Uno und ATmega169P. Wie in Abbildung 3 gezeigt, übertrafen die Splitting Stump Forest-Modelle die Random-Forest (RF)-Modelle in allen Datensätzen, mit einer bemerkenswerten Verbesserung von über 3 % in fünf Datensätzen. Dies zeigt, dass man für Effizienz nicht auf Leistung verzichten muss!

Abbildung 3: Das Diagramm zeigt das beste Modell, das von RF und SSF mit einer endgültigen Modellgröße von weniger als 32 KB erreicht wurde.

Als ergänzendes Experiment haben wir die Grenzen der Kompression weiter ausgelotet, indem wir einen leichten Genauigkeitsverlust in Kauf nahmen. Unser Ziel war es, das kleinste SSF-Modell zu identifizieren, das innerhalb einer Genauigkeitsmarge von 2 % im Vergleich zum Random-Forest-Modell liegt. Die Ergebnisse waren beeindruckend: Die Splitting Stump Forest-Methode erreichte bemerkenswerte Kompressionswerte von 0,012, 0,02, 0,017, 0,025, 0,037 und 0,005 für die Spambase-, Shoppers-, Adult-, Room-, Rice- und Bank-Datensätze.

Sind die ausgewählten Knoten wirklich informativ?

Um die Informationsdichte der ausgewählten Knoten zu validieren, verglichen wir ihre Vorhersageleistung mit der einer zufällig ausgewählten Stichprobe derselben Größe. Für einen gegebenen Datensatz berichteten wir sowohl die Genauigkeit als auch die Anzahl der hoch bewerteten Knoten $n$. Anschließend wählten wir zufällig $n$ Knoten aus der gesamten Knotenmengen aus, wandelten sie in Splitting Stumps um und trainierten ein lineares Modell unter Verwendung ihrer Datenrepräsentation.

Wir stellten fest, dass stichprobenbasierte Stumps ihre zufällig gewählten Gegenstücke in den meisten Datensätzen durchgehend übertrafen. Darüber hinaus übertrafen diese hoch bewerteten Stumps auch eine äquivalente Menge an niedriger bewerteten Knoten, was bestätigt, dass Knoten mit höherer Trennschärfe erheblich nützlichere Informationen liefern.

Fazit

Zusammenfassend komprimieren Splitting Stump Forests (SSF) einen großen Random Forest in ein kompaktes Modell, ohne an Genauigkeit zu verlieren. Die komprimierten Modelle sind für ressourcenbeschränkte Edge-Geräte geeignet.

Diese Ergebnisse werfen interessante Fragen für zukünftige Forschungen auf, insbesondere zur Entwicklung praktischer Bereitstellungsstrategien für Edge-Geräte. Dies ist entscheidend, um sicherzustellen, dass die Vorteile der Modellkomprimierung in realen Anwendungen voll genutzt werden können, insbesondere im Zuge der fortschreitenden Integration von machinellem Lernen Modellen in Edge-Geräte.

Möchten Sie die vollständige Studie lesen? Sie können das Paper hier finden:

Alkhoury, F., Welke, P. (2025). Splitting Stump Forests: Tree Ensemble Compression for Edge Devices. In: Pedreschi, D., Monreale, A., Guidotti, R., Pellungrini, R., Naretto, F. (eds) Discovery Science. DS 2024. Lecture Notes in Computer Science (LNAI), vol 15244. Springer, Cham. https://doi.org/10.1007/978-3-031-78980-9_1