Einführung: KI bedeutet nicht immer LLM

In der aktuellen KI-Landschaft ist „LLM“ (Large Language Model) zu einem absoluten Buzzword geworden. Seit der Einführung von Modellen wie GPT-3 durch OpenAI im Jahr 2020 sind Unternehmen bestrebt, diese Technologie zu implementieren. Die Einführung von ChatGPT im Jahr 2022 hat den Aufschwung von LLMs noch verstärkt und sowohl in der Wissenschaft als auch in den Medien große Aufmerksamkeit erregt. Diese Modelle, die auf großen Datensätzen und immensen Rechenressourcen basieren, haben die Verarbeitung natürlicher Sprache (Natural Language Processing, NLP) revolutioniert und in verschiedenen Bereichen bemerkenswerte Fähigkeiten bewiesen.

LLMs haben nicht nur das Feld der NLP verändert, sondern auch Innovationen in zahlreichen Branchen angestoßen. Unternehmen in unzähligen Bereichen sind bestrebt, LLMs in ihre Arbeitsabläufe zu integrieren oder auf ihrer Grundlage völlig neue Produkte zu entwickeln. Die Medien heizen diesen Enthusiasmus ständig an, indem sie die neuesten Fortschritte und Funktionen hervorheben, die durch LLMs ermöglicht werden. Diese weit verbreitete Begeisterung hat den Eindruck entstehen lassen, dass der Einsatz von LLM-Technologie unerlässlich ist, um wettbewerbsfähig zu bleiben.

Die entscheidende Frage ist jedoch: Sind Große Sprachmodelle (LLMs) wirklich die beste Wahl für jeden Anwendungsfall?

Tatsächlich gibt es Szenarien, in denen traditionelle Methoden des maschinellen Lernens (ML) nicht nur effektiver, sondern auch kostengünstiger und praktischer sein können. Dieser Artikel beleuchtet, wann der Einsatz von LLMs sinnvoll ist und wann alternative KI-Ansätze besser zu Ihren Anforderungen passen. Denn obwohl LLMs unbestreitbar leistungsstark sind, stellen sie keine universelle Lösung dar. Ein klares Verständnis ihrer Stärken und Grenzen ermöglicht es Ihnen, fundierte Entscheidungen zu treffen und die Technologie auszuwählen, die Ihre individuellen Bedürfnisse am besten erfüllt.

Was ist ein LLM und wie funktioniert es?

Die Funktionsweise eines großen Sprachmodells (Large Language Model, LLM) lässt sich zunächst simpel beschreiben: Basierend auf einem Eingabetext, dem sogenannten „Prompt“, sagt das Modell das wahrscheinlichste nächste Wort in der Sequenz voraus und generiert es schrittweise, einen Token nach dem anderen. Dieser Prozess, bekannt als autoregressive Sprachmodellierung, ist in der folgenden Abbildung dargestellt.

Abbildung 1: Das LLM erhält einen ersten Prompt und findet das nächste wahrscheinlichste Wort. Es fügt es dann dem Prompt hinzu und gibt den neuen Text an sich selbst weiter. Dieser Vorgang wird wiederholt bis die End-of-Sequence-Markierung generiert wird.

Im Kern übernehmen LLMs dieselbe grundlegende Aufgabe wie frühere Sprachmodelle. Bereits einfache n-Gramm-Modelle, die von Claude Shannon in den 1940er Jahren entwickelte, folgten dem Prinzip, das nächste Wort basierend auf dem vorherigen Kontext vorherzusagen. Während dieses Grundprinzip unverändert bleibt, liegt die eigentliche Herausforderung darin, Wörter so zu wählen, dass ein semantisch sinnvoller und nützlicher Text entsteht. Genau in der Methode der Wortwahl liegt der entscheidende Unterschied moderner LLMs.

Was hebt LLMs von ihren Vorgängern ab?

Der Unterschied zu früheren Sprachmodellen lässt sich auf drei zentrale Faktoren zurückführen:

- Umfang: LLMs zeichnen sich durch ihre enorme Anzahl von Parametern aus, die oft im Milliardenbereich liegt. Diese hohe Kapazität ermöglicht es ihnen, selbst komplexe sprachliche Muster und Nuancen zu modellieren.

- Daten: Um ihr Potenzial voll auszuschöpfen, werden LLMs auf riesigen, vielfältigen Datensätzen trainiert, die eine breite Palette an Themen und Sprachstilen abdecken.

- Architektur: Moderne LLMs basieren auf der Transformer-Architektur oder deren Variationen, die es ihnen erlaubt, auch weitreichende Abhängigkeiten im Text effizient zu erfassen und zu verarbeiten.

Erst die Fortschritte im Distributed Training, also der verteilten Verarbeitung auf zahlreichen GPUs, haben es in den letzten Jahren möglich gemacht, Modelle dieser Größe zu entwickeln und zu trainieren.

Die Auswirkungen von LLMs sind weitreichend. Sie können nicht nur einfache, strukturierte Sätze wie den im obigen Beispiel generieren, sondern auch komplexe Zusammenhänge mit beeindruckender Genauigkeit erfassen und darauf reagieren. Dadurch sind sie äußerst vielseitigen Werkzeuge, die in einer Vielzahl von Anwendungsbereichen zum Einsatz kommen können.

Weitere Einzelheiten zu LLMs finden Sie in diesem Video von IBM gut erklärt zusammengefasst:

Die Vor- und Nachteile von LLMs im Vergleich zu traditionellen NLP-Modellen

Anknüpfend and die vielseitigen Fähigkeiten von LLMs stellt sich die Frage, wie sie im Vergleich zu traditionellen NLP-Modellen abschneiden. LLMs beeindrucken durch ihre Fähigkeit, komplexe Textanfragen zu verarbeiten und darauf zu reagieren. Sie sind wahre Multitasking-Werkzeug für alle Arten von Textverarbeitungsproblemen: Sie können zusammenfassen, übersetzen oder sogar an einer lockeren, virtuellen Unterhaltung teilnehmen. Dank ihrer sogenannten „emergenten“ Fähigkeit lassen sich mit etwas Kreativität zahlreiche weitere Aufgaben bewältigen. Diese Flexibilität macht sie in vielen Anwendungsbereichen attraktiv.

Im Gegensatz dazu sind traditionelle NLP-Modelle meist spezialisiert. Sie werden für spezifische Aufgaben wie Sentiment-Analyse, maschinelle Übersetzungen oder Textzusammenfassungen entwickelt und mithilfe annotierter, aufgabenspezifischer Daten optimiert.

Sowohl LLMs als auch traditionelle NLP-Modelle bieten Vorteile und Herausforderungen. Eine bewusste Abwägung ihrer Stärken und Schwächen ist entscheidend, um das passende Werkzeug für ein Projekt auszuwählen.

Vorteile und Nachteile von LLMs

| Vorteile | Nachteile |

| Hervorragendes Kontextverständnis | Oft nur über eine kostspielige API zugänglich (z.B. ChatGPT / GPT4o) |

| Multi-Tasking ohne zusätzliches Modell-Training oder –Finetuning (Zero- oder Few-Shot-Fähigkeit) | Betrieb In-house erfordert teure Hardware |

| Höchste Flexibilität | Hohe Latenzzeiten, besonders ohne leistungsstarke Infrastruktur |

| Geeignet für kreative oder offene Aufgaben (z. B. kreatives Schreiben) | Schwierigkeiten bei geschlossenen Ausgabeformaten, kann zu unerwünschten oder zu langen Ergebnissen/Antworten führen |

| Minimale Trainingsdaten für Finetuning erforderlich | Begrenzte Kontrolle über das Ausgabeformat |

| Effektiv bei unstrukturierten Textdaten | Möglicherweise wenig präzise bei spezialisierten oder Nischen-Anwendungsfällen |

| Neigung zu Halluzinationen (Produktion falscher oder unsinniger Informationen) | |

| Schwierig Evaluierung der Ergebnisse |

Vorteile und Nachteile traditioneller NLP-Modelle

| Vorteile | Nachteile |

| Ressourcenschonend in der Verarbeitung | Keine emergenten Fähigkeiten (Multi-Task-Fähigkeit ohne weiteres Training) |

| Schnellere Inferenzzeiten | Für jede neue Aufgabe muss ein eigenes Modell trainiert werden |

| Einfaches Selbst-Hosting und unkomplizierte Bereitstellung | Hoher Bedarf an aufgabenspezifischen Daten, um gute Ergebnisse zu liefern |

| Ideal für feste Ausgabeformate (z. B. Klassifizierung) | Weniger leistungsfähig bei Sprachgenerierung |

| Gut geeignet für strukturierte, sich wiederholende Aufgaben | |

| In-house-Training ohne übermäßige Ressourcen möglich | |

| Leichtere Anpassung an spezifische Anwendungsfälle oder Branchen |

Das Verständnis der Vor- und Nachteile von LLMs und traditionellen NLP-Modellen bildet die Grundlage, um die passende Technologie für Ihr Projekt auszuwählen. Doch wie lässt sich diese Erkenntnis praktisch anwenden?

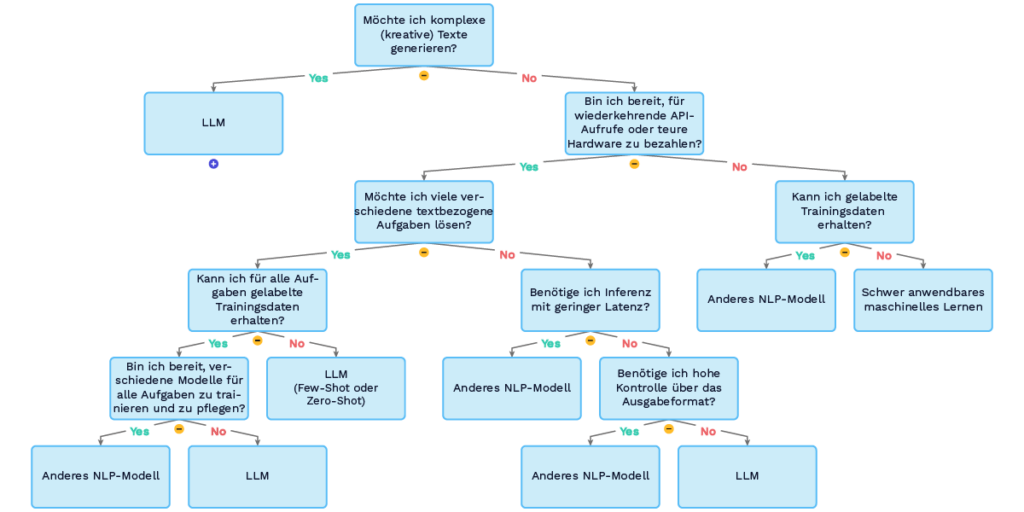

Der folgende Decision Guide bietet einen strukturierten Ansatz, um basierend auf den zuvor erläuterten Kriterien zu entscheiden, ob ein LLM oder eine andere NLP-Methode besser für Ihren Anwendungsfall geeignet ist.

Decision Guide: Sollten Sie ein LLM nutzen?

Der nachstehende Entscheidungsbaum hilft Ihnen, die wichtigsten Faktoren bei der Wahl der richtigen Technologie zu berücksichtigen. Er basiert auf den im vorigen Abschnitt beschriebenen Vor- und Nachteilen und führt Sie Schritt für Schritt durch zentrale Fragestellungen

Obwohl dieser Entscheidungsbaum einen hilfreichen Orientierungsrahmen bietet, deckt er nicht alle möglichen Anwendungsfälle oder Produktideen ab. Ebenso kann die Reihenfolge der Fragen je nach Kontext variieren In der Praxis sind viele Anwendungsfälle komplex und erfordern eine flexible Anpassung der Entscheidungslogik oder eine differenziertere Analyse. Der Baum dient daher als Ausgangspunkt, den Sie an Ihre spezifischen Anforderungen anpassen können.

Der folgende Abschnitt veranschaulicht die Anwendung des Entscheidungsbaums anhand von drei Anwendungsbeispielen.

Anwendung des Decision Guides Anhand von Drei Beispielen

Um die Anwendung des Entscheidungsbaums zu veranschaulichen, betrachten wir drei konkrete Szenarien:

Beispiel 1: Code Suggestion Tool

| Möchte ich komplexe (kreative) Texte generieren? → Ja |

| Entscheidung: Large Language Model (LLM) |

Erläuterung: Code Suggestion Tools nutzen in der Regel Quellcode als Eingabe und generieren hilfreiche Vorschläge für die nächsten Schritte. Diese Vorschläge sind sehr unterschiedlich und reichen von einem einzelnen Kommentar oder einer logischen nächsten Codezeile bis hin zu ganzen Funktionen oder Codeblöcken. Da diese Aufgabe die Generierung von komplexem Text (d. h. Quellcode) erfordert, ist ein LLM die richtige Wahl.

Beispiel 2: On-Device Themenklassifikation in einer Mobilen App

| Möchte ich komplexe (kreative) Texte generieren? → Ja |

| Bin ich bereit für wiederkehrende API-Aufrufe oder teure Hardware zu bezahlen? → Nein |

| Kann ich gelabelte Trainingsdaten erhalten? → Ja |

| Entscheidung: Traditionelle NLP-Methode (z.B. Encoder-basierter Transformer zur Klassifikation) |

Erläuterung: Themenklassifikation ist keine generative Aufgabe. LLMs sind zwar in der Lage, Themenklassifikation zu bewältigen, aber ihre Verwendung geht mit einem hohen Ressourcenbedarf einher. In diesem Beispiel gehen wir davon aus, dass annotierte Trainingsdaten zur Verfügung stehen. Daher eignet sich hier ein Encoder-basiertes Modell besser, da es effizienter arbeitet und weniger Ressourcen benötigt.

Beispiel 3: ASR Transcript Correction

| Möchte ich komplexe (kreative) Texte generieren? → Ja |

| Bin ich bereit für wiederkehrende API-Aufrufe oder teure Hardware zu bezahlen? → Ja |

| Möchte ich viele verschiedene textbezogene Aufgaben lösen? → Nein |

| Benötige ich Inferenz mit geringer Latenz? → Nein |

| Benötige ich hohe Kontrolle über das Ausgabeformat? → Ja |

| Entscheidung: Traditionelle NLP-Methode |

Erläuterung: Automatische Spracherkennungssysteme (ASR) produzieren manchmal fehlerhafte Transkripte. Die Herausforderung besteht darin, die fehlerhaften Wörter zu korrigieren, während der Rest des Textes unverändert bleibt. Es handelt sich also nicht unbedingt um eine generative Aufgabe, vielmehr kann sie als Klassifikationsproblem behandelt werden. In diesem Szenario gehen wir davon aus, dass wir bereit sind, für teure Hardware zu bezahlen, und dass wir keine niedrige Latenzzeit benötigen. LLMs bieten jedoch kein festes Ausgabeformat, und es ist schwierig, sie dazu zu bringen, die Generierung an einem bestimmten Punkt zu beenden. Dies könnte dazu führen, dass nicht nur das ASR-Transkript verbessert wird, sondern auch mehr unerwünschter Text erzeugt wird. Aus diesem Grund eignet sich ein Klassifizierungsmodell besser für diesen Anwendungsfall, da es präzise und kontrollierte Korrekturen ohne zusätzliche, unerwünschte Ausgabe gewährleistet.

Mehr als nur Text: Kann ein LLM bei Ihren Daten helfen?

LLMs sind beeindruckend, wenn es um die Verarbeitung von Text geht. Doch in der Praxis arbeiten viele Unternehmen mit unterschiedlichsten Datentypen – von Bildern und Audiodaten bis hin zu tabellarischen Informationen. Diese sogenannten Modalitäten erfordern spezialisierte Ansätze, da textbasierte Modelle wie LLMs oft an ihre Grenzen stoßen, wenn es um die Verarbeitung nicht-textueller Daten geht.

Obwohl die Forschung an multimodalen Modellen, die Text, Bild und Audio kombinieren, vielversprechend ist, befinden sich diese Technologien noch in einer experimentellen Phase. Für konkrete Anwendungsfälle ist es derzeit ratsamer, auf erprobte KI-Modelle zu setzen, die speziell für bestimmte Datentypen entwickelt wurden.

Der nachstehende Entscheidungsbaum bietet eine Orientierungshilfe für die Auswahl des geeigneten KI-Modells für verschiedene Datentypen.

Die Grafik verdeutlicht, dass LLMs nur eine von vielen KI-Technologien sind. Je nach Art der Daten sind verschiedene spezialisierte Lösungen, wie z. B. Convolutional Neural Networks (CNNs) für Bilder oder Recurrent Neural Networks (RNNs) für sequenzielle Daten, oft besser geeignet.

Interessanterweise wird auch in diesen Bereichen die Transformer-Architektur zunehmend eingesetzt, die ursprünglich die Grundage für LLMs bildete. Diese neuen Modelle bieten eine vielversprechende Weiterentwicklung. Allerdings unterscheiden sie sich in ihrer Optimierung stark von LLMs, da sie auf spezifische Aufgaben wie Bilderkennung oder Audioanalyse zugeschnitten sind.

Fazit: Die richtige Lösung für jede Modalität

Die Fähigkeit von LLMs, komplexe Textabfragen zu verarbeiten und darauf zu reagieren, macht sie zu vielseitigen Multi-Task-Werkzeugen für eine Vielzahl von Textverarbeitungsaufgaben. Wie in diesem Blogbeitrag erläutert, sind sie jedoch nicht für jeden Anwendungsfall die ideale Wahl. Trotz ihrer Leistungsfähigkeit bringen sie auch Einschränkungen mit sich.

Wenn Sie KI in ein Produkt oder einen Prozess integrieren möchten, ist es daher unerlässlich, auch alternative (Textverarbeitungs-)Lösungen in Betracht zu ziehen – insbesondere dann, wenn Sie mit nicht-textuellen Daten oder anderen Datenmodalitäten arbeiten. Für solche Fälle bieten spezialisierte Modelle oft effizientere und präzisere Ergebnisse.

Damit Sie eine fundierte Entscheidung treffen können, dient dieser Beitrag als eine Art Entscheidungshilfe für textuelle Daten. Mithilfe der enthaltenen Entscheidungsbäume können Sie die optimale Lösung für Ihren Anwendungsfall identifizieren. Für multimodale Daten verweisen wir auf den vorherigen Abschnitt und den Leitfaden zur KI-Bedarfsanalyse, den Sie am Ende dieses Beitrags herunterladen können.