Reinforcement Learning (RL) ist ein Teilgebiet des maschinellen Lernens, bei dem ein intelligenter Agent in einer Umgebung Entscheidungen trifft, um eine kumulative Belohnung zu maximieren. Im Gegensatz zu anderen Paradigmen des maschinellen Lernens werden die Trainingsdaten also in einem interaktiven Prozess der Erkundung und Nutzung erzeugt. Dieser Blogbeitrag erkundet den Workflow von RL für die Robotik, sowie exemplarische Anwendungsfälle und offene Herausforderungen in diesem Forschungsfeld für die Zukunft.

Workflow – Wie Roboter lernen zu Handeln

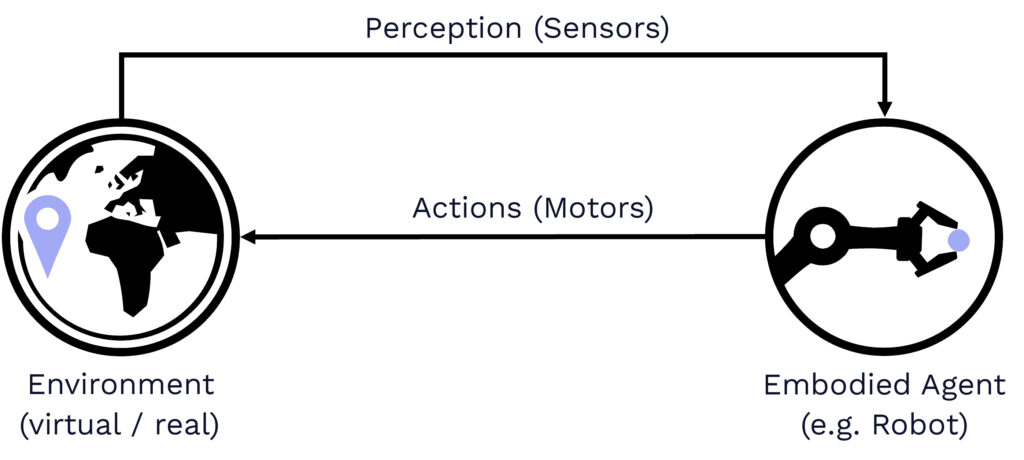

Der gesamte RL-Workflow kann als ein iterativer Lernprozess gesehen werden, der auf der sensomotorischen Aktivität eines Agenten mit einer Umgebung beruht (vgl. Abb. 1) – eine natürliche und sehr ähnliche Perspektive, wie auch wir Menschen lernen!

© Fraunhofer IML/ Julian Eßer

Umgebung: Der erste Schritt besteht darin, die Trainingsumgebung, häufig eine Simulationsumgebung, mit Spezifikationen für Aktionen, Beobachtungen und Belohnungen einzurichten. Im Kontext der Robotik bezieht sich der Beobachtungsraum typischerweise auf die verfügbaren Sensorquellen des realen Robotersystems und die gewünschten Steuerungseingaben. Während diskrete Aktionsräume oft in RL-Anwendungen zu finden sind, werden in der Robotik typischerweise kontinuierliche Aktionen bevorzugt, die z.B. Positions- oder Geschwindigkeitsziele umfassen. Da Robotik Aufgaben oft Einschränkungen entweder des physikalischen Systems (z.B. Gelenkgrenzen) oder eines gewünschten Verhaltensstils beinhalten, werden üblicherweise komplexe Belohnungsfunktionen verwendet, um gewünschte Verhaltensweisen zu erlernen.

Training: Der zweite Schritt von RL in der Robotik umfasst dann die Festlegung des eigentlichen Trainingsplans des Agenten. Obwohl es verschiedene Möglichkeiten zur Darstellung der endgültigen Strategie gibt, werden heutzutage in der Regel tiefe neuronale Netze für die Zustands-Aktions-Zuordnung verwendet, da sie mit Nichtlinearitäten umgehen können. Darüber hinaus wurde in den letzten Jahren ein breites Spektrum an potenziellen Algorithmen vorgeschlagen. Für die Steuerung von Robotern werden in der Regel modellfreie RL-Algorithmen verwendet, da sie kein wahrheitsgetreues Modell der Umgebung erfordern, das oft nicht zur Verfügung steht.

Deployment: Nachdem die trainierten Strategien in den virtuellen Trainingsumgebungen erfolgreich evaluiert wurden, ist es schließlich an der Zeit, sie auf das reale Robotersystem zu übertragen! Letztendlich hängt der Erfolg der Übertragung von vielen Faktoren ab, z. B. von der Kluft zwischen der virtuellen und der realen Welt, der Schwierigkeit der bevorstehenden Lernaufgabe oder der Komplexität der Roboterplattform selbst.

Anwendungen – RL für Robotik in der realen Welt

Reinforcement Learning wird derzeit auf eine Vielzahl von Roboterplattformen und -aufgaben angewendet. Vor allem lernbasierte Steuerungsansätze sind besonders vielversprechend, wenn es darum geht, schwer zu konstruierende Verhaltensweisen mit einem hohen Grad an Unsicherheit zu lösen – wie wir sie typischerweise in der realen Welt finden. Werfen wir also einen Blick auf drei sehr unterschiedliche Anwendungen der Anwendung von RL auf verschiedene reale Roboteraufgaben:

Fortbewegung: Einer der laufenden Forschungsbereiche im Bereich RL für die Robotik ist das Erlernen der dynamischen Fortbewegung. In diesem Fall steigt die Komplexität dieser Aufgabe nicht nur mit der Art der Roboterplattform, sondern auch mit dem zu durchquerenden Gelände. So kann die Fortbewegung eines vierrädrigen Roboters in flachem Gelände im Allgemeinen als recht einfache Aufgabe angesehen werden, während die Fortbewegung eines vierfüßigen Roboters in unwegsamem Gelände bereits mit mehr Freiheitsgraden und Unsicherheiten verbunden ist (siehe Abb. 2a). Doch selbst für einfache Roboterplattformen (wie einen vierrädrigen Roboter) in einfachen Umgebungen (z. B. flacher Boden), wie im ersten Beispiel zu sehen, steigt die Komplexität potenziell weiter an, wenn hochdynamische Bewegungen mit Drifts berücksichtigt werden, was die Modellierung aufgrund der größeren Lücke zwischen Simulation und Realität nochmals erschwert.

Manipulation: Ebenso kann auch der Bereich der Robotermanipulation von lernbasierten Steuerungsansätzen wie RL profitieren. Obwohl die Aufgabe, ein bestimmtes Objekt mit einer bestimmten Roboterplattform zu ergreifen, sicherlich nicht einfach ist, kann sie als lösbar angesehen werden, wenn sie in einer kontrollierten Umgebung eingesetzt wird. Wenn es jedoch darum geht, Objekte zu greifen und zu manipulieren, die vorher nicht bekannt sind und sich in Umgebungen befinden, die viele andere (dynamische) Objekte umfassen können (siehe Abb. 2c), können lernbasierte Ansätze einzigartige Möglichkeiten bieten. So könnten beispielsweise Bilddaten verwendet werden, um RL-Agenten zu trainieren, die die Szene auf menschenähnliche Weise verstehen können, um optimierte Entscheidungen zu treffen.

Navigation: Eine weitere Anwendung von RL in der Robotik ist der Bereich der Navigation, bei der es nicht nur um die sensorische Wahrnehmung der Umgebung geht, sondern auch um übergeordnete Überlegungen zu den zu treffenden Entscheidungen. Auch hier kann RL seine Stärken ausspielen, da sich die Umgebungen als schwierig zu modellieren erweisen. So kann beispielsweise die Aufgabe, sich in einer statischen Umgebung zurechtzufinden, die a priori bekannt ist, als relativ einfach angesehen werden. Wenn es jedoch darum geht, eine Drohne schnell in einer unbekannten Umgebung zu navigieren (siehe Abb. 2b), die sogar dynamische Hindernisse (z. B. andere Roboter) enthalten kann, steigt der Grad der Ungewissheit beträchtlich an – was dies wiederum zu einem perfekten Anwendungsgebiet für RL macht.

Herausforderungen – Der Weg in die Zukunft der Robotik

Obwohl bereits vielversprechende Anwendungen das Potenzial von Reinforcement Learning für die Robotersteuerung gezeigt haben, bestehen besondere Herausforderungen im Zusammenhang mit dem Training von Robotern für reale Aufgaben.

1. Performance (Effektivität):

Eine der aktuellen Herausforderungen bei der Anwendung von RL auf die Robotik besteht darin, das gewünschte Leistungsniveau der trainierten Agenten zu erreichen. Einer der Gründe dafür ist, dass RL als datengesteuerter Ansatz empfindlich auf eine bestimmte Auswahl von Hyperparametern reagiert. Aber selbst bei der exakt gleichen Auswahl von Hyperparametern kann der Gesamtertrag beim Training aufgrund von wechselnden Zufallsfaktoren in der Umgebung unterschiedlich ausfallen. Ein weiterer Teil der Herausforderung besteht darin, dass RL dazu neigt, je nach Belohnungsformulierung in lokale Minima vorzudringen. Lokale Minima können beispielsweise durch die Ausnutzung falsch spezifizierter dichter Belohnungen erreicht werden, während im Falle spärlicher Belohnungen die Konvergenz zu leistungsfähigen Policies noch schwieriger sein kann.

2. Datenmenge (Effizienz):

Eine weitere zentrale Herausforderung bei der Anwendung von RL auf die Robotik ist die Tatsache, dass RL typischerweise Millionen von Interaktionen mit der Umgebung benötigt, um zu konvergieren, was in der realen Welt unpraktisch ist. Obwohl in den letzten Jahren verschiedene Arten von RL-Algorithmen vorgeschlagen wurden, wie z. B. verschiedene Off- und On-Policy-Algorithmen oder sogar modellbasierte Algorithmen, ist das Problem der hohen Stichprobenkosten und der rechnerischen Auslastung noch lange nicht gelöst. Um diese Lücke zu schließen, werden häufig Simulationsumgebungen eingesetzt, um virtuelle Trainingsumgebungen für die RL-Agenten bereitzustellen.

3. Sim-to-Real Gap:

Simulationsumgebungen werden in der Robotik häufig eingesetzt, um schnell, sicher und skalierbar Trainingsmuster für Roboteraufgaben zu erstellen. Da es sich bei Simulationen jedoch um Abstraktionen vom realen Roboter und der realen Welt handelt, wird es immer einen Unterschied zwischen diesen beiden Welten geben – auch bekannt als Simulations-Realitäts-Gap. So hängt beispielsweise das physikalische Verhalten des Roboters in der Simulation stark von der Qualität der Modellierung der Kinematik, Dynamik, Aktuatoren usw. ab. Auch die Wahrnehmung der Umgebung in der Simulation ist Teil der Simulations-Realitätslücke, da der Realismus stark von den verwendeten Sensormodellen abhängt. Schließlich sind auch Verzögerungen bei der Kommunikation sowie Hardwareausfälle typisch für reale Robotersysteme und tragen zur Lücke zwischen Simulation und Realität bei der Anwendung von RL auf den Bereich der Robotik bei.

Zusammenfassung

In diesem Blogbeitrag haben wir das Potenzial von RL für die Steuerung von Robotern erkundet. Insbesondere haben wir gesehen, wie ein typischer Arbeitsablauf für die Anwendung von RL in der Robotik aussieht und dass es für eine Vielzahl von Anwendungsfällen geeignet ist. Wir haben jedoch auch gesehen, dass die Robotik in diesem Bereich ihre eigenen Herausforderungen und Komplexitäten mit sich bringt. Wie können wir Strategien für die Robotersteuerung effizient und effektiv trainieren, so dass sie sich erfolgreich auf das reale Robotersystem übertragen lassen? Einen möglichen Weg zu diesem Ziel werden wir im nächsten Blogbeitrag untersuchen – bleiben Sie dran …