Im ersten Beitrag unserer Blogpost-Reihe über Guided Reinforcement Learning (RL) haben wir bereits das Potenzial von RL für den Bereich der Robotik gesehen und wie es sich als leistungsfähiges Tool zum Erlernen der Robotersteuerung erweist. Da es sich jedoch in erster Linie um einen datengesteuerten Ansatz handelt, ist es schwierig, Trainingsdaten effizient zu sammeln und zu nutzen sowie effektive Strategien für den Einsatz in der realen Robotik zu trainieren. Ein möglicher Weg zur Überwindung dieser Herausforderungen ist die Integration von zusätzlichem Wissen und die Kombination der Stärken von daten- und wissensbasierten Ansätzen (mehr dazu finden Sie in unserem Blogbeitrag Informed Machine Learning – Aus Daten und Vorwissen lernen). Dieser Blogbeitrag beschreibt die Idee hinter dem Konzept des Guided Reinforcement Learning und gibt dabei Einblicke in die generelle Pipeline, eine neuartige Taxonomie und die Ergebnisse der Evaluierungsstudie.

Pipeline – Integration von Wissen in das Training

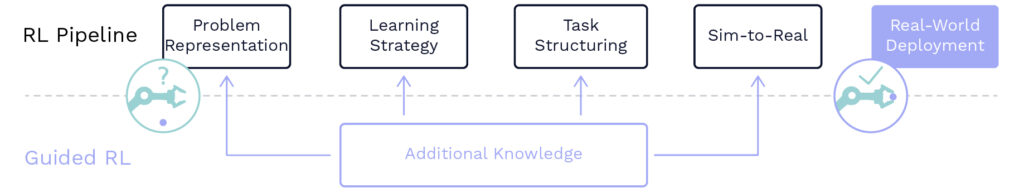

Das Wissen selbst kann auf verschiedenen Ebenen der RL-Pipeline integriert werden (vgl. Abb. 1). Zum Beispiel könnte es im Kern der Lernproblemformulierung integriert werden, nämlich in der Repräsentation der Beobachtungs- oder Aktionsräume des Agenten, wie beispielsweise einer Roboterhand. Darüber hinaus könnte zusätzliches Wissen auch in die Lernstrategie selbst oder durch die Bereitstellung von zusätzlichem Kontext und Struktur für die bevorstehende Lernaufgabe integriert werden. Wird schließlich eine Simulationsumgebung für die Erzeugung synthetischer Trainingsdaten verwendet, sind die trainierten Strategien wahrscheinlich mit der Kluft zwischen Simulation und Realität konfrontiert. Zu diesem Zweck kann zusätzliches Wissen integriert werden, um diese Lücke weiter zu verkleinern, damit die trainierten RL-Strategien in der realen Welt eingesetzt werden können.

© Fraunhofer IML

Taxonomie – Eine modulare Toolbox für Reinforcement Learning

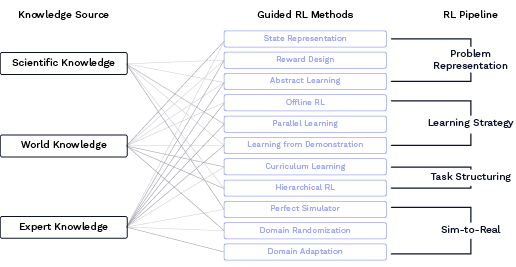

Mit der Idee des Guided RL im Hinterkopf könnte man sich fragen, wie man die Idee der Integration von zusätzlichem Wissen praktisch anwenden kann, um intelligentes Verhalten für einen Roboter in der realen Welt zu trainieren. Zu diesem Zweck wurde eine neuartige Taxonomie (siehe Abb. 2) entwickelt, die einen strukturierten Überblick darüber gibt, welche Arten von Wissen hilfreich sein können (Knowledge Sources), welche spezifischen Methoden verwendet werden können (Guided RL Methods) und wo diese praktisch in die Lernpipeline integriert werden können (RL-Pipeline). Drei Arten von Vorwissen bilden die Grundlage für die meisten Guided-RL-Methoden, nämlich wissenschaftliches Wissen (z. B. algebraische Gleichungen), Weltwissen (z. B. Fakten aus dem Alltag) und Expertenwissen (z. B. Hyperparameter-Tuning). Diese Wissensquellen können mittels verschiedener Guided-RL-Methoden in die RL-Pipeline integriert werden, wie im Folgenden skizziert wird. Die Formulierung des Lernproblems kann in hohem Maße von Expertenwissen profitieren, z. B. durch eine sorgfältige Auswahl des beobachtbaren Raums, der Aufstellung einer komplexen Belohnungsfunktion oder die Bereitstellung abstrahierter Aktionsräume für den RL-Agenten. Ebenso kann die algorithmische Formulierung der Lernstrategie von der Intuition der Experten profitieren, z. B. durch die Auswahl eines Datensatzes zum Trainieren, den Entwurf parallelisierter Lernverfahren oder die Integration von Demonstrationsdaten in den Lernprozess. Darüber hinaus hat das Weltwissen in der Regel einen starken Bezug zur Strukturierung der bevorstehenden Lernaufgabe, z. B. durch das Lernen immer komplexerer Aufgaben oder die Aufteilung einer großen Aufgabe in mehrere Teilaufgaben, die nacheinander gelernt werden. Um schließlich die Kluft zwischen Simulation und Realität zu überbrücken, können verschiedene Wissensquellen nützlich sein, um die Systemmodelle zu verbessern, die Umgebungen zu randomisieren oder Anpassungsmodelle zu entwerfen, um den Realismus der simulierten Trainingsumgebungen zu erhöhen. Durch die Bereitstellung eines strukturierten Überblicks kann diese Taxonomie als ein modularer Werkzeugkasten betrachtet werden und wird hoffentlich den Forschenden bei der Auswahl geeigneter Methoden für ihre spezifischen Lernprobleme helfen.

©Fraunhofer IML

Evaluation – Wann welche Methoden anzuwenden sind

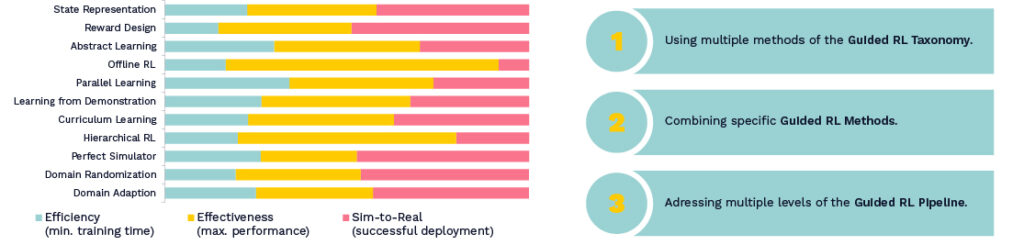

Ausgehend von der Motivation, gleichzeitig die Effizienz, Effektivität und den Simulation-to-Reality (Sim-to-Real) Transfer des Lernprozesses zu verbessern, wurde eine Evaluationsstudie über mehr als 100 aktuelle Forschungsarbeiten durchgeführt, um die Wirkung der entsprechenden Guided-RL-Methoden quantitativ zu analysieren. Basierend auf der vorgestellten Taxonomie wurden alle vorgestellten Guided-RL-Methoden analysiert und normalisiert, um ihren relativen Beitrag (siehe Abb. 3, links) zur Reduzierung der Trainingszeit (Effizienz), zur Verbesserung der Policy-Performance (Effektivität) und zur erfolgreichen Übertragung einer Policy auf den realen Roboter (Sim-to-Real) aufzuzeigen. Insgesamt lassen sich die Ergebnisse dieser Evaluierungsstudie in drei wesentlichen Erkenntnissen zusammenfassen (siehe Abb. 3, rechts), die im Folgenden kurz erörtert werden. Erstens wurde festgestellt, dass die Verwendung mehrerer Methoden der Guided-RL-Taxonomy dazu beitragen kann, gleichzeitig die Effizienz, Effektivität und Sim-to-Real zu verbessern. Zweitens stellt sich heraus, dass nicht nur die Anzahl der verwendeten Methoden wichtig ist, sondern sich auch die Wirkungen der eingesetzten Methoden in bestimmten Kombinationen gegenseitig verstärken. So lassen sich beispielsweise positive Korrelationen zwischen Domänenanpassung und Domänenrandomisierung für den Sim-to-Real-Transfer und zwischen parallelem Lernen und Domänenrandomisierung für die datengesteuerte Skalierbarkeit feststellen. Schließlich stellt sich heraus, dass die Nutzung mehrerer Ebenen der Guided-RL-Pipeline ein effizienteres und effektiveres Training für den Einsatz in der realen Robotik ermöglichen kann.

© Fraunhofer IML

Zusammenfassung

Zusammenfassend kann man sagen, dass es drei wichtige Erkenntnisse gibt, die im Zusammenhang mit Guided RL betrachtet werden können. Erstens, die allgemeine Idee der Integration von zusätzlichem Wissen in den Trainingsprozess als Weg zu dateneffizientem und effektivem Roboterlernen. Zweitens die Guided-RL-Taxonomie, die als modularer Werkzeugkasten für die Integration verschiedener Wissensquellen in die Trainingspipeline angesehen werden kann. Und schließlich hat die Evaluierungsstudie in praktischer Hinsicht gezeigt, dass der Einsatz mehrerer Guided-RL-Methoden, die Kombination spezifischer Methoden und die Nutzung mehrerer Ebenen der Guided-RL-Pipeline gleichzeitig die Effizienz und Effektivität des Einsatzes trainierter RL-Policies in der realen Welt verbessern können.

Für weitere Details zum methodischen Ansatz, einen umfassenden Überblick über den Stand der Technik sowie zukünftige Herausforderungen und Richtungen wird der interessierte Leser auf die entsprechende Veröffentlichung im IEEE Robotics and Automation Magazine (IEEE-RAM) verwiesen, die unter folgendem Link verfügbar ist (Open-Access): Guided Reinforcement Learning: A Review and Evaluation for Efficient and Effective Real-World Robotics | IEEE Journals & Magazine | IEEE Xplore

Im nächsten Blog-Beitrag werden wir untersuchen, wie Guided RL praktisch angewendet werden kann, indem wir die erste reale Robotik-Herausforderung diskutieren: Lernen der dynamischen Fortbewegung für einen zweirädrigen Roboter! Bleiben Sie dran …