In den vorangegangenen Blogposts der Reihe RL für Robotik haben wir bereits das Konzept des Guided RL erkundet und seine wichtigsten Merkmale anhand von drei verschiedenen Roboteraufgaben diskutiert. Insbesondere haben wir die Guided RL Taxonomie vorgestellt – eine modulare Toolbox zur Integration verschiedener Wissensquellen in die RL Pipeline. In diesem Blogbeitrag geht es nun um den ersten praktischen Einsatz von Guided RL in einer realen Roboteraufgabe: Lernen der dynamischen Fortbewegung für einen zweirädrigen Roboter – am Beispiel des evoBOT.

evoBOT – Eine Forschungsplattform für Hochdynamische Bewegungen

© Fraunhofer IML

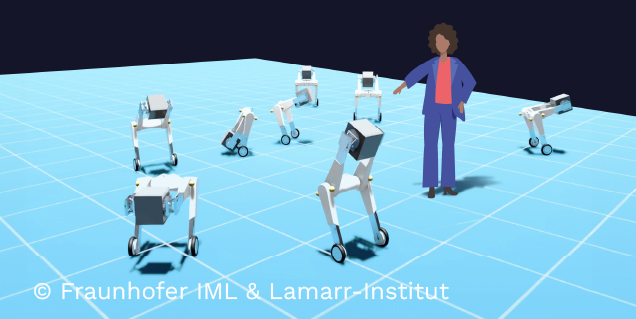

Der am Fraunhofer IML entwickelte evoBOT ist ein dynamisch stabiles System, das auf dem Prinzip eines inversen Verbundpendels basiert (siehe Abbildung 1). Im Gegensatz zu konventionellen Robotern benötigt dieses System kein externes Gegengewicht, um sein Gleichgewicht zu halten. Das einzigartige Design des evoBOT ermöglicht es ihm, sich selbst immer im Gleichgewicht zu halten, was es dem Roboter ermöglicht, auf unterschiedlichen und unebenen Oberflächen zu navigieren, selbst wenn es Schrägen gibt. Die kompakte und leichte Bauweise des evoBOT erhöht seine Vielseitigkeit und Mobilität zusätzlich. Dank seiner hohen Agilität und Flexibilität eignet sich das System für ein breites Spektrum von Anwendungen, einschließlich kollaborativer Aufgaben, die über den traditionellen Logistikkontext hinausgehen. Als modulares System kann der evoBOT an spezifische Anforderungen angepasst werden, und seine Anpassungsfähigkeit macht ihn für den Einsatz in komplexen städtischen Umgebungen geeignet.

Im Gegensatz zu bestehenden Lösungen, die sich auf einfache Tätigkeiten wie das Schieben und Ziehen von Logistikgütern beschränken, bietet der evoBOT eine breite Palette von Funktionen, die je nach Bedarf kombiniert und erweitert werden können. Zu diesen Funktionen gehört die Fähigkeit, Objekte zu handhaben, zu transportieren und zu drehen. Das bio-inspirierte Design des Systems erhöht zudem die Benutzerfreundlichkeit und senkt die Hemmschwelle für die Interaktion zwischen Mensch und Roboter. Aufgrund seiner vielen Vorteile kann der evoBOT als persönlicher Assistent für Menschen in einer Vielzahl von Situationen dienen. Aufgrund seiner einzigartigen Eigenschaften und Funktionen eignet er sich gut für den Einsatz in Umgebungen, in denen herkömmliche Roboter möglicherweise nicht effektiv arbeiten können. Daher hat der evoBOT das Potenzial, die Art und Weise, wie Menschen mit Technologie interagieren, zu verändern und zur Entwicklung neuer Anwendungen und Einsatzmöglichkeiten für die Robotik beizutragen.

Guided RL Taxonomie – Auswahl von Methoden für den Anwendungsfall

Wir untersuchen lernbasierte Steuerungsansätze für die Aufgabe der dynamischen Fortbewegung des evoBOT. Insbesondere soll das zugrunde liegende neuronale Netz geeignete Radgeschwindigkeiten berechnen, um vorgegebene Geschwindigkeitsbefehle des Roboters zu erreichen. In Anlehnung an die Taxonomie von Guided RL (siehe vorherigen Blog-Beitrag) wird eine spezifische Kombination verschiedener Guided RL-Methoden eingesetzt, um das Training zu beschleunigen und den Erfolg für die reale Robotikanwendung zu verbessern (siehe Abbildung 2).

- Reward Design: Um das gewünschte Verhalten des gelernten Bewegungsreglers zu kodieren, verwenden wir eine dichte Belohnungsfunktion. Insgesamt besteht diese Funktion aus mehreren Optimierungskriterien, darunter Belohnungen für die Verfolgung der linearen und der Winkelgeschwindigkeit sowie Bestrafungen für das Herunterfallen, schnelle Änderungen und den Energieverbrauch.

- Parallel Learning: Für das simulationsbasierte Training von Steuerungsstrategien verwenden wir Isaac Gym, ein neueres GPU-basiertes Physiksimulations-Framework für das Roboterlernen. Dank des effizienten Parallelisierungsschemas von Isaac Gym sammeln wir Erfahrungen mit einer Gesamtzahl von 4096 Roboterinstanzen, die gleichzeitig trainiert werden.

- Curriculum Learning: Um das Training zu beschleunigen, erforschen wir das schrittweise Erlernen der Aufgabe. Insbesondere erhöhen wir die gewünschten Geschwindigkeitsbefehle, die der Roboter auf lineare Weise erreichen soll, so dass die Fortbewegungsaufgabe zunächst in das Erlernen des Gleichgewichts des Roboters und dann in die langsame Bewegung mit immer höheren linearen und winkligen Geschwindigkeiten zerlegt wird.

- Perfect Simulator: Um die Lücke zwischen Simulation und Realität zu verringern, erstellen wir ein physikalisch optimiertes Simulationsmodell des evoBOT-Roboters (siehe Abbildung 1). Zu diesem Zweck werden die Massen und Trägheitstensoren anhand eines genauen CAD-Modells mit mehr als 300 Einzelteilen und den entsprechenden physikalischen Eigenschaften neu berechnet. Außerdem werden physikalische Gelenkgrenzen in das Simulationsmodell aufgenommen, die auf Messungen am realen Roboter basieren.

- Domain Randomization: Um die verbleibenden Unsicherheiten im Simulationsmodell zu berücksichtigen, werden die Simulationsumgebungen randomisiert. Diese Randomisierung umfasst insbesondere die Roboterdynamik (z. B. Verbindungsmassen, Motorparameter), Verzögerungen in der Kommunikationspipeline sowie das aus realen Messungen geschätzte Sensorrauschen.

© Fraunhofer IML

Experimentelle Ergebnisse – Performance bei dynamischer Fortbewegung

Wir trainieren eine einzige Regelungsstrategie sowohl für das robuste Balancieren als auch für die dynamische Fortbewegung mit bis zu 1m/s des evoBOT-Roboters. Abbildung 3 zeigt die resultierende Verfolgungsleistung einer trainierten Richtlinie für kombinierte Balancierung und dynamische Fortbewegung des evoBOT. Das Experiment umfasst mehrere Phasen mit erhöhtem Dynamikgrad. In Phase I (0-2 s) wird die Strategie aufgefordert, sich selbst aus einer schwierigen anfänglichen Neigungsposition von bis zu 30 Grad zu balancieren. Phase II (2-6 s) besteht aus abwechselnden linearen Geschwindigkeitsbefehlen von ±0,5 m/s, während Drehgeschwindigkeiten von bis zu ±1 rad/s gefordert werden. In Phase III (6-10 s) ändern sich sowohl die linearen als auch die winkligen Geschwindigkeitsbefehle augenblicklich, bevor sie wieder zum dynamischen Ausgleich zurückkehren. Wie die Ergebnisse zeigen, lernt die Strategie, auf die vorgegebenen Geschwindigkeitsziele hochdynamisch zu reagieren und dabei an den physikalischen Grenzen des Systems zu operieren. Einerseits muss der Roboter, um solche schnellen Änderungen der linearen Geschwindigkeit zu realisieren, zunächst in die entgegengesetzte Richtung beschleunigen, um das notwendige Kippmoment zu erzeugen. Andererseits lernt die Strategie, die durch die Motordynamik gegebenen Grenzen des physisch eingeschränkten Roboters auszunutzen, indem sie sowohl die Höchstgeschwindigkeit als auch die Beschleunigungsgrenzen erreicht.

Mitte: Output des neuronalen Netzes auf Motorebene, Unten: Einsatz der trainierten Regeln für eine Fortbewegungsaufgabe auf flachem Boden, unebenem Gelände und gestreckten Armen (von links nach rechts).

© Fraunhofer IML

Zusammenfassung

In diesem Blogbeitrag haben wir die Anwendung von Guided RL auf die Aufgabe des Erlernens dynamischer Fortbewegung für evoBOT, einer neuartigen Roboterplattform zur Erforschung hochdynamischer Fortbewegung, behandelt. Insbesondere haben wir die ausgewählten Guided-RL-Methoden für diesen Anwendungsfall überprüft und die Gesamtleistung des lernbasierten Controllers diskutiert.

Wenn Sie sich für die Roboterplattform interessieren, können Sie sich das evoBOT Simulationsmodell ansehen (als Open-Source verfügbar) oder unser Entwicklungsteam direkt kontaktieren.

Für weitere Details zum methodischen Ansatz und ein umfassendes Sim-to-Real-Benchmarking finden Sie hier einen Link zur entsprechenden Veröffentlichung, die dieses Jahr auf der IEEE International Conference on Intelligent Robots and Systems (IROS) vorgestellt wurde.

P. Klokowski et al., „evoBOT – Design and Learning-Based Control of a Two-Wheeled Compound Inverted Pendulum Robot,“ 2023 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS), Detroit, MI, USA, 2023, pp. 10425-10432, doi: 10.1109/IROS55552.2023.10342128, Link.