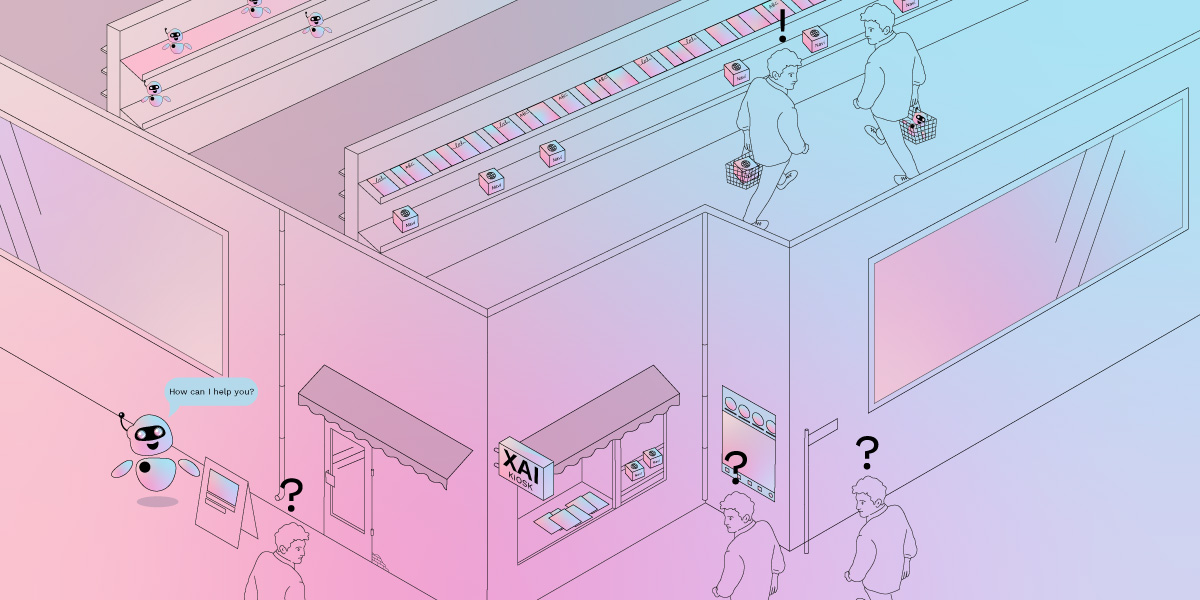

Mithilfe von Methoden der erklärbaren Künstlichen Intelligenz (XAI, Explainable AI) können Entwickler*innen die Ergebnisse von KI-Anwendungen besser nachvollziehbar machen. Auch wenn sich XAI-Methoden bislang in erster Linie an Fachexpert*innen richten, hat eine Fach-AG des ZVKI festgestellt: Erklärbare KI kann – in Verbindung mit weiteren Maßnahmen – auch für die Aufklärung von Verbraucher*innen einen Mehrwert haben.

Verbraucher*innen nutzen täglich Anwendungen, die auf KI-Methoden basieren – ob Social Media-Plattformen, KI-gestützte Chatbots, die Gesichtserkennung auf ihrem Smartphone oder Navigationssysteme. Auch wenn Bürger*innen und Verbraucher*innen KI-Systeme nicht selbst anwenden, können sie von deren Ergebnissen betroffen sein: Beispielsweise, wenn große Unternehmen KI-Tools zur Filterung von Bewerbungsunterlagen einsetzen oder Versicherungen mithilfe von KI-Systemen das Risiko einer bestimmten Erkrankung berechnen.

Wenn der Einsatz eines KI-Tools Einfluss auf das Leben von Verbraucher*innen nimmt, sollten Unternehmen und öffentliche Stellen diese über den KI-Einsatz informieren. Darüber hinaus sollten Bürger*innen auch darüber aufgeklärt werden, wie die jeweiligen Ergebnisse einer KI-Anwendung zustande gekommen sind. Nur so haben Bürger*innen die Möglichkeit, eine „ungerechtfertigte Benachteiligung“, wie eine KI-vermittelte Diskriminierung, zu erkennen und gegen diese vorzugehen (Baeva, Binder, 2023). Zudem sollten auch Verbraucherschutzzentralen und weitere zivilgesellschaftliche Organisationen Informationen zur Nachvollziehbarkeit von KI-Anwendungen erhalten, da insbesondere KI-vermittelte Diskriminierung anhand von Einzelfällen schwierig festzustellen ist (Baeva, Binder, 2023).

Erklärbare KI zur besseren Nachvollziehbarkeit von KI-Ergebnissen

KI-Systeme sind jedoch häufig so komplex, dass Entwickler*innen und Nutzer*innen deren Ergebnisse und Vorgehensweisen nicht nachvollziehen können. Daher werden diese KI-Anwendungen auch als Black-Box-Modelle bezeichnet. Im Forschungsbereich der erklärbaren KI forschen Wissenschaftler*innen an Erklärmethoden, die zeigen, welche Daten oder Annahmen zu einem bestimmten Ergebnis einer KI-Anwendung geführt haben. Dies lässt sich gut anhand einer Counterfactual Explanation verdeutlichen: Eine Counterfactual Explanation beschreibt die Umstände, unter denen das Ergebnis einer KI-Anwendung anders ausgefallen wäre.

Hierzu ein Beispiel: Ein Unternehmen nutzt ein KI-System, um eingehende Bewerbungen hinsichtlich ihrer Eignung für eine Stelle zu sortieren. Die Bewerbung einer Person wird durch die KI-Anwendung als ungeeignet eingestuft. Eine Counterfactual Explanation analysiert, welche Faktoren sich ändern müssten, damit das KI-System ein positives Ergebnis für diese*n Bewerber*in ausgibt. Das kann zum Beispiel die Berufserfahrung sein: Hätte die Person zehn statt neun Jahre Berufserfahrung vorweisen können, hätte die KI-Anwendung den*die Bewerber*in als passend eingestuft.

Erklärmethoden und die Nachvollziehbarkeit von KI-Ergebnissen können zu einer größeren Transparenz von KI-Anwendungen beitragen. Welcher Grad an Transparenz für bestimmte KI-Systeme überhaupt notwendig ist, ist laut Deutschem Ethikrat (2023) abhängig vom jeweiligen Anwendungsbereich. Für manche Kontexte sollte ein Höchstmaß an Erklärbarkeit durch Explainable AI sichergestellt werden, in anderen Bereichen könnte hingegen eine menschliche „Plausibilitätsprüfung“ der KI-Ergebnisse ausreichen. Eine vollumfängliche Transparenz sogenannter Black-Box-Modelle ist aktuell jedoch „weder für Lai*innen noch für Expert*innen“ herstellbar (Baeva, Binder, 2023). Ist eine solche Transparenz für einen bestimmten Anwendungsbereich erforderlich, müsste in diesem Fall daher ganz auf den Einsatz eines komplexen KI-Systems verzichtet werden.

Dennoch können Methoden der erklärbaren KI die Nachvollziehbarkeit von KI-Ergebnissen maßgeblich erhöhen. Aktuell richten sich diese Methoden vor allem an Entwickler*innen und Fach-Expert*innen. Unter bestimmten Bedingungen eignen sich XAI-Methoden jedoch auch, um die Ergebnisse von Systemen für Verbraucher*innen nachvollziehbarer zu machen – zu diesem Schluss kam eine Facharbeitsgruppe des Zentrums für vertrauenswürdige Künstliche Intelligenz (ZVKI) (Busse, 2022).

Unter welchen Bedingungen hat erklärbare KI einen Mehrwert für die Aufklärung von Verbraucher*innen?

Erklärmethoden können Verbraucher*innen helfen, die Ergebnisse von KI-Anwendungen besser nachzuvollziehen. Werden KI-Anwendungen beispielsweise zur Unterstützung bei der Kreditvergabe eingesetzt, können Counterfactual Explanations den konkreten Einfluss bestimmter Faktoren auf das Ergebnis eines KI-Systems darstellen. Betroffene können so unter anderem nachvollziehen, ob zum Beispiel ihr Gehalt, Wohnort oder Alter zu einer Kreditabsage geführt haben.

Niedrigschwellige Darstellung

Damit der Einsatz von XAI-Methoden zur Aufklärung von Verbraucher*innen beiträgt, müssen diese niedrigschwellig aufbereitet sein. Ein Beispiel wäre ein interaktives, digitales Eingabeformular, in dem die Nutzer*innen die Eingabedaten wie Alter, Wohnort oder Gehalt beliebig ändern können. Auf diese Weise können sie nachvollziehen, welche Faktoren Einfluss auf das Ergebnis der KI-Anwendung und damit auf die Chancen zur Gewährung eines Kredits haben – auch wenn sie nicht über Fachwissen zur Funktionsweise der KI-Anwendungen verfügen. Um einen Mehrwert der Erklärungen für Verbraucher*innen sicherzustellen, müssen die Erklärungen mit und von Nutzer*innen evaluiert werden.

Erklärbarkeit benötigt Korrigierbarkeit

Zudem sollten Verbraucher*innen die Eingaben und/ oder Ergebnisse von KI-Anwendungen korrigieren können. Die Korrigierbarkeit betrifft drei verschiedene Ebenen:

- Eingabedaten: Verbraucher*innen können falsche Eingaben richtigstellen. Das betrifft zum Beispiel die Eintragung eines falschen Alters bei einem KI-System, das Bankangestellte als Unterstützung bei der Kreditwürdigkeitsprüfung einsetzen. Erklärungen durch XAI-Methoden sollten solche falschen Eingabedaten offenlegen und eine Korrektur ermöglichen.

- Personalsierung: Nutzer*innen können die Ergebnisse einer KI-Anwendung personalisieren, beispielsweise beim News Feed einer Social-Media-Anwendung. Eine mögliche Personalisierung erhöht die Benutzer*innen-Freundlichkeit solcher Anwendungen.

- Kontrollfunktion: Verbraucher*innen ist es möglich, sich über die Ergebnisse eines KI-Systems bei unabhängigen Stellen zu beschweren, beispielsweise bei einem Verdacht auf Diskriminierung durch eine Gesichtserkennungssoftware oder bei einer Entscheidung zur Kreditvergabe. Zudem erhalten auch Forschungsinstitute, Antidiskriminierungsstellen oder Nichtregierungsorganisationen Zugang zu den Datengrundlagen von KI-Systemen und Erklärungen durch XAI-Methoden. Nur so können zivilgesellschaftliche Organisationen ihre gesellschaftliche Kontrollfunktion wahrnehmen und KI-vermittelte Diskriminierungen aufdecken, die Einzelpersonen nicht identifizieren können.

Erklärungen sollten um Handlungsempfehlungen ergänzt werden

Erklärungen auf der Grundlage von XAI-Methoden an sich geben Verbraucher*innen keine ausreichenden Handlungsoptionen. Daher sollten Anbieter*innen von KI-Systemen Verbraucher*innen ergänzend zu einer Erklärung darüber informieren, was sie selbst ändern können, damit das KI-System ein anderes Ergebnis ausgibt. Entscheidend ist dabei, dass die Handlungsempfehlung realisierbar ist. Im Fall der Kreditvergabe kann es für Bewerber*innen beispielsweise hilfreich sein, zu wissen, ob bereits eine geringfügige Gehaltssteigerung ausreicht, damit ihnen ein Kredit gewährt wird. Die Empfehlung, das eigene Alter zu ändern, ergibt dagegen wenig Sinn. Die Umsetzung von Handlungsempfehlungen ist nicht allen Menschen im gleichen Maß möglich, sondern hängt von gesamtgesellschaftlichen Faktoren und Machtstrukturen ab: So ist es je nach Beruf und Anstellungsverhältnis beispielsweise nur manchen Menschen möglich, ein höheres Gehalt auszuhandeln. Auch solche Faktoren sollten bei der Formulierung von Handlungsempfehlungen berücksichtigt werden.

XAI-Methoden und Erklärformate müssen sich je nach Anwendung und Kontext unterscheiden

Je nach Anwendungsfall kann eine Kombination von mehreren XAI-Methoden und Darstellungen hilfreich sein, um KI-Ergebnisse nachvollziehbarer zu machen. Entscheidend ist, dass sich die Erklärungen nicht widersprechen. Manche Informationsbedarfe von Verbraucher*innen werden außerdem besser durch andere Formate als durch Darstellungen von XAI-Methoden abgedeckt: Unternehmen könnten Informationen zu den gespeicherten Daten der Nutzer*innen einer Gesundheits-App beispielsweise als grafisch aufbereitete Übersicht bereitstellen. Das kann bereits dabei helfen, Fehler oder falsche Angaben in den gesammelten Informationen zu erkennen und gegebenenfalls zu beanstanden. Für eine solche Darstellung sind keine XAI-Methoden notwendig.

Erklärung gut, alles gut?

Erklärungen zum Einsatz und zu den Ergebnissen von KI-Systemen ermöglichen Verbraucher*innen, KI-Anwendungen selbstbestimmer und souveräner zu nutzen. Zudem können sie so besser gegen nachteilige oder falsche Entscheidungen vorgehen, die beispielsweise Arbeitgeber*innen, Mediziner*innen oder öffentliche Stellen auf der Grundlage von KI-Ergebnissen getroffen haben.

Entsprechend den Empfehlungen der ZVKI-Fach-AG „Verbraucher*innen-Information“ (Busse, 2023) sind Unternehmen – als KI-Anbieter*innen – für die Umsetzung und Nachvollziehbarkeit von Erklärmaßnahmen hauptverantwortlich. Wissenschaftler*innen sollten weiterhin an zuverlässigen XAI-Methoden forschen und in Forschungsvorhaben einen interdisziplinären Ansatz verfolgen, um nicht rein technische, sondern am Menschen orientierte Erklärungsansätze zu erarbeiten. Politische Entscheidungsträger*innen sind in der Pflicht, ausreichend Ressourcen für die Entwicklung und Verbesserung solcher Methoden bereitzustellen. Damit Erklärungen tatsächlich bei Verbraucher*innen ankommen, nehmen zudem vermittelnde Organisationen, wie beispielsweise Verbraucherschutzzentralen, eine wichtige Rolle ein (Müller-Brehm, 2022).

Dennoch darf die Verantwortung für einen ethischen Einsatz und Umgang mit KI-Anwendungen nicht an Verbraucher*innen ausgelagert werden. Stattdessen sind weitere Maßnahmen zum Schutz von Verbraucher*innen notwendig. Das umfasst beispielsweise, dass in der KI-Verordnung, die aktuell auf europäischer Ebene verhandelt wird, zivilgesellschaftliche Perspektiven und die Interessen von Verbraucher*innen ausreichend berücksichtigt werden. Entsprechend sollten alle Bürger*innen und Verbraucher*innen die Möglichkeit haben, sich über den Einsatz und die Funktionsweise von KI-Anwendungen zu informieren – sie sind aber nicht in der Pflicht, dies zu tun.

Der Blogbeitrag basiert auf dem Thesenpapier „Potenziale von erklärbarer KI zur Aufklärung von Verbraucher*innen“. Das Thesenpapier ist das Ergebnis der Fach-Arbeitsgruppe Verbraucher*innen-Information des Zentrums für vertrauenswürdige Künstliche Intelligenz (ZVKI).

Über das ZVKI

Als nationale und überparteiliche Schnittstelle zwischen Wissenschaft, Wirtschaft, Politik und Zivilgesellschaft informiert das Zentrum für vertrauenswürdige Künstliche Intelligenz über viele verbraucher*innenrelevanten Aspekte, ermöglicht öffentliche Diskussionen und entwickelt Instrumente zur Bewertung und Zertifizierung von vertrauenswürdiger KI.

Weiterführende Informationen des ZVKI zum Themenkomplex Transparenz von KI-Systemen:

- Briefing zur KI-Verordnung: Braucht es mehr Informations- und Auskunftsrechte beim KI-Einsatz? (2023)

- Briefing zur KI-Verordnung: Kennzeichnung von KI (2023)

- Thesenpapier: Wie können KI-Systeme in der Medizin erklärbar und nachvollziehbar gestaltet werden? (2023)

- Missing Link: Warum brauchen wir Transparenz? (2022)