Die Verwendung von einfacher Sprache macht unsere alltägliche Schriftsprache verständlicher und ermöglicht einem breiteren Publikum, darunter Kinder, Sprachschüler*innen und Menschen mit kognitiven Beeinträchtigungen, den Zugang zu ihr. In unserer Einführung in das Thema Textvereinfachung haben wir die mangelnde Vielfalt unter den verfügbaren Datensätzen hervorgehoben. Um diese Lücke zu schließen, haben wir einen Datensatz in Deutsch und Leichter Sprache erstellt, der 708 aneinander ausgerichtete Dokumente und über 10.000 zusammengehörige Sätze umfasst. Begleiten Sie uns dabei, wie wir die Details des Erstellungsprozesses erläutern und auf einige Feinheiten bei der Datensammlung und der Auswertung unserer Satzausrichtung hinweisen.

Ein neuer ausgerichteter Korpus in Leichter Sprache

In diesem Jahr haben wir den ersten öffentlich zugänglichen ausgerichteten Datensatz für Leichte Sprache in Deutsch veröffentlicht. Was bedeutet „ausgerichtet“? Unser Datensatz ist in zweierlei Hinsicht ausgerichtet: zum einen werden in unserem Datensatz deutsche Artikel mit den entsprechenden Artikeln in Leichter oder Einfacher Sprache gepaart (der Unterschied zwischen diesen beiden Formen der Vereinfachung haben wir in unserem letzten Blogpost beschrieben). Zum anderen präsentieren wir neben dieser Artikel-Ausrichtung auch die Analyse verschiedener Methoden für das automatisierte Finden von Satzpaaren – ein Bereich, in dem noch aktiv geforscht wird. Das bedeutet, dass wir für jeden Satz in einem deutschen Artikel alle Sätze in dem Artikel in Leichter Sprache finden wollen, die eine Übersetzung darstellen würden. Auf diese Weise wird unser Datensatz sowohl auf der Artikel- als auch auf der Satzebene ausgerichtet. In diesem Blogbeitrag werden wir die Methoden und unsere Auswertungsformen im Detail erläutern.

© Vanessa Toborek

Den Daten auf der Spur: Die fünf Schritte zur Erstellung unseres Datensatzes

Die Erstellung unseres Datensatzes erfolgte in einem fünfstufigen Prozess, der in Abbildung 1 dargestellt ist. Schritt eins, die „Websuche“, bestand darin, eine umfassende Websuche durchzuführen und zweisprachige Internetressourcen zu verschiedenen Themen zu finden. In unserem Fall bezieht sich „zweisprachig“ auf Deutsch und eine Form von einfachem Deutsch. Mit Hilfe von Internet-Crawlern extrahierten wir automatisch die Textdaten von den Webseiten. Von allen zweisprachigen Ressourcen die wir gefunden haben, mussten wir einige aussortieren, die aufgrund einer sehr uneinheitlichen Webseiten-Struktur nicht gecrawlt werden konnten. So blieben acht Internetressourcen übrig, die eine Reihe unterschiedlicher Themen abdecken, von allgemeinen Gesundheitsinformationen über Informationen zu verschiedenen sozialen Diensten bis hin zu deutschen Nachrichtenartikeln. Um unseren Datensatz gegen die Schnelllebigkeit des Internets abzusichern, wurden in Schritt zwei „Archivierung“ alle Artikel mit Hilfe der WayBackMachine vom Internetarchiv archiviert. In Schritt drei, dem „Crawling“, wurden die gesamten Webseiten gecrawlt und die Inhalte als html-Dateien gespeichert, die noch die ursprüngliche Formatierung der Artikel enthielten. Wir haben die HTML-Dateien für Schritt vier „Parsing“ verwendet, um aus den html-Dateien den Rohtext zu extrahieren. Dabei haben wir Bilder, html-Tags und entsprechende Metadaten wie z.B. Fettschrift und Absatzgrenzen ignoriert. Zusätzlich haben wir Aufzählungen, die in einfacher Sprache häufig vorkommen, in kommagetrennten Text umgewandelt. Der so entstandene Datensatz von aneinander ausgerichteten Artikeln bildet die Grundlage für die anschließende Satzausrichtung in Schritt fünf.

Präzision bei der Satzausrichtung: Schritt fünf im Detail

Die automatische Ausrichtung von Sätzen kann als das Problem beschrieben werden, bei dem man einen deutschen und einen einfachen deutschen Artikel vor sich hat, der jeweils aus einer unterschiedlichen Anzahl von Sätzen bestehen. Das Ziel der Satzausrichtung ist es, eine Liste von Satzpaaren zu erstellen, wobei jedes Paar aus einem deutschen Satz und seiner (teilweisen) einfachen Version besteht. Die Satzausrichtung erfolgt in drei Schritten:

- Umwandlung des Rohtextes in Satzlisten und Durchführung einiger leichter Vorverarbeitungen,

- Berechnung von Ähnlichkeitswerten und schließlich,

- die Anwendung eines Algorithmus zur Satzausrichtung.

Wir haben die Python-Bibliothek spaCy zur Satzidentifizierung verwendet und mit der Vorverarbeitung des Textes begonnen. Alle Satzzeichen, insbesondere die Bindestriche zwischen zusammengesetzten Substantiven in Leichter Sprache, wurden entfernt. Wir haben den Text nur für die Ähnlichkeitswerte mit TF-IDF-Vektoren in Kleinbuchstaben konvertiert. Wir haben den Text nicht in Kleinbuchstaben umgewandelt, wenn wir die vorberechneten Wortvektoren verwendet haben, da sie sich bei Wörtern wie z.B. „essen“ und „Essen“ unterscheiden. Schließlich haben wir alle geschlechtsspezifischen Suffixe aus den deutschen Artikeln entfernt. Damit beziehen wir uns auf Wortendungen, die in inklusiver Sprache verwendet werden, um sowohl weibliche als auch andere Geschlechter anzusprechen, und nicht auf Endungen, die männliche Substantive in ihre weibliche Form umwandeln. Wir haben diese Endungen entfernt, da sie in einfachen deutschen Texten nicht verwendet werden. Diese Vorverarbeitung diente lediglich der Erleichterung der Satzausrichtung, hat aber keinen Einfluss auf unser endgültiges Korpus. Der nächste Schritt war die Berechnung von Ähnlichkeitsmaßen. Um die Ähnlichkeit von Sätzen zu berechnen und zu vergleichen, benötigten wir eine numerische Darstellung der Sätze. Es gibt verschiedene Ansätze für die Umwandlung von Text in Zahlen und die acht Ähnlichkeitsmaße, die wir verglichen haben, decken drei verschiedene Möglichkeiten ab: tf-idf-Vektoren, Worteinbettungen und Satzeinbettungen. Nach der Umwandlung der Sätze in Vektoren verwendet jedes Ähnlichkeitsmaß auf die eine oder andere Weise die Kosinusähnlichkeit, um die Ähnlichkeit zwischen ihnen zu berechnen. Die erste Gruppe von Ähnlichkeitsmaßen („4-gram“, „bow“) wandelt die Sätze in TF-IDF-Vektoren um. Diese Vektoren werden berechnet, indem für jedes Wort in einem Satz berechnet wird, wie oft es in einem bestimmten Dokument vorkommt (Termfrequenz) und wie viele Artikel im gesamten Korpus dieses Wort enthalten (inverse Dokumentfrequenz). Die zweite Gruppe („avg“, „cosine“, „bipartite“, „CWASA“, „max“) verwendet vortrainierte Sprachmodelle, die für jedes Wort eine Vektordarstellung durch die Berechnung von Worteinbettungen liefern. Der Unterschied zwischen den Ähnlichkeitsmaßen besteht darin, wie sie die Wortdarstellung zu einer einheitlichen Satzdarstellung kombinieren.

© Vanessa Toborek

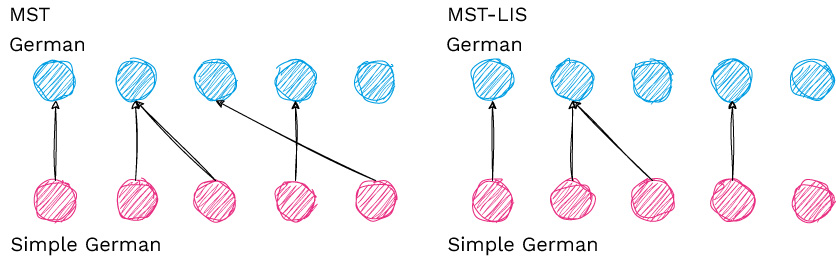

Schließlich gibt es eine Ähnlichkeitsmethode in der dritten Gruppe, die das vortrainierte Sprachmodell Sentence-BERT (SBERT) verwendet, um direkt Satzeinbettungen zu berechnen. Zuletzt können wir die Liste der Sätze und ihre entsprechenden Ähnlichkeitswerte verwenden, um die endgültigen Zuordnungen der Sätze zu berechnen. Anhand der verschiedenen Ähnlichkeitsmaße berechnen wir die Ähnlichkeit zwischen jedem Satz im deutschen und dem einfachen deutschen Artikel. Anschließend vergleichen wir zwei verschiedene Algorithmen zum Satzabgleich: Most Similar Text (MST) und MST mit Longest Increasing Sequence (MST-LIS). Beide Algorithmen wählen für jeden deutschen Satz den ähnlichsten einfachen deutschen Satz aus. Doch während der eine Algorithmus (MST) dies auf naive Weise tut, berücksichtigt der andere (MST-LIS) zusätzlich die Reihenfolge der Informationen in jedem Artikel und ordnet zwei Sätze nur dann einander zu, wenn sie die Reihenfolge der zuvor übereinstimmenden Sätze nicht verletzen. Ausgehend von den acht Ähnlichkeitsmaßen und zwei Matching-Algorithmen ergeben sich 16 verschiedene Möglichkeiten zur Berechnung der endgültigen Satzanpassungen. Im Folgenden werden wir zeigen, wie wir die Qualität der einzelnen Ansätze bewertet haben.

© Vanessa Toborek

Qualität der Satzausrichtung: Ein zweifacher Bewertungsansatz

Wir verfolgen einen zweifachen Ansatz, um die verschiedenen Algorithmen zur Satzausrichtung auf unserem neu erstellten Datensatz zu bewerten. Zunächst haben wir Goldstandard-Alignments für 39 Artikel erstellt und dann den F1-Score berechnet, um unsere Methoden auszuwerten. Der F1-Score ist das harmonische Mittel zwischen Genauigkeit und Trefferquote – eine Metrik, die nicht nur berücksichtigt, wie viele Satzpaare richtig waren, sondern auch, wie viele potenzielle Satzpaare übersehen wurden. Ergänzend zu unserer ersten Evaluierung haben wir eine Stichprobe von über 4.500 potenziellen Satzpaaren gezogen und eine Person gebeten, anhand von jeweils zwei Sätzen eine Ja/Nein-Entscheidung zu treffen, ob die beiden präsentierten Sätze eine (teilweise) Übereinstimmung darstellen oder nicht. Diese Art der Auswertung lässt zwar keine Rückschlüsse auf die Anzahl der verpassten Übereinstimmungen (d.h. Trefferquote) oder die Beziehung zu erklärenden Sätzen zu, aber wir sind der Meinung, dass sie einen anderen Blickwinkel auf die Qualität der berechneten Übereinstimmungen ermöglicht. Eine ausführlichere Erläuterung der beiden manuellen Auswertungsmethoden finden Sie in unserer Veröffentlichung „A New Aligned Simple German Corpus“ . Abbildung 2 zeigt die Ergebnisse für beide Evaluierungsmethoden. Die Ergebnisse sind zwar ähnlich, aber wir sollten sie uns genauer ansehen. Im Allgemeinen ist zu erkennen, dass der restriktivere Matching-Algorithmus MST-LIS in beiden Auswertungen eine höhere Genauigkeit erzielt. Außerdem gehören die Methoden, die TF-IDF-Vektordarstellungen verwenden, zu den leistungsschwachen Methoden. Die Ähnlichkeitsmethoden SBERT und max schneiden je nach Bewertungsmethode abwechselnd am besten ab. Unsere abschließende Empfehlung geht in Richtung der Verwendung des Ähnlichkeitsmaßes max in Kombination mit MST-LIS, wobei wir bei unseren Satzalignments der Genauigkeit den Vorrang vor der Trefferquote geben. Nichtsdestotrotz empfehlen wir, diese Satzpaare im Hinblick auf die F1-Gesamtpunktzahl mit Vorsicht zu verwenden, da wir viele falsch ausgerichtete Satzpaare erwarten. Abbildung 4 zeigt beispielhafte Satzausrichtungen aus unserem Korpus.

© Vanessa Toborek

Abschließende Hinweise: Der Weg zum endgültigen Korpus

In diesem Blogbeitrag haben wir Sie auf unserer Reise zur Erstellung eines neuen Korpus in Deutsch und Leichter Sprache mitgenommen. Wir haben Ihnen gezeigt, wie Sie mit Hilfe von Online-Ressourcen einen Datensatz von Grund auf neu erstellen können. Die Modelle für Maschinelles Lernen, die wir trainieren, sind nur so gut wie die Datensätze, auf denen sie trainiert werden. Aus diesem Grund müssen wir uns stets der möglichen Verzerrungen unserer Daten bewusst sein. Dies gilt insbesondere für Daten, die aus dem Internet stammen. Deshalb veröffentlichen wir den Datensatz mit einem begleitenden Datenblatt. Dieses Dokument ist ein strukturierter Ansatz, um mögliche Verzerrungen zu dokumentieren, indem es Antworten auf Fragen zur Motivation, Details zur Datenerfassung und -pflege und vieles mehr enthält. Neben seiner primären Verwendung für das Training von Maschinellen Lernmodellen zur Textvereinfachung ist der Datensatz ein vielseitiges, einsprachiges Korpus, das ebenfalls Anwendungen für Latent Space Disentanglement und das Finetuning bereits trainierter Modelle bietet.

Wenn Sie tiefer ins Thema einsteigen wollen, dann klicken Sie hier für die Veröffentlichung: „A New Aligned Simple German Corpus„.