Erinnern Sie sich daran, wie Sie das letzte Mal mit dem Inhalt eines komplexen Artikels oder Dokuments zu kämpfen hatten? Viele von uns kennen diese Situation. Es gibt aber auch verschiedene Gruppen von Menschen, die Schwierigkeiten damit haben, unsere alltägliche Schriftsprache zu verstehen. Aus diesem Grund gibt es einfache Versionen der Alltagssprache, die darauf abzielen, Sprachbarrieren abzubauen. In diesem Blogbeitrag werden wir eine Einführung in das Thema Textvereinfachung geben. Wir konzentrieren uns darauf, warum es so wichtig ist, unsere Schriftsprache zugänglicher zu machen, gehen auf die Zusammenhänge zwischen Textvereinfachung und der Bewertung von Lesbarkeit ein und skizzieren die verschiedenen Ansätze zur automatischen Textvereinfachung.

Sprachbarrieren abbauen: Textvereinfachung und Maschinelles Lernen

Es gibt viele Situationen, in denen wir mit schwierig zu verstehenden Dokumenten konfrontiert werden. Denken wir zum Beispiel an juristische Dokumente oder Patientendiagnosen. Vielleicht erinnern wir uns auch noch an die Lektüre von Goethe in der Schule. Stellen Sie sich nun vor, Sie lernen eine neue Sprache, haben eine Lese-Rechtschreibstörung oder sind kognitiv beeinträchtigt. In diesen Fällen kann sogar die alltägliche Schriftsprache schwer zu verstehen sein. Durch die Verwendung von einfacher Sprache können wir die Zugänglichkeit von Informationen für ein breites Spektrum an Menschen verbessern, indem wir die Bedürfnisse der verschiedenen Gruppen berücksichtigen. Das ist wichtig, da das mangelnde Verständnis komplexer und alltäglicher Texte kann ein Hindernis in Sachen Bildung, Gesundheitsversorgung und dem Zugang zu wichtigen Dienstleistungen darstellen.

Was hat das Thema Textvereinfachung eigentlich mit Maschinellem Lernen zu tun?

Das Forschungsgebiet der Textvereinfachung versucht den Prozess der Textvereinfachung zu automatisieren. Zudem ist es eng mit dem Gebiet der Lesbarkeitsbewertung verknüpft, die wiederum auf Methoden des Maschinellen Lernens (ML) zurückgreift. Ziel der Lesbarkeitsbewertung ist es, Texte automatisch nach einem vordefinierten Schwierigkeitsgrad zu klassifizieren. Hier kommen diverse ML-Methoden ins Spiel. Wir möchten zwei häufig verwendete Metriken zur Bewertung der Lesbarkeit hervorheben: den Flesch-Kincaid-Lesbarkeitsindex und den Gunning Fog Index.

Der Flesch-Kincaid-Lesbarkeitsindex berechnet für einen gegebenen Text eine Punktzahl auf Grundlage der Verhältnisse zwischen der Anzahl der Wörter in einem Satz und der Anzahl der Silben in den Wörtern zueinander. Er liefert einen Lesbarkeitswert, der einem bestimmten Schuljahr entspricht, das zum Verständnis des Textes erforderlich ist. Je niedriger der Lesbarkeitswert, desto einfacher ist der Text. Er wurde ursprünglich entwickelt, um den Schwierigkeitsgrad von technischen Handbüchern zu bewerten.

Der Gunning-Fog-Index funktioniert ähnlich, indem er eine Schätzung des geforderten Schuljahres des Lesenden liefert, indem er die durchschnittliche Anzahl der Wörter pro Satz betrachtet und dann den Prozentsatz der verwendeten komplexen Wörter berücksichtigt. Beide Maßstäbe wurden für die englische Sprache und das amerikanische Schulsystem entwickelt, aber für den Flesch-Kincaid-Test gibt es auch eine angepasste Formel für die deutsche Sprache. Da diese Metriken nur die Häufigkeit und Länge des Textes berücksichtigen, messen sie nur die Schwierigkeit des Textes in diesen Dimensionen. Es gilt jedoch zu berücksichtigen, dass es auch andere Dimensionen und entsprechende Methoden gibt. Sie haben alle ihre eigenen Vor- und Nachteile und können je nach den spezifischen Anforderungen und Zielen der Textanalyse in unterschiedlichen Kontexten eingesetzt werden.

Einfach gesagt: Was verstehen wir unter Textvereinfachung?

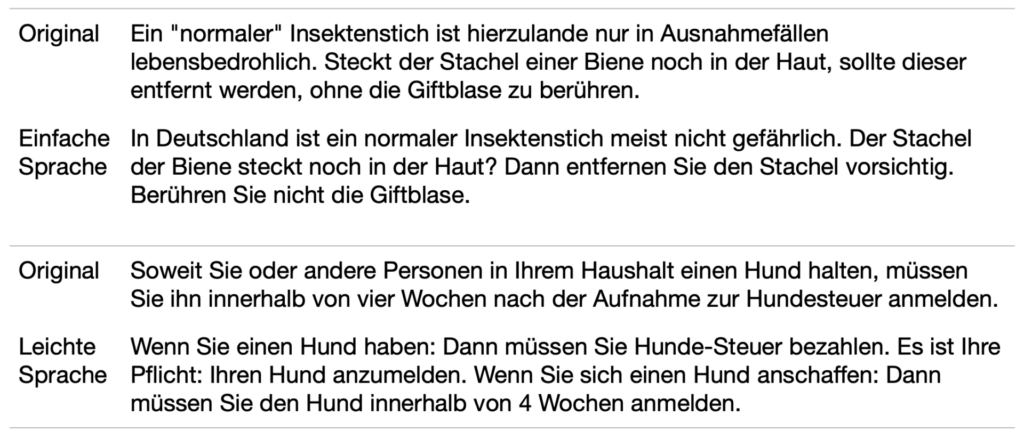

Textvereinfachung beschreibt den Prozess der Reduzierung der lexikalischen und syntaktischen Komplexität eines geschriebenen Textes. Das heißt, wir wollen geläufige Wörter und eine einfache Satzstruktur verwenden. Im Einzelnen umfasst die Übersetzung aus der Alltagssprache in einfache Sprache verschiedene Operationen wie das Löschen, Umformulieren, Einfügen und Neuanordnen. Außerdem werden bei der Vereinfachung oft zusätzliche Sätze hinzugefügt, um einen schwierigen Begriff zu erklären und zu kontextualisieren. Diese Strategie wird immer dann angewandt, wenn das Ersetzen eines schwierigen Wortes nicht ausreicht, um dessen Bedeutung klarzumachen. Denken Sie an den Satz „Sie können mit Karte bezahlen“. Dieser Satz kann nicht weiter vereinfacht werden, indem man die Wörter durch Synonyme ersetzt oder die Satzstruktur ändert. Aber wenn Sie mit dem Konzept des Bezahlens mit einer Plastikkarte anstelle von Bargeld nicht vertraut sind, benötigen Sie weitere Erläuterungen. In der Regel haben menschliche Übersetzer die Freiheit zu entscheiden, welche Wörter ersetzt werden müssen, weggelassen werden können oder durch zusätzliche Informationen ergänzt werden müssen. Sie konzentrieren sich darauf, die wichtigsten Inhalte des Originaltextes wiederzugeben. Während dies für menschliche Übersetzer relativ einfach ist, bleibt es eine Herausforderung für die automatisierte Textvereinfachung zu garantieren, dass der Inhalt der Vereinfachung mit dem Originalsatz übereinstimmt.

Verschiedene Formen der einfachen Sprache: Was ist der Unterschied?

Bis jetzt haben wir erklärt, warum die Vereinfachung von Texten sinnvoll ist und welche Methoden es gibt, um den Schwierigkeitsgrad von Texten zu beurteilen. Aber wie gelingt es uns, Alltagssprache in einfache Sprache zu übersetzen, und gibt es verschiedene Formen der Vereinfachung?

Einfache Sprache muss bestimmte Richtlinien erfüllen, um als solche zu gelten.

Im Englischen sind die populärsten Formen der einfachen Sprache „Basic English“ und „Simple English“ / „Learning English“. Beide Formen richten sich an ein Publikum von Menschen, die Englisch als Sprache neu erlernen. Basic English beschreibt eine stark formalisierte Sprache, die eine vereinfachte Grammatik und einen Wortschatz von nur 850 Kernwörtern vorsieht. Simple English verwendet einen umfangreicheren Wortschatz und ist recht verbreitet, da es für die Simple English Wikipedia verwendet wird, eine weitere Version der Online-Enzyklopädie in einfacher Sprache. Beide beschreiben zwar Formen der einfachen Sprache, sind aber eher auf Lernende zugeschnitten.

Im Deutschen sind die beiden populärsten Formen der einfachen Sprache die „Einfache Sprache“ und die „Leichte Sprache“. Der Unterschied zwischen den beiden Formen ist der Grad, in dem die Ausdruckskraft der Sprache eingeschränkt wird. Das Ziel von einfacher Sprache ist es, Fachinhalte für Laien zugänglich zu machen, ohne unbedingt auf die besonderen Bedürfnisse von Menschen mit Legasthenie oder kognitiven Einschränkungen einzugehen. Leichte Sprache hingegen ist stark eingeschränkt und setzt sogar spezielle Formatierungen ein, um die Lesbarkeit ihrer Texte zu verbessern. Zu diesen Formatierungen gehört die visuelle Trennung von zusammengesetzten Substantiven und einzelnen Sätzen, d. h. es wird nur ein Satz pro Zeile geschrieben. Außerdem enthält die Leichte Sprache in der Regel umfangreiche Kontextualisierungen und Erklärungen von verschiedenen Begriffen. Obwohl wir im Deutschen zwischen den beiden Formen der Leichten Sprache unterscheiden, gibt es keine spezifischen Regeln, die man anwenden kann, um diese Formen der Vereinfachung zu erreichen. Es gibt nur wenige Quellen zur Formalisierung, eine wertvolle Quelle im Deutschen ist Maaß 2020. Die Autorin beschreibt insbesondere den Balanceakt der zwei Formalisierungsansätze zwischen Zugänglichkeit und Akzeptanz. Wenn wir uns die Leichte Sprache und die Einfache Sprache ansehen, können wir leicht feststellen, dass die Leichte Sprache zwar sehr zugänglich ist, aber nur von einer eher kleinen Gruppe von Menschen verwendet wird, während die Einfache Sprache für die meisten von uns leicht lesbar, aber nicht so zugänglich ist.

Zurück zum Maschinellen Lernen und der Frage, wie wir Textvereinfachung automatisieren können

Im Bereich der Verarbeitung von natürlicher Sprache ist die Vereinfachung von Texten ein langjähriges Forschungsthema und es gibt verschiedene Ansätze, um komplexe Texte leichter zugänglich zu machen.

Wir können diese Ansätze in drei Kategorien einteilen:

- Regelbasierte Ansätze gehören zu den frühesten Methoden und beinhalten linguistische Regeln, auf deren Grundlage Sätze vereinfacht werden. Die Teilung von Sätzen und das Ersetzen komplexer Begriffe durch einfachere Synonyme werden häufig verwendet. Diese Regeln wurden nicht nur von Hand entwickelt, sondern beruhen auch auf dem Nachschlagen in Wörterbüchern für die lexikalischen Substitutionen. Eine mögliche Strategie zur semantischen Vereinfachung könnte wie folgt aussehen:

Ein Eingabesatz wird zunächst explizit in Token umgewandelt (d.h. in seine einzelnen Bestandteile wie Wörter und Satzzeichen zerlegt) und dann mit Part-of-Speech-Tags versehen (d.h. jedes Wort wird einer grammatischen Klasse wie z.B. Verb, Adjektiv, Adverb usw. zugeordnet). Auf der Grundlage der Wörter und ihrer Tags werden Synonyme in einem Thesaurus nachgeschlagen und zum Ersetzen verwendet, wenn das Synonym gemessen an einer umfangreichen Textquelle häufiger vorkommt als das ursprüngliche Wort. Um die grammatikalische Korrektheit zu wahren, müssen einige weitere Details berücksichtigt werden. Beachten Sie, dass bei dieser Strategie die syntaktische Komplexität des Satzes nicht berücksichtigt wird. - Modelle des Maschinellen Lernens können zur Textvereinfachung eingesetzt werden, indem das Problem als Übersetzungsaufgabe behandelt wird. Dies erfordert einen parallelen Datensatz mit Sätzen in Alltagssprache und ihrer vereinfachten Version. Dann können verschiedene Architekturen von neuronalen Netzen verwendet werden, um die Übersetzung von einem Satz in einen anderen Satz zu lernen. Die Erwartung ist, dass das Modell alle Regeln und Operationen implizit lernt, die in den regelbasierten Ansätzen explizit definiert sind, indem man dem Modell einfach nur Satzpaare in Alltagssprache und vereinfachter Sprache zeigt.

- Transformer-basierte große Sprachmodelle wie GPT-3 schließlich, die durch die Berücksichtigung des Kontextes eines Satzes komplizierte Sprachnuancen besser erfassen, produzieren mühelos kohärente Sätze. Dies ist einer der Gründe, warum sie so schnell an Popularität gewonnen haben. Sie können auch zur Vereinfachung von Texten eingesetzt werden, wobei allerdings eine gut formulierte Eingabe erforderlich ist, um den gewünschten Grad der Vereinfachung zu erreichen. Außerdem muss bei der Benutzung besonders darauf geachtet werden, dass die Vereinfachung den ursprünglichen Inhalt des Eingabesatzes wiedergibt, also sachlich korrekt bleibt.

Welche ML-Methode ist am besten geeignet, und wo finde ich einen Datensatz auf Deutsch?

Zum Abschluss dieser Einführung in die Textvereinfachung wird deutlich, dass sprachliche Barrierefreiheit für viele Gruppen unserer Gesellschaft eine Frage der Selbstverständlichkeit geworden ist. Trotz der Allgegenwärtigkeit von ChatGPT und anderen großen Sprachmodellen in der Wissenschaft und Öffentlichkeit, gibt es mehrere Vorteile bei der Verwendung traditioneller ML-Lernmodelle wie rekurrente neuronale Netze (RNNs) und Long Short-Term Memory Networks (LSTMs). Zum Beispiel sind sie in der Regel kleiner und leichter von Grund auf zu trainieren. Wie bereits erwähnt, können wir, wenn wir die Textvereinfachung als Übersetzungsaufgabe betrachten, gut etablierte ML-Lerntechniken verwenden. Dafür benötigen wir einen parallelen Datensatz mit Satzpaaren in Alltagssprache und einfacher Sprache. Und da wir die Notwendigkeit inklusiver Lösungen anerkennen, müssen wir auch darauf hinweisen, dass die vorhandenen Datensätze vorwiegend auf Englisch sind. Andere Sprachen werden oft vernachlässigt. Um die Datensatzlandschaft vielfältiger zu gestalten, haben wir einen neuen, ausgerichteten Datensatz für Einfaches Deutsch veröffentlicht. Neugierig geworden? Im folgenden Blogbeitrag werden wir den Entstehungsprozess erläutern und uns auf die technische Seite der Satzausrichtung konzentrieren. Bleiben Sie also dran!

Hier finden Sie unseren Datensatz für Einfaches Deutsch: https://github.com/mlai-bonn/Simple-German-Corpus