Ist Künstliche Intelligenz (KI) eine „post-theoretische Wissenschaft“?

In einem viel beachteten Aufsatz stellt Laura Spinney die Frage, ob wir uns mittlerweile einer „post-theoretische[n] Wissenschaft“ nähern. Die Modelle von Facebook sagen die Vorlieben der Nutzenden besser voraus als viele psychologisch fundierte Marktforschungsprojekte. Und AlphaFold, ein von DeepMind entwickeltes Neuronales Netz, hat aus den sequenzierten Aminosäuren eines Moleküls die genauesten Vorhersagen seiner räumlichen Proteinstrukturen erstellt. Im Mai 2020 stellte OpenAI das Sprachmodell GPT-3 vor, das mit 175 Milliarden Parametern den Rekord für das größte bis dahin erstellte neuronale Netz hielt. In diesem Jahr wurde nun eine „Generalist KI“ Gato vorgestellt, die nicht nur in der Lage ist, sich mit Menschen in einem Chat zu unterhalten, sondern auch Computerspiele beherrscht und einen Roboterarm steuern kann, um mit Bausteinen nach Anweisung Türmchen zu bauen. Keines dieser Modelle offenbart jedoch, wie es zu seinem Ergebnis kommt. Heute, so Spinney, haben sich oft so viele Daten angesammelt, und Computer sind bereits so viel besser als Menschen darin, komplizierte Korrelationen zu erkennen, dass unsere Theorien in Form von Formeln und Gleichungen die Realität zu stark vereinfachen würden.

Vor diesem Hintergrund hat sich in der KI ein neues Forschungsthema herausgebildet, das das offensichtliche KI-Defizit der Intransparenz systematisch angeht (Weiteres zum Thema finden Sie in unseren Beiträgen zu KI-Fairness und erklärbaren ML). Ein neuer spezieller Ansatz zur Erhöhung der Transparenz von vollautomatisch geschriebenen Texten wird entwickelt in Analogie zum bekannten menschlichen Vorgehen in einem wissenschaftlichen Diskurs: Behauptungen werden durch Zitate von Arbeiten anderer Wissenschaftler*innen belegt. Die Kombination von Sprachmodellen mit Suchmaschinen eröffnet einem KI-System die Möglichkeit, auch generierte Texte auf die gleiche Weise zu belegen.

„Verstehen“ Sprachmodelle, was sie gelernt haben?

Im Sommer 2021 kam Donald Metzler zu folgender Einschätzung:

„Große vortrainierte Sprachmodelle sind in der Lage, direkt Prosa zu erzeugen, die einem Informationsbedarf entspricht, aber sie […] haben kein wirkliches Verständnis der Welt […] und sind vor allem nicht in der Lage, ihre Äußerungen zu rechtfertigen.”

Ein großer Nachteil ist es also, dass KI-Modelle keine Begründungen oder Erklärungen für die von ihnen produzierten Texte liefern die durch Interaktion der oft Milliarden von Parametern erzeugt werden. Diese Parameter berechnen Korrelationen zwischen den numerisch codierten sprachlichen Begriffen (näheres zu dieser Technik finden Sie hier). Es entsteht dabei keine inhaltliche Interpretation. Um nicht nur sinnvoll klingende, sondern auch sachlich korrekte Texte zu generieren, braucht es mehr als nur das reine Sprachmodell. Deshalb arbeiten Expert*innen aktuell an der Synthese von Sprachmodellen und Suchmaschinen.

Sprachmodelle können relevante Texte finden und auswerten

DeepMind hat das Modell Retro vorgestellt, welches zu dem vorgegeben Starttext und den bisher erzeugten Ausgabetexten sukzessive Suchen in einer Datenbank von 5000 Milliarden Worten durchführt. Das ist in etwa so viel Text, wie die komplette Kongressbibliothek der USA umfasst.

Retro arbeitet anders als die meisten Suchmaschinen des Internets. Es wird keine Suche nach Schlüsselworten durchgeführt, sondern eine Suche über den Vergleich von numerischen Vektoren, die die Bedeutung einer Liste von Worten kodieren. Dadurch kann das Modell auch passende Texte mit anderen Formulierungen finden und so treffgenauere Suchergebnisse erzielen.

Diese Suchergebnisse werden von dem Modell zusammen mit dem bisher generierten Text analysiert. Retro umfasst nur 7 Milliarden Parameter und ist daher wesentlich kostengünstiger zu trainieren als GPT-3. Dennoch erreicht Retro bei den meisten Benchmarks Spitzenleistungen.

Retro hat also zwei entscheidende Vorteile: Einerseits kann Retro bei der Generierung von Texten auf eine viel größere Menge an Informationen zurückgreifen, ohne die Rechenkosten signifikant zu erhöhen. So ist es möglich, bei der Erzeugung von Texten gezielt Informationen abzurufen, die zur Reduktion von Fehlern und Ungenauigkeiten genutzt werden können. Zum anderen kann die Informationsbasis auf dem neuesten Stand gehalten werden, da wie bei einer Web-Suchmaschine laufend neue und aktuelle Informationen hinzugefügt werden können, ohne dass das Modell neu trainiert werden muss.

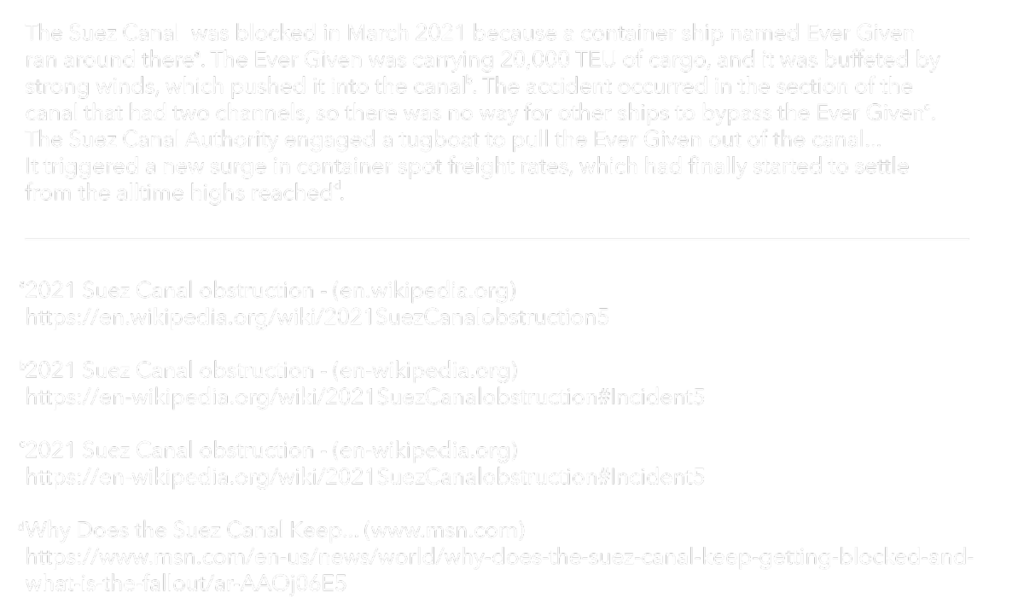

Abbildung 1: Zu der Frage „Why was the Suez Canal blocked in March 2021?“ führt das WebGPT Modell eine Reihe von Anfragen an die Bing Suchmaschine durch. Aus der Frage und den zurückgelieferten Antworten erzeugt WebGPT eine Antwort, welche die gefunden Textstellen auswertet. Zudem werden Hinweise auf die Dokumente eingefügt, die als Beleg für die Aussagen dienen und sie erklären.

Zitate belegen Fakten

Einen ähnlichen Ansatz verfolgt WebGPT von OpenAI. Das System soll das Vorgehen einer Person nachbilden, die eine Websuche zur Beantwortung einer Frage durchführt. Die Entwickler*innen gehen von dem vortrainierten GPT-3 Modell aus und passen es so an, dass es der Suchmaschine Bing Aufträge erteilen kann, zum Beispiel eine Websuche zu einer Anfrage durchzuführen. Die Eingabe besteht dabei aus der Frage, den bisher zusammengestellten Informationen, der aktuell gefundenen Webseite sowie einigen Zusatzinformationen.

Für diese Aufgabe wird nun GPT-3 durch weiteres Training so angepasst, dass es einerseits die Suchschritte von menschlichen Instruktoren möglichst gut imitiert und zum anderen die Wahrscheinlichkeit optimiert, dass die gefundenen Antworten von den Instruktoren als gut bewertet werden. In der Anwendungsphase wird dann zu jeder Anfrage eine Reihe von solchen Suchsequenzen automatisch durchgeführt und das beste Ergebnis selbsttätig ausgewählt.

Als Daten wurden Fragen und Antworten des ELI5 (Explain Like I’m Five) benchmarks verwendet. Es erfordert die Beantwortung von komplexen Fragen durch ausführliche Texte und Erklärungen. Vergleicht man die Antworten des Modells mit der am höchsten bewerteten Antwort aus dem ELI5-Testdatensatz, so werden die Modellantworten in 69% der Fälle von menschlichen Lesern bevorzugt.

In Abbildung 1 ist eine von WebGPT zur Frage „Why was the Suez Canal blocked in March 2021?“ erzeugte Antwort wiedergegeben.

Vision: der digitale Textassistent

Insgesamt eröffnen die beschriebenen Modelle eine Synthese der schon lange erfolgreichen Suchmaschinen und der modernen Sprachmodelle. Jacob Hilton, der Entwickler von WebGPT, verfolgt die Vision eines „wahrheitsgetreuen Text-Assistenten“, der Nutzenden Antworten zu ihren Fragen auf dem Niveau menschlicher Expert*innen liefert. Der Verweis auf externe Quellen löst jedoch nicht alle Probleme. Was macht ein Internetdokument zuverlässig? Welche Aussagen in einem Text müssen belegt werden, und welche sind selbstverständliches „Allgemeinwissen“. Hier stecken die aktuellen Sprachmodelle noch in den Kinderschuhen, aber es gibt Möglichkeiten, sie zu verbessern. Im Internet gibt es zum Beispiel bereits ein „Web of Trust“, welches die Zuverlässigkeit von Webseiten, unter anderem aus Nutzer*innenbewertungen ableitet.