Die Einsatzbereiche von Künstlicher Intelligenz (KI) werden stetig vielfältiger. Die prominentesten Anwendungen sind vermutlich das autonome Fahren und persönliche Assistenten, wie sie sich auf Smartphones oder in Smarthomes finden lassen. Weitere bekannte Anwendungsbereiche aus dem Alltag sind die automatische Generierung von Produktempfehlungen auf Shopping- oder Streaming-Plattformen (Recommender-Systeme), die Bewertung von Kreditwürdigkeit oder die Identifikation von Versicherungsmissbrauch. KI kann zusätzlich auch rein beratend eingesetzt werden. So unterstützt sie Ärzte beispielsweise bei der Diagnose von Hautkrebs.

Besonders in Anwendungsfällen, in denen sich KI auf das Leben von Menschen auswirkt, ist es essenziell, den Entscheidungsprozess dieser Modelle nachvollziehen zu können. Stimmt die Diagnose des Arztes nicht mit der Diagnose des Algorithmus überein, so hilft dies dem Arzt nur dann, wenn der Algorithmus seine Ausgabe auch nachvollziehbar begründen kann. Der Problematik der Erklärbarkeit von KI nimmt sich der Forschungsbereich „Explainable Machine Learning“ (XML) (Erklärbares Maschinelles Lernen) an. Hintergründe zur Notwendigkeit und dem aktuellen Stand von Erklärbarkeit können in dem Beitrag „Warum KI erklärbar sein muss“ nachgelesen werden.

In diesem Beitrag diskutieren wir drei Arten und Weisen, auf die Erklärbarkeit durch zusätzliches Wissen verbessert oder zur Wissensgewinnung im maschinellen Lernprozess eingesetzt werden kann.

Erklärungen sind ein Kommunikationsproblem

Aus der Vielfalt der Anwendungsgebiete von KI ergibt sich nun bereits, dass auch Erklärungen in den unterschiedlichsten Kontexten gebraucht werden. Dabei ist sowohl der Anwendungsfall selbst als auch der Empfänger der Erklärung ausschlaggebend dafür, welche Form und Formulierung der Erklärung am sinnvollsten ist. Wenn eine Erklärung nicht in Konzepten kommuniziert, die dem Empfänger vertraut sind, so kann dieser die Erklärung nicht verstehen. Die medizinische KI aus unserem Beispiel könnte dem Arzt ihre Diagnose dadurch begründen, dass sie einen Bereich in einem Foto markiert, der eine auffällige Stelle der Haut zeigt. Soll die Diagnose aber dem Patienten begreiflich gemacht werden, müsste die Erklärung zusätzlich notwendiges Hintergrundwissen vermitteln. Aktuellen Methoden der Erklärbarkeit fehlt es an Flexibilität, um sich an verschiedenste Kontexte und Empfängergruppen anpassen zu können. Viele Erklärbarkeitsmethoden analysieren die Entscheidung des Modells mit Hilfe von statistischen Verfahren. Diese können zwar Korrelationen aufzeigen, daraus lassen sich aber keine kausalen Zusammenhänge folgern. Deshalb ist immer noch kontextspezifisches Wissen notwendig, um die Ausgaben dieser Erklärbarkeitsmethoden korrekt zu interpretieren. Verfügt der Empfänger nicht über das nötige Wissen, kann er die Erklärbarkeitsmethode nicht nutzen.

Kontext durch zusätzliches Wissen

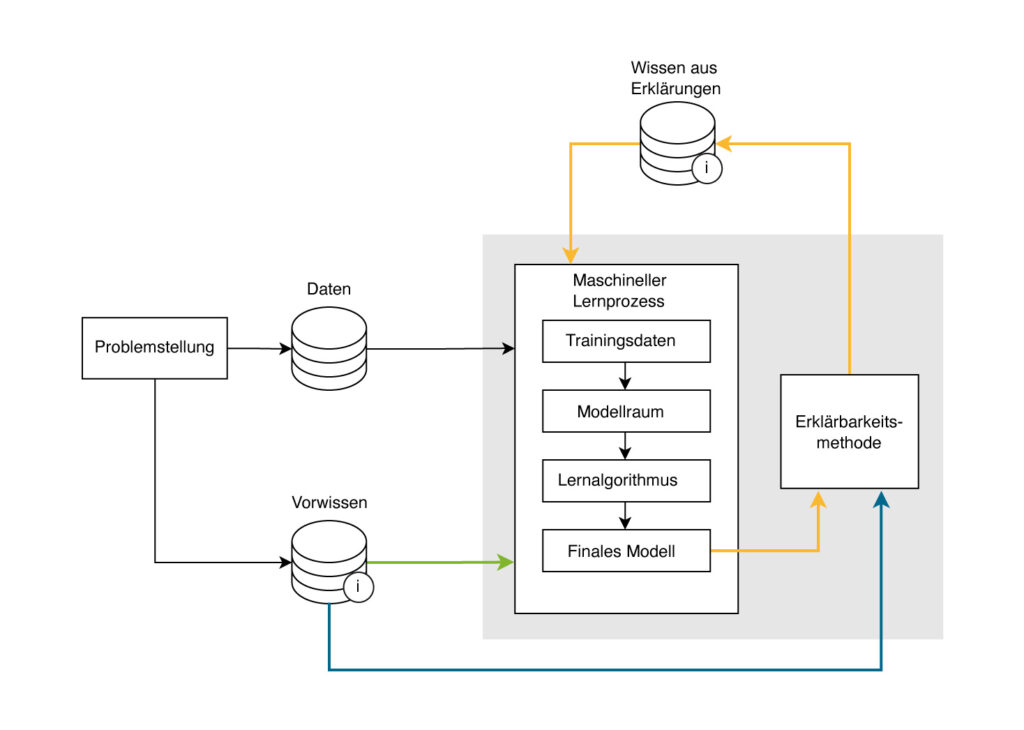

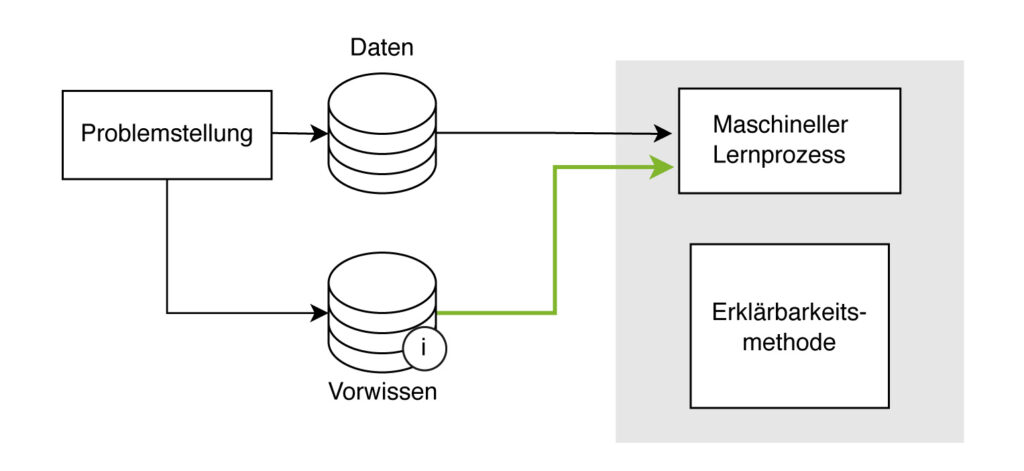

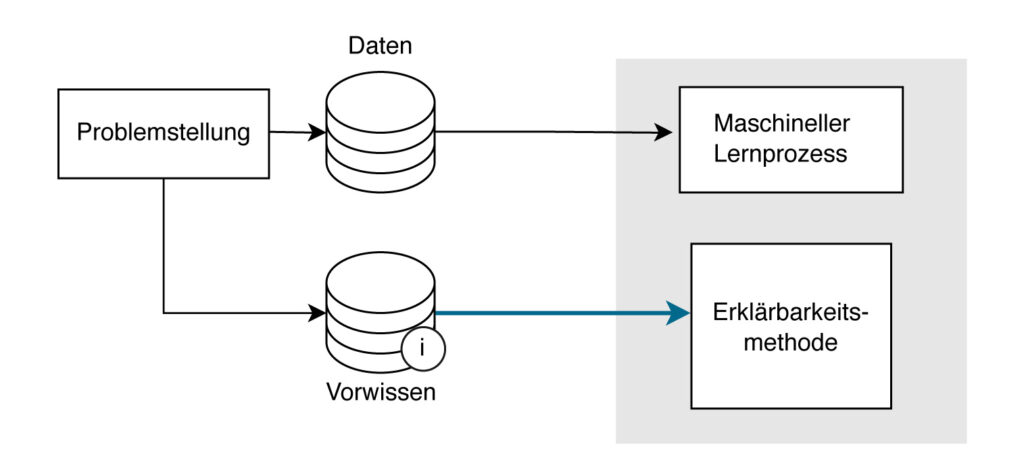

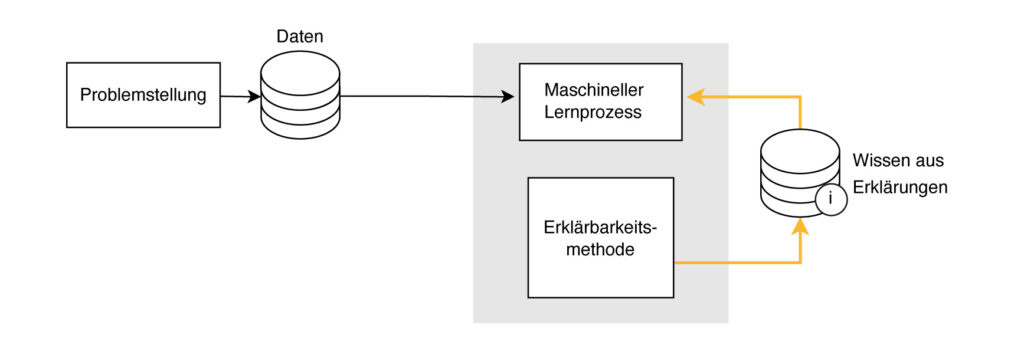

Wie der Beitrag „Informed Machine Learning – Aus Daten und Vorwissen lernen“ erklärt, lassen sich KI-Methoden verbessern, indem neben den üblichen Trainingsdaten weitere Informationen in Form von externem Wissen in den Lernprozess integriert werden. Dieses Wissen kann in verschiedenen Formen vorliegen, zum Beispiel als Fachwissen, Simulationen oder Wissensgraphen. Der Beitrag beschreibt, wie sich externes Wissen auf Dateneffizienz und Absicherung der Algorithmen auswirkt. Wir sind daran interessiert herauszufinden, ob externes Wissen auch genutzt werden kann, um Erklärbarkeitsmethoden an Kontext und Empfängergruppen anzupassen und damit anwendbarer zu machen. Bei unseren Nachforschungen haben wir drei Möglichkeiten identifiziert, wie externes Wissen und Erklärbarkeitsmethoden zusammenwirken können. Schematisch sind diese Möglichkeiten in der untenstehenden Abbildung durch die farbigen Pfeile dargestellt. Die Abbildung zeigt eine leicht veränderte Version des Informed-Machine-Learning-Prozesses aus oben genanntem Blog-Beitrag. Neu sind hier, neben den farblich hervorgehobenen Pfeilen, die „Erklärbarkeitsmethode“ und das „Wissen aus Erklärungen“.

Schematische Darstellung des maschinellen Lernprozesses inklusive des Einsatzes von Erklärbarkeitsmethoden. Die farbigen Pfeile stellen Möglichkeiten dar, wo externes Wissen mit Erklärbarkeitsmethoden integriert wird oder wie solches Wissen durch Erklärbarkeitsmethoden generiert werden kann.

Erklärbarkeit eines Modells durch Vorwissen verbessern

Der grüne Pfeil findet sich auch in der Abbildung des Blog-Beitrags zu Informed Machine Learning. Der Grund dafür ist, dass sich viele Beispiele finden lassen, in denen sich bereits allein durch die Integration von Vorwissen in den Lernprozess die Nachvollziehbarkeit der Modelle verbessert, ohne dass eine dedizierte Erklärbarkeitsmethode angewendet wird. Die Modelle werden durch das Vorwissen dazu gebracht, sich bei ihrem Entscheidungsprozess mehr an für Menschen nachvollziehbaren Konzepten zu orientieren. Zwei Beispiele:

- Die Trainingsdaten für Recommender-Systeme, die sonst nur mit Nutzerhistorien arbeiten, wurden durch einen Wissensgraphen erweitert, der Wissen über Produkte enthielt. Die Empfehlungen der Systeme wurden dann durch Pfade in dem Wissensgraphen gegeben. So war nachvollziehbar, aufgrund welcher Zusammenhänge ein Produkt empfohlen wurde.

- Andere Methoden greifen in den Lernalgorithmus ein und geben dem Modell während des Trainings zusätzliches Feedback, welches aus externem Wissen geschlossen wird. So gab es beispielsweise eine Anwendung, bei der der Algorithmus Objekte auf einem Bild identifizieren sollte. Aus einem Wissensgraphen wurde erschlossen, ob es plausibel ist, dass die gefundenen Objekte auch tatsächlich in dieser Kombination auftreten. Wird zum Beispiel ein Tisch erkannt, so ist es plausibler anzunehmen, auf dem Bild auch einen Stuhl als einen Reifen zu finden.

Grüner Pfeil: Die Integration von Vorwissen in den maschinellen Lernprozess kann die Erklärbarkeit eines Modells direkt verbessern.

Erklärbarkeitsmethoden durch Vorwissen anpassen

Der blaue Pfeil in der Abbildung umfasst Ansätze, in denen Vorwissen die Erklärbarkeitsmethode direkt beeinflusst. Diese Erklärbarkeitsmethoden fallen meist in die Kategorie der sogenannten „post-hoc“ (nachträglichen) Methoden. Der Name kommt daher, dass diese Methoden den maschinellen Lernprozess nicht beeinflussen können und nur Zugriff auf das finale Modell haben. Ein gutes Beispiel dafür sind „counterfactual“ (kontrafaktische) Methoden. Diese generieren systematisch künstliche Eingaben für das Modell und untersuchen, wie sich die Ausgabe des Modells verändert. Kontrafaktische Methoden können so „Was wäre wenn“-Fragen beantworten, die Einblick geben, was sich bei der Eingabe ändern müsste, um statt der erhaltenen Ausgabe eine andere (gewünschte) Ausgabe zu erhalten.

Blauer Pfeil: Vorwissen kann genutzt werden, um Erklärbarkeitsmethoden zu verbessern oder anzupassen.

Lehnt ein automatisches System einer Bank beispielsweise einen Kreditantrag ab, so könnte der Antragsteller mit diesen Methoden herausfinden, welche der Angaben auf dem Antrag, wie etwa Wohnort, Kredithöhe, Alter oder Einkommen, sich ändern müssten, damit der Antrag angenommen wird. Welchen Regeln die Generierung von künstlichen Eingaben unterliegt, ist anwendungsspezifisch. Hier muss die Methode durch Vorwissen angepasst werden, um verlässliche oder sinnvolle Erklärungen zu liefern. So wäre ein theoretisch möglicher Vorschlag des Systems, die Kredithöhe auf einen Wert unter Null zu senken, damit der Antrag angenommen wird, nicht konstruktiv. Alternativ können die künstlichen Eingaben auch interaktiv vom Nutzer direkt vorgegeben werden. In einem interaktiven Szenario könnte der Antragsteller selbst verschiedene Änderungen an seinem Kreditantrag durchspielen, um so gegebenfalls eine für ihn akzeptable Alternative zu seinem ursprünglichen Antrag zu finden.

Kontrafaktische Methoden eignen sich also zur selbstbestimmten Modellanalyse und bieten so einen vielversprechenden Weg, sich an einen konkreten Nutzer und Kontext anzupassen.

Erklärungen helfen, neues Wissen zu generieren oder Wissen nutzbar zu machen

Oranger Pfad: Die Erklärbarkeitsmethode hilft, Wissen über das Problem oder den maschinellen Lernprozess zu gewinnen. Dieses Wissen kann für künftige Verbesserungen genutzt werden.

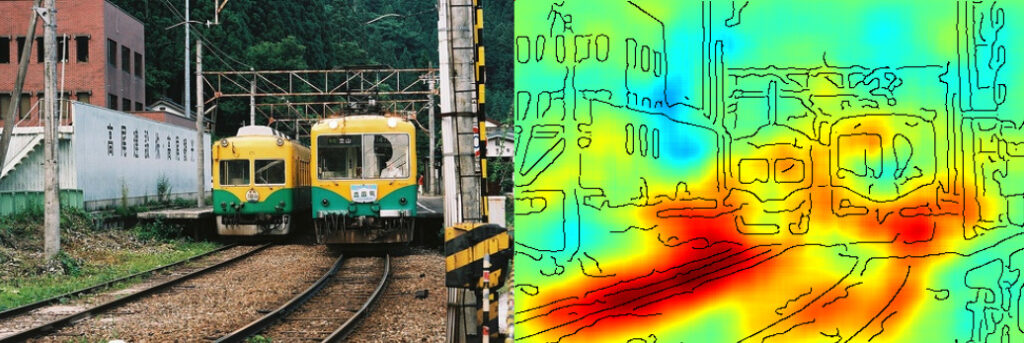

Je nach Anwendung können post-hoc Methoden aber auch durch den orangen Pfeil beschrieben werden. In unserem Beispiel hat der Antragsteller zwar Wissen gewonnen, dieses wird sich aber nicht auf das Modell auswirken. Nutzt ein Programmierer aber post-hoc Methoden, um sein Modell zu untersuchen, so kann er gewonnenes Wissen verwenden, um einen künftigen Lernprozess zu verbessern. Wie das Beispiel in der untenstehenden Abbildung und aus dem Beitrag „Warum KI erklärbar sein muss“ illustriert, kann so beispielsweise herausgefunden werden, ob ein Objekterkenner auch tatsächlich auf relevante Bereiche der Eingabe achtet.

Der Objekterkenner identifiziert bei dem linken Bild korrekt, dass dort ein Zug zu sehen ist. Rechts wurde das Bild durch eine Erklärbarkeitsmethode eingefärbt. Je röter der Bereich, desto mehr Einfluss hatte dieser auf die Ausgabe des Algorithmus. Man erkennt, dass der Algorithmus hier weniger auf den Zug als auf die Gleise achtet.

Ansätze wie „Exploratives Interaktives Lernen“ bieten einen ähnlichen, aber viel direkteren Weg, wie Wissen in den Lernprozess eingebaut werden kann. Bei diesem Ansatz erzeugt eine Erklärbarkeitsmethode bereits während des Trainings eines Modells eine Erklärung für eine Ausgabe. Diese Erklärung wird von einem Menschen bewertet und korrigiert. Das Feedback wird dann in den Lernalgorithmus aufgenommen. So kann das Modell beispielsweise schon während des Trainings angeleitet werden, worauf es bei den Eingaben achten soll. Auf diese Art und Weise wird durch die Erklärbarkeitsmethode das „Fachwissen“ des Menschen für den Lernprozess erst nutzbar gemacht.

Wir haben gesehen, dass das Zusammenwirken von Erklärbarkeitsmethoden und zusätzlichem Wissen vielfältige Effekte auf den Prozess des Maschinellen Lernens und die Interaktion von Menschen mit Modellen haben kann. Interpretierbare Wissensquellen wie Wissensgraphen können Modellen helfen, nachvollziehbarere Ausgaben zu erzeugen. Interaktive Methoden bieten für Nutzer die Möglichkeit, eigenständig das Modell zu untersuchen. So können Nutzer einerseits selbst bestimmen, was sie erklärt haben möchten, andererseits kann ein solcher Ansatz auch dabei helfen, Wissen zu gewinnen, welches künftige Modelle verbessern kann. Erklärbarkeitsmethoden fungieren immer als Mediator zwischen dem Modell und dem Menschen; richtig eingesetzt kann so Fachwissen direkt in den Lernprozess integriert werden. Wir hoffen, durch die Identifizierung dieser drei Kontaktpunkte von Erklärbarkeitsmethoden und zusätzlichem Wissen ein Analysewerkzeug entwickelt zu haben, durch das sich künftige und bestehende Erklärbarkeitsmethoden zielgerichtet entwickeln oder verbessern lassen.

Mehr Informationen in dem zugehörigen Paper:

Explainable Machine Learning with Prior Knowledge: An Overview.

Katharina Beckh, Sebastian Müller, Matthias Jakobs, Vanessa Toborek, Hanxiao Tan, Raphael Fischer, Pascal Welke, Sebastian Houben, Laura von Rueden. ArXiv, 2021, Link