Als das am weitesten verbreitete 3D-Datenformat hat sich die Erkennung von Punktwolken zu einem Bereich entwickelt, der zunehmend im Fokus der Forschung ist. Da Deep-Learning-Modelle ihre Leistung immer weiter verbessern, wirft die zunehmende Komplexität der Modellarchitekturen jedoch Bedenken hinsichtlich ihrer Vertrauenswürdigkeit auf, insbesondere bei Daten wie Punktwolken, die häufig in sicherheitskritischen Anwendungen wie dem autonomen Fahren eingesetzt werden. Um dieser Herausforderung zu begegnen, wurde in einem früheren Blogbeitrag eine Erklärbarkeitsmethode vorgestellt, die auf einem Ersatzmodell für Punktwolken basiert. In diesem Artikel werden wir nun weitere Forschungsarbeiten zur Erklärbarkeit von Punktwolken vorschlagen.

Die Erklärbarkeit von Punktwolken

Das Hauptziel der Erklärbarkeitsforschung besteht darin, die Entscheidungen von Modellen des Maschinellen Lernens für den Menschen transparenter und interpretierbar zu machen. Unterschiedliche Erklärbarkeitsmethoden entsprechen verschiedenen Wegen, dieses Ziel zu erreichen. Eine dieser Methoden ist die LIME-Methode für Punktwolken. Bei diesem Ansatz handelt es sich um eine attributionsbasierte lokale Erklärungsmethode, die die Frage beantwortet, welcher Teil der Instanz für eine bestimmte Entscheidung von Bedeutung ist. Das Verständnis der Vorhersageprinzipien von tiefen neuronalen Netzen aus einer einzigen Perspektive kann jedoch eine Herausforderung darstellen. Bei attributionsbasierten Erklärungen fehlt die Grundwahrheit, was es schwierig macht, ihre Korrektheit zu beurteilen. Außerdem können lokale Erklärungen keinen Einblick in das Verhalten des Modells auf dem gesamten Datensatz geben. Um diese Einschränkungen zu überwinden, werden zwei Methoden vorgeschlagen, die die Entscheidungsgrundlage von Punktwolkenmodellen aus verschiedenen Blickwinkeln offenlegen: eine auf Aktivierungsmaximierung basierende globale Erklärungsmethode und ein auf fraktalen Fenstern basierender Non-Deep-Learning-Ansatz.

Globale Repräsentativität

Eine faszinierende Frage beim Deep Learning ist, was ein Modell als ideale Eingabe betrachtet. In einer früheren Studie wurde ein instanzbasierter Ansatz zur Visualisierung der globalen Repräsentation vorgeschlagen, die sogenannte Aktivierungsmaximierung (AM). Die Grundidee besteht darin, eine Gradientenanstiegsoptimierung an bestimmten Neuronen in der obersten Schicht des Modells, den so genannten Logits, durchzuführen – mit dem Ziel, eine Eingabe mit dem höchsten Vertrauen zu erzeugen, die als die global repräsentativste Instanz angesehen wird. Diese Technologie wurde bereits ausgiebig auf Bilder angewandt, wodurch klare Umrisse von Objekten erzeugt werden konnten.

Die Visualisierung der globalen Repräsentationen von Punktwolkenmodellen mit AM stellt jedoch aufgrund der komplexen Datenstruktur eine weitere Herausforderung dar. Um eine punktwolkenspezifische globale, instanzbasierte Erklärung zu erstellen, konzentrieren wir uns auf drei Hauptaspekte:

- Das Ausmaß, in dem die Erklärung global repräsentativ ist. Dies hängt vom Aktivierungsgrad der ausgewählten Neuronen ab. Ein höherer Vertrauenswert deutet auf eine global repräsentative Eingabe hin.

- Die Wahrnehmbarkeit der Erklärungen für den Menschen ist entscheidend. Im Allgemeinen gilt: Je näher die Erklärung an einem bestehenden Objekt liegt, desto leichter ist sie auch wahrnehmbar. Wir bewerten diese Metrik quantitativ, indem wir die Ähnlichkeit mit Mustern der gleichen Kategorie aus dem Datensatz vergleichen.

- Die Vielfalt der Erklärungen ist ebenfalls wichtig, da sie ein intuitiveres Verständnis der internen Mechanismen des Modells ermöglicht. Eine größere Anzahl von sich nicht wiederholenden Erklärungen trägt zu einem besseren Verständnis des Entscheidungsprozesses des Modells bei.

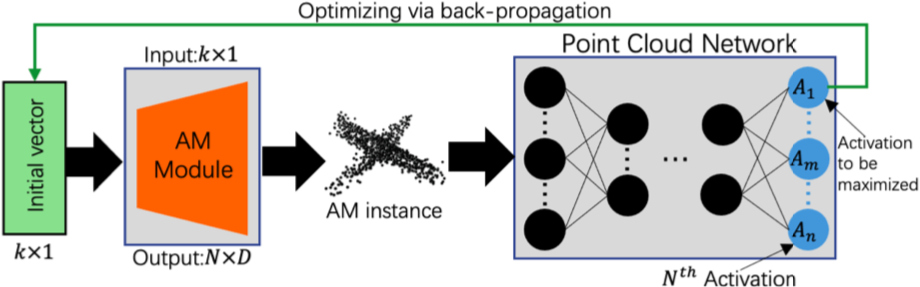

Um die Herausforderungen bei der Anwendung der Aktivierungsmaximierung auf Punktwolkenmodelle zu bewältigen, filtern wir zunächst die Teilmenge der Daten heraus, die von Menschen leicht erkannt werden kann. Von dort aus suchen wir nach Stichproben, die für die gesamte Datenverteilung sehr repräsentativ sind. Unser Ansatz zur globalen Erklärung umfasst ein generatives Modell und einen Punktwolkenklassifikator (mehr zur Klassifikation im Maschinellen Lernen lesen Sie in diesem Blogbeitrag).

- ein Diskriminator zur Unterscheidung der generierten Proben von den echten Proben

- zwei latente Abstandsverluste zur Kontrolle der Qualität der generierten Proben in latenten Räumen

- Gaußsches Rauschen, das dem Kodierer während des Trainings hinzugefügt wird, um die Stabilität der Generationen zu verbessern.

Das obige Modul wird vor den zu erklärenden Klassifikator geschaltet und ein bestimmtes Neuron (normalerweise die Logits, die eine bestimmte Klasse anzeigen) wird aus diesem ausgewählt. Dann wird ein zufälliger Anfangsvektor in den Generator eingespeist, um globale Erklärungsmuster zu erzeugen, die sowohl wahrnehmbar als auch repräsentativ sind, indem die Verlustfunktion minimiert wird, die die Differenz zwischen dem Generationsverlust und dem Zielaktivierungswert darstellt. Außerdem fügen wir während der Optimierung zufälliges Rauschen hinzu, um die Diversität zu fördern und zu vermeiden, dass das gleiche Ergebnis wiederholt erzeugt wird.

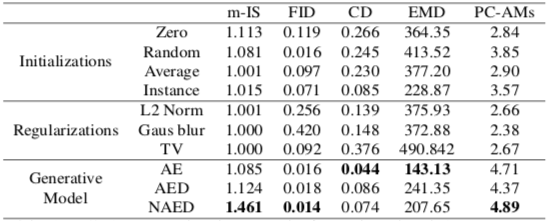

Aufgrund der strukturellen Besonderheiten können herkömmliche AM-Techniken, die auf Bilder angewendet werden, keine sinnvollen Erklärungen für Punktwolken liefern. Die vorgeschlagene Methode erzeugt jedoch sehr gut wahrnehmbare und repräsentative 3D-Strukturen für bestimmte Klassen. Um den Vergleich zu erleichtern, schlagen wir eine quantitative Bewertungsmetrik vor, die alle drei wesentlichen Elemente umfasst: Repräsentativität, Wahrnehmbarkeit und Vielfalt.

Inhärente Interpretierbarkeit

Eine Alternative zu Post-hoc-Erklärungsmethoden („nachträgliche Erklärungsmethoden”) besteht darin, die Transparenz des Modells selbst zu erhöhen. Dieser Ansatz kann die Rechenkosten senken und potenzielle Verzerrungen vermeiden, die durch Erklärungsmethoden hinzukommen können. Allerdings sind erklärbare Modelle im Vergleich zu Black-Box-Modellen oft weniger leistungsfähig. Die meisten Punktwolkenmodelle basieren auf tiefen neuronalen Netzen, da diese in der Lage sind, komplexe räumliche Merkmale zu lernen. Dennoch haben Forscher*innen darauf hingewiesen, dass es möglich ist, eine ähnliche Leistung mit einem interpretierbaren Modell zu erzielen, das effektive Merkmale extrahieren kann.

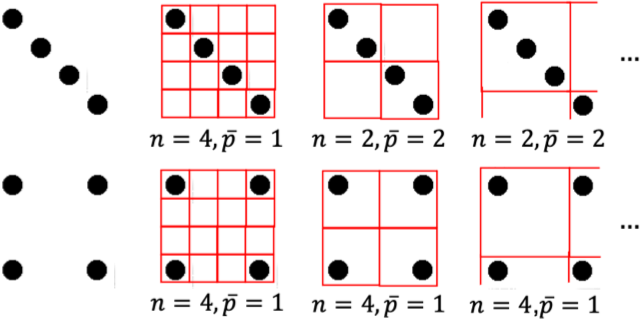

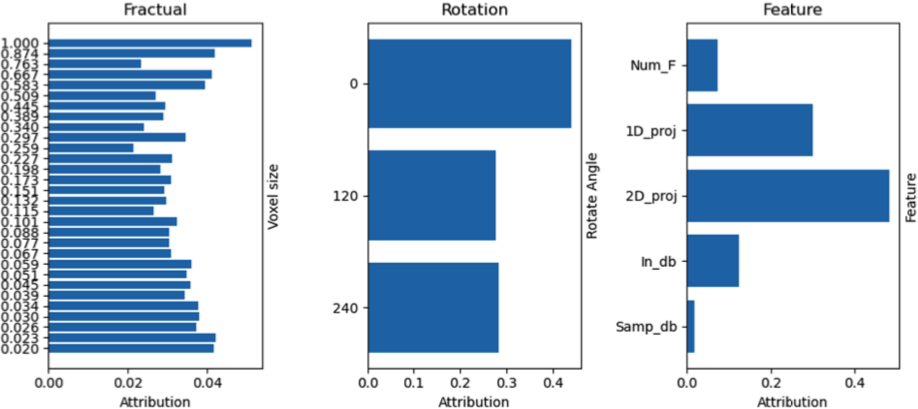

Wir stellen nun eine Technik zur Merkmalsextraktion für Punktwolken vor, die „fraktale Fenster“ genannt wird. Bei dieser Methode werden Punkte mit unterschiedlichen Fenstergrößen abgetastet, um eine Folge von Fenstern zu erzeugen. Anschließend werden statistische Merkmale aus jedem Fenster extrahiert, um tabellarische Merkmale zu erhalten. Die statistischen Merkmale können mit jedem beliebigen benutzerdefinierten Merkmalsvektor verkettet werden – einschließlich, aber nicht beschränkt auf Menge, Durchschnittswert, Varianz usw. Durch diesen Ansatz wird die komplizierte räumliche Struktur von Punktwolken in tabellarische Daten umgewandelt, die sich besser für interpretierbare Modelle eignen.

Der Klassifizierungsprozess kann in vier Hauptschritte unterteilt werden. Zunächst werden die Eingabedaten vergrößert (z. B. gedreht) und auf ein- und zweidimensionale Räume entlang der X-, Y- und Z-Achse projiziert. Dann werden fraktale Fenster erzeugt, aus denen manuell statistische Merkmale extrahiert werden. In einem nächsten Schritt werden die Verteilungen der ein- und zweidimensionalen fraktalen Fenster mit Hilfe der Gaußschen Anpassung berechnet. Schließlich werden alle fraktalen Merkmale miteinander verknüpft und in einen Zufallsforst eingegeben, um Vorhersagen zu erhalten.

Unser Non-Deep-Learning-Ansatz zeigt eine vergleichbare Leistung wie Deep-Learning-Modelle, bietet aber den Vorteil, dass er auf der CPU mit akzeptablen Verarbeitungszeiten trainiert und ausgeführt werden kann. Dies reduziert die Rechenkosten im Vergleich zu Deep-Learning-Methoden.

Random Forests („Zufallswälder”) bieten im Vergleich zu neuronalen Black-Box-Netzen eine bessere Transparenz, auch wenn sie immer noch keine vollständig verständlichen Modelle sind. Intrinsische Interpretationen können mit Hilfe der Gini-Verunreinigung generiert werden, was zusätzliche Post-hoc-Berechnungen überflüssig macht. Post-hoc-Erklärungen können ebenfalls verwendet werden, da das Modell aufgrund der deutlich höheren Trainingsgeschwindigkeit leicht mehrfach neu trainiert werden kann, was das durch Störungen verursachte Out-of-Distribution-Problem entschärft (siehe ROAR).

Schließlich ist der vorgeschlagene Klassifizierungsansatz in hohem Maße anpassbar, da jedes statistische Merkmal verkettet werden kann. In Zukunft wollen wir Methoden zur Merkmalsverarbeitung erforschen, die tiefe neuronale Netze potenziell übertreffen könnten.

Toolkit – Erläuterung von Punktwolkenmodellen

Sie fanden diese Informationen nützlich und möchten sie selbst ausprobieren? Bitte sehr: Der Code ist auf GitHub verfügbar: https://github.com/Explain3D/PointCloudAM und https://github.com/Explain3D/FracProjForest. Eine Anleitung zum Aufbau der Arbeitsumgebung finden Sie im Repository. Weitere Informationen zu den vorgeschlagenen Ansätzen und Experimenten finden Sie in der entsprechenden Veröffentlichung.

- Visualizing Global Explanations of Point Cloud DNNs

Tan, Hanxiao. Proceedings of the IEEE/CVF Winter Conference on Applications of Computer Vision. 2023. Pdf - Fractual Projection Forest: Fast and Explainable Point Cloud Classifier

Tan, Hanxiao. Proceedings of the IEEE/CVF Winter Conference on Applications of Computer Vision. 2023. Pdf