In Laufe kaum eines Jahrzehnts haben tiefe neuronale Netzwerke (DNNs) das Maschinelle Lernen revolutioniert und zeigen nach wie vor unerreichte Performanz in einer wachsenden Zahl höchst relevanter Aufgaben. Für stark eingeschränkte Problemstellungen werden menschliche Leistungen hierbei immer häufiger übertroffen. Viele dieser neuronalen Modelle haben ihren Weg in marktreife Anwendungen wie Smart Speaker, automatisierte Übersetzungen oder Content Feeds gefunden. Allerdings bergen sicherheitskritische Systeme, bei denen möglicherweise Gefahr für Leib und Leben besteht, bestimmte Herausforderungen in der Anwendung von ML-Methoden. Zu diesen Gefahren gehören einige potentielle Schwächen der DNNs, die vielfältig sind und von mangelnder Generalisierung über unzureichende Interpretierbarkeit bis hin zu Problemen mit manipulierten Eingaben reichen. Diese Schwächen angemessen zu berücksichtigen, zu behandeln und zu beheben, macht den Einsatz neuronaler Netze in sicherheitskritischen Systemen so schwierig. Beispiele für Systeme, in denen eine solche sicherheitskritische Betrachtung nötig ist, sind nahezu alle Anwendungen der autonomen Robotik, bei denen menschliche Interaktion möglich oder nötig ist. Hierunter fällt auch das automatisierte Fahren.

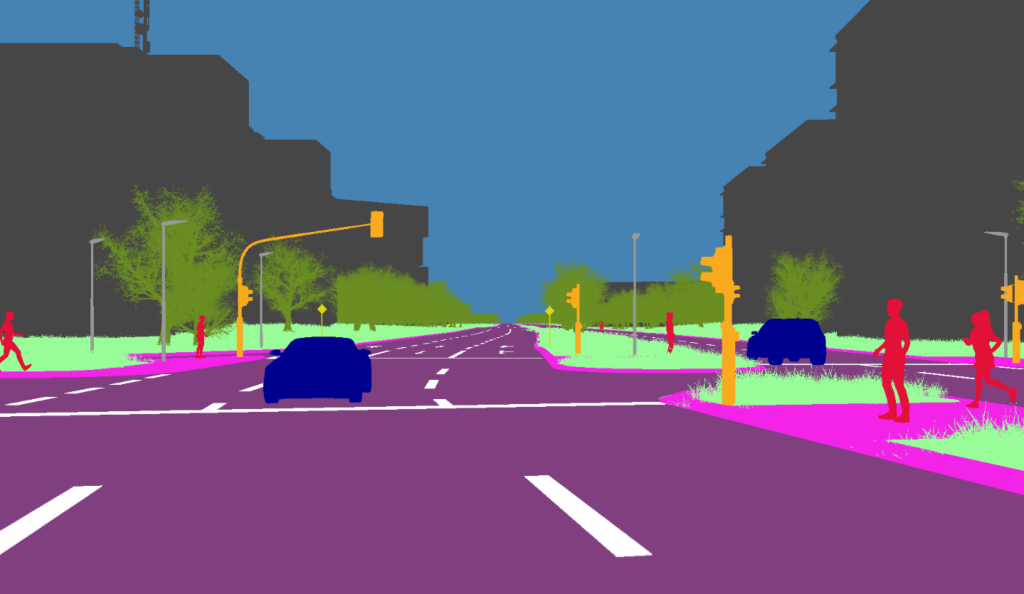

Autonomes Fahren ist eines der populärsten Anwendungsbeispiele, wenn man über die Sicherheit und Vertrauenswürdigkeit der eingesetzten Machine-Learning-Verfahren spricht.

„KI-Absicherung“ – Sichere KI für das Autonome Fahren

In den letzten Jahren wurden eine Vielzahl von State-of-the-Art-Techniken entwickelt, die darauf abzielen, etwaige Sicherheitsbedenken maschineller Lernverfahren zu adressieren. In dem Forschungsprojekt „KI-Absicherung“ erarbeiten 24 Partner aus Industrie und Forschung unter Leitung der Volkswagen AG und des Fraunhofer IAIS (als Teil des ML2R) Verfahren und Argumentationsketten, die die Sicherheit von KI-basierten Wahrnehmungsfunktionen nachweisbar machen. Ein in dieser Zusammenarbeit entstandenes und jüngst erschienenes Survey-Paper gibt einen strukturierten und breiten Überblick über die State-of-the-Art-Techniken zur Absicherung von ML-Modellen. Ziel dieses Surveys und der Zusammenarbeit ist es, die aktuellen Forschungsansätze zusammenzufassen, um potentielle Schwächen von DNNs zu identifizieren, quantitativ zu messen (so genannte Sicherheitsmetriken) oder zumindest teilweise zu beheben (so genannte Sicherheitsmaßnahmen).

Zur Entwicklung dieser Metriken und Maßnahmen konzentrieren sich einige Forschungsansätze auf den Aufbau einer Theorie zum besseren Verständnis der DNNs, andere widmen sich der Entwicklung praktischer Verfahren, um das Training, die Vorhersagen oder den Entwicklungsprozess selbst an die neuen Sicherheitsanforderungen anzupassen. Derzeit gibt es eine Vielzahl verschiedener Arbeiten, die sich jeweils jedoch nur einem kleinen Teil aller Sicherheitsbedenken widmen. Eine umfassende Absicherungsargumentation für ein komplexes System auf Basis eines DNNs wird hingegen in der Regel auf einem Zusammenspiel mehrerer Metriken und Maßnahmen beruhen. Dieser Beitrag fasst die bekanntesten und vielversprechendsten von ihnen in acht Kategorien zusammen und stellt diese jeweils in einem Überblick vor. Für eine detaillierte Auseinandersetzung mit den einzelnen Metriken und Maßnahmen sei auf das Survey-Paper verwiesen.

Acht Wege zur sicheren KI

Datensatzoptimierung: Maßnahmen der Datensatzoptimierung widmen sich dem Trainings- und Evaluationsprozess neuronaler Netzwerke. Dies ist in der Tatsache begründet, dass neuronale Netze im Gegensatz zu Menschen auf Eingaben, die ihnen beim Training nicht präsentiert wurden und die sich möglicherweise grundlegend von Trainingsdaten unterscheiden, in der Regel schlechte Ausgaben prädizieren. Das Problem ergibt sich einerseits durch unvollständige, also nicht repräsentative Datensätze und das Vorhandensein von Distributional Shifts. So ist beispielsweise das Aussehen von Fußgänger*innen und das Straßenbild sowohl von Land zu Land als auch über die Zeit sehr unterschiedlich. Mögliche Gegenmaßnahmen für diese Probleme sind Data Augmentation und Ausreißerdetektionsverfahren.

Robustheit und „Adversarial Attacks“: Auch kleine Änderungen in Eingaben eines neuronalen Netzwerks, vor allem durch die Verknüpfung zahlreicher nichtlinearer Funktionen, können zu einem signifikant anderen Ergebnis führen. Beispielsweise kann das Austauschen der Kleidung einer Person als geringfügige Änderung innerhalb eines Bildes angesehen werden, jedoch zu völlig anderen Vorhersagen des ML-Modells führen. Maßnahmen des Bereichs Robustheit behandeln dieses Problem. Ein Spezialfall der Robustheit bilden die so genannten „adversarial Attacks“, bei denen man nach einer möglichst geringfügigen Manipulation sucht, die eine möglichst große Änderung des Verhaltens eines Netzwerks verursacht.

Erklärbarkeit: Maßnahmen des Bereichs Erklärbarkeit befassen sich mit der Offenlegung der inneren Funktionsweise neuronaler Netze. Aus einer Sicherheitsperspektive ist dies wichtig, da die Interpretierbarkeit und Transparenz maschineller Lernverfahren es erlaubt, Fehlerfälle durch das Modell zurückzuverfolgen und zielgerichtete Verbesserungen anzustoßen (siehe auch den Blogbeitrag: Warum KI erklärbar sein muss). Ebenso erlauben es diese Methoden, Shortcut Learning zu identifizieren. Dies ist ein Spezialfall des Overfitting, in denen eine Vorhersage auf einer zufällig gelernten Korrelation aber nicht auf einem kausalen Zusammenhang beruht.

Unsicherheit: Methoden und Maßnahmen des Bereichs Unsicherheit versuchen DNNs mit einer situationsabhängigen Güteeinschätzung auszustatten, mit der sie ihre eigene Sicherheit bezüglich der gemachten Vorhersage bewerten. Ohne entsprechende Anpassungen tendieren neuronale Netzwerke dazu, die Konfidenz ihrer Vorhersage zu überschätzen. Sie weisen in diesem Fall dem vorhergesagten Ergebnis eine Wahrscheinlichkeit zu, die nicht mit der Wahrscheinlichkeit korreliert, dass die Vorhersage korrekt ist. Gerade als Komponente eines Systems, möglicherweise mit mehreren redundant arbeitenden Modellen, ist aber die Konfidenz eines DNNs essentiell, um die besten Vorhersagen auszuwählen und andere Vorhersagen zu verwerfen. Schlechte Konfidenzschätzungen treten insbesondere bei Eingabedaten auf, die sich stark von der Trainingsmenge unterscheiden. Zudem sollte die Selbsteinschätzung eines Netzwerks nicht nur global stimmen, sondern auch lokal mit der entsprechenden Fehlerwahrscheinlichkeit korrelieren. Als Beispiel dient hier eine Fußgängererkennung, die alle weiblichen Fußgänger detektiert aber keinen männlichen. Hier wäre die Konfidenz mit 50% für jede Ausgabe des Netzes global korrekt bewertet, dennoch stellt diese nicht an die Daten angepasste Konfidenzbewertung offensichtlich ein Sicherheitsproblem dar. Methoden und Maßnahmen der Kategorie Unsicherheitsbewertung betrachten dieses Problems.

Aggregation: Der Kombination verschiedener Modelle in einem komplexen System widmen sich auch Methoden und Maßnahmen des Bereichs Aggregation. Als Hauptvertreter dieser Ideen zählen das Ensembling, also die Kombination der Vorhersagen unterschiedlicher Verfahren, und die Temporal Consistency, also die Kombination der Vorhersagen in zu verschiedenen Zeitpunkten.

Verifikation und Validierung: Methoden und Maßnahmen zur Verifikation versuchen, quantitative Anforderungen an neuronale Netze zu definieren und systematisch sowie vollständig zu testen. Ob diese Anforderungen genügen, um die Sicherheit eines Systems zu garantieren und ob zum Beispiel Risiken übersehen wurden, wird hingegen bei der Validierung betrachtet. Für KI-Modelle müssen diese etablierten Begriffe aus der funktionalen Sicherheit neu gedacht werden, so dass Verifikation zu einem großen Teil aus der Definition, Auswahl, Zusammenstellung und Pflege eines Testdatensatzes besteht. Um die Überdeckungsgüte dieses Testdatensatzes zu ermitteln, kommen wiederum Verfahren zum Einsatz, die die Vollständigkeit der Aktivierungen einer Schicht für alle Trainingsbeispiele eines neuronalen Netzwerks (beziehungsweise eines Surrogate-Modells) bewerten.

Architektur: Einen wichtigen Einfluss sowohl auf die Generalisierbarkeit als auch auf die Robustheit haben die vielen Arten ein neuronales Netzwerk zu konstruieren. Begann man anfangs noch mit wenigen Convolutional Layers und fügte mit der Zeit immer mehr Convolutional Layers hinzu, so gibt es heute spezialisierte Blöcke, die als Netzwerk im Netzwerk eingebaut und teilweise automatisiert kombiniert werden. Ergänzt werden diese Ansätze durch Methoden des Multi-Task Learning, bei dem einem Netzwerk mehrere Aufgaben antrainiert werden, so dass dessen Merkmalsrepräsentation entsprechend vielfältig einsetzbar sein muss.

Compression: Zu guter Letzt kann auch die Inferenzdauer und hiermit einhergehend die Anzahl durchzuführender Rechenoperationen bei neuronalen Netzwerken den Einsatz in sicherheitskritischen Anwendungen verbieten, da notwendige Ergebnisse nicht in vertretbarer Zeit berechnet werden können oder zu viel Energie benötigen. Eine Reihe von Lösungsansätzen sind unter dem Begriff Pruning zusammengefasst. Man versucht hier, den Einfluss von Gewichten, Neuronen oder Layern auf den Loss-Wert zu bestimmen und diejenigen Elemente mit minimalem Einfluss sukzessive zu entfernen. Datensatzunabhängige Verfahren bedienen sich unterschiedlicher Heuristiken, die Relevanz einzelner Filter auf Grund statistischer Eigenschaften zu bewerten.

Herausforderungen mit Strahlkraft

Moderne KI ist also nicht nur durch die Jagd nach immer höherer Performanz bestimmt. Forschende und Praktizierende müssen sich heute auch der sicherheitsrelevanten Schwachstellen neuronaler Netze bewusst sein und einen Überblick über die wichtigsten Entwicklungen zu deren Behandlung behalten. Wenngleich eine umfassende Lösung derzeit nicht in greifbarer Zukunft scheint, haben die in diesem Artikel vorgestellten Methoden eine hohe praktische Relevanz und strahlen bereits jetzt vielfach in wirtschaftliche Anwendungen aus.

Mehr Informationen sind auf der KI-Absicherung Projektseite oder im zugehörigen Survey-Paper zu finden:

Inspect, Understand, Overcome: A Survey of Practical Methods for AI Safety

S. Houben, S. Abrecht, M. Akila, A. Bär, F. Brockherde, P. Feifel, T. Fingscheidt, S. S. Gannamaneni, S. E. Ghobadi, A. Hammam, A. Haselhoff, F. Hauser, C. Heinzemann, M. Hoffmann, N. Kapoor, F. Kappel, M. Klingner, J. Kronenberger, F. Küppers, J. Löhdefink, M. Mlynarski, M. Mock, F. Mualla, S. Pavlitskaya, M. Poretschkin, A. Pohl, V. Ravi-Kumar, J. Rosenzweig, M. Rottmann, S. Rüping, T. Sämann, J. D. Schneider, E. Schulz, G. Schwalbe, J. Sicking, T. Srivastava, S. Varghese, Weber, S. Wirkert, T. Wirtz, M. Woehrle, 2021, PDF.