Einleitung

Reinforcement Learning (RL) ist eine leistungsstarke Methode zur Entwicklung von Roboter-Motorfähigkeiten (siehe die vorherigen Blogbeiträge der RL-für-Robotik-Serie). Die Auswahl des geeigneten Action Spaces für das Lernen ist jedoch entscheidend und basiert oft auf Intuition. Ein Roboter mit Rädern kann beispielsweise einen Geschwindigkeits-Action Space für die Räder nutzen, während ein laufender Roboter typischerweise Gelenkpositionen verwendet und Manipulatoren kartesische Zielpunkte ansteuern. Obwohl etablierte Action Spaces wie die Positionssteuerung für laufende Roboter existieren, bleiben wichtige Fragen offen: Warum ist Positionssteuerung für laufende Roboter effektiver als die direkte Nutzung von Drehmomenten? Ist sie für alle Robotikaufgaben geeignet, oder gibt es effektivere Optionen für verschiedene Systeme?

Roboter operieren im Allgemeinen innerhalb eines physikalisch definierten Action Spaces, in denen elektrischen Antriebe typischerweise Strom verwenden, um über eine hochfrequente Regelung Drehmomente zu generieren. Während RL-Policies direkt Drehmomente ausgeben können, empfehlen viele Studien alternative Action Spaces wie Gelenkpositionen, Gelenkgeschwindigkeiten oder aufgabenbezogene Sollwerte, die durch Regelkreise in Drehmomente umgewandelt werden. Die Wahl des Action Spaces beeinflusst das Roboterlernen erheblich, z. B. in Bereichen wie Charakteranimation, Manipulation und fliegende Roboter. Obwohl Positionssteuerung oft bevorzugt wird, deuten einige Studien darauf hin, dass andere Action Spaces für bestimmte Aufgaben effektiver sein können.

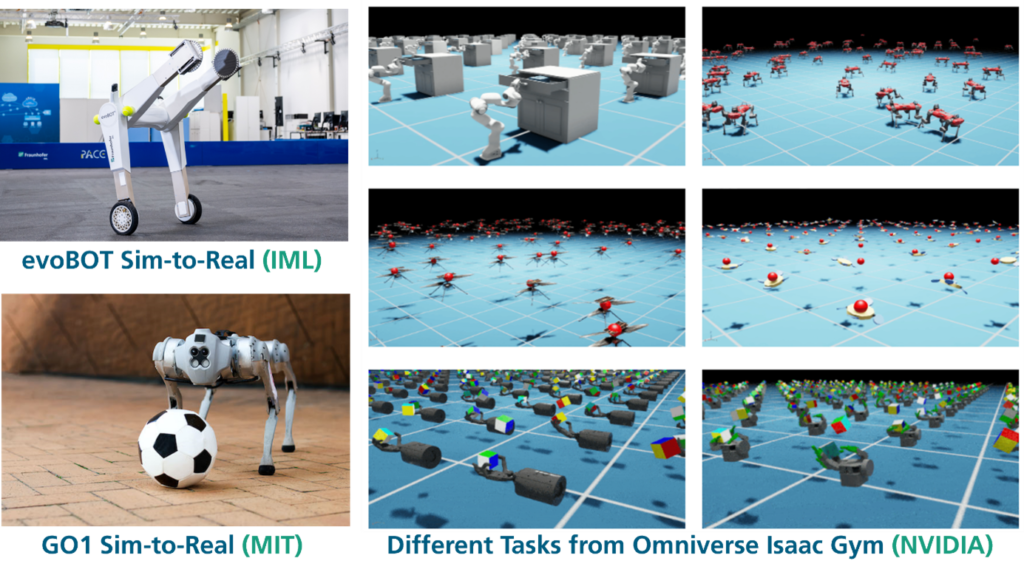

Die Omniverse Isaac Gym Suite für robotische Lernaufgaben verdeutlicht die Komplexität der Implementierung von Action Spaces mit einer Vielzahl unterschiedlicher Varianten. Vor diesem Hintergrund untersucht unsere Studie die Auswirkungen der Action Space Wahl auf verschiedene Aufgaben und Roboter mit unterschiedlichen Dynamiken (siehe Abb. 1).

© Fraunhofer IML, MIT, NVIDIA.

Generalisierter Action Space

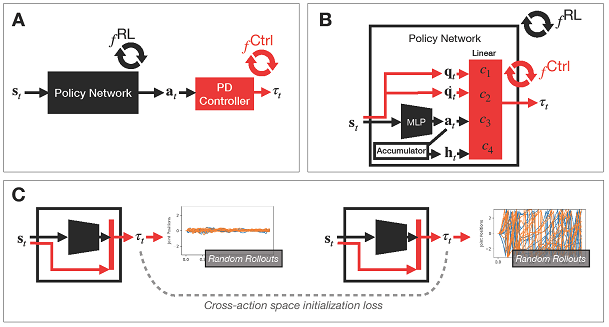

Zu diesem Zweck führen wir eine generalisierte Parametrisierung von Action Spaces ein, die eine einheitliche Darstellung gängiger, konfigurationsbasierter Aufgaben ermöglicht (siehe Abb. 2). In RL kann die Umwandlung von Policy-Ausgaben, Zuständen und historischen Informationen in Drehmomentbefehle beschrieben werden. Obwohl dieses Rahmenwerk sowohl aufgabenbezogene als auch konfigurationsbezogene Action Spaces umfasst, konzentriert sich unsere Studie auf konfigurationsbasierte Steuerung, die Gelenkpositionen, Geschwindigkeiten und Drehmomente umfasst.

Wir identifizieren gängige Action Spaces innerhalb dieses Rahmens. Wenn Befehls- und Drehmomentaktualisierungen mit der gleichen Frequenz erfolgen, können diese Action Spaces als lineare Abbildungen von Zustand und Aktion auf Drehmoment dargestellt werden. Dieser Ansatz verdeutlicht intuitive Zusammenhänge zwischen Action Spaces; beispielsweise kann Delta-Positionssteuerung mit einem einfachen Integrator einem Drehmomentregelungsansatz mit einem Dämpfungsterm entsprechen, und Delta-Geschwindigkeitssteuerung kann mit Drehmomentregelung übereinstimmen.

Die generalisierte Parametrisierung ermöglicht zudem die Interpretation der beteiligten Parameter als Teil der letzten Schicht des Policy-Netzwerks. Die Wahl des Action Spaces hängt damit zusammen, wie diese Parameter initialisiert werden. Dies führt zu der Frage, ob die Vorteile eines bestimmten Action Spaces aus seiner Architektur (die effektives Lernen erleichtert) oder aus der richtigen Initialisierung (die die Leistung verbessert) resultieren.

© Fraunhofer IML & MIT

Praxisleitfaden für die Auswahl des Action Spaces

Unsere Ergebnisse zeigen, dass die Wahl des Action Spaces vom jeweiligen Roboter und der zu lernenden Aufgabe abhängt. Hier sind einige Richtlinien zur Auswahl des richtigen Action Spaces für neue Robotikaufgaben:

- Einfluss der Dynamik: Der gewählte Action Space beeinflusst das Lernen erheblich in Abhängigkeit der Dynamik des Roboters. Zwei Roboter können sogar gegensätzliche Trends in der Wahl des Action Spaces für dieselbe Lernaufgabe zeigen. Daher sollten die Bewegungsweise und Dynamik des Roboters berücksichtigt werden. Positionssteuerung kann hilfreich sein, wenn Gelenke in einer bestimmten Position gehalten werden sollen, und Drehmomentsteuerung, wenn eine kontinuierliche Drehbewegung erforderlich ist.

- Tunen von Explorationsverhalten: Die Wahl des Action Spaces beeinflusst das Explorationsverhalten. Für manche Aufgaben kann eine gezielte Anpassung der anfänglichen Exploration die Leistungsunterschiede zwischen Action Spaces erheblich reduzieren. Die Visualisierung von Position, Geschwindigkeit und Drehmoment mit einer untrainierten Policy kann wertvolle Einblicke liefern. Darüber hinaus kann ein Einstieg mit Imitationslernen helfen, Verhaltensweisen aus verschiedenen Action Spaces zu kombinieren.

- Übertragbarkeit von Action Spaces: Obwohl es deutliche Unterschiede in der RL-Leistung zwischen Action Spaces geben kann, lassen sich effektive Policies oft über verschiedene Action Spaces hinweg mit ähnlichen Ergebnissen anpassen. Die Wahl geeigneter Reglerparameter hingegen kann das Lernen für eine Aufgabe erheblich verbessern. Falls ein späterer Transfer der Policy notwendig wird, kann ein Teacher-Student Ansatz die Übertragung ermöglichen.

- Einfluss der Regelungsfrequenz: Das Verhalten der Policy zwischen den Zeitschritten kann die finale Leistung beeinflussen, wobei die Effekte variieren können. Unsere Ergebnisse zeigen, dass eine enge Abstimmung zwischen Hoch- und Niedrigfrequenzsteuerung vorteilhaft ist. In vielen Fällen scheint es vorteilhaft zu sein die Policy mit hoher Frequenz laufen zu lassen, ohne Frames zu überspringen, um eine bessere Leistung zu erzielen.

Zusammenfassung

Diese Studie hat die Auswirkungen der Action Space Wahl auf das Lernen für verschiedene Roboterplattformen untersucht. Unsere Ergebnisse zeigen, dass die Wahl des Action Spaces das Lernen erheblich beeinflusst. So können unterschiedliche Roboter sogar gegensätzliche Trends für die gleiche zu lernende Aufgabe aufzeigen, was die Notwendigkeit einer dynamikbasierten Auswahl des Action Spaces unterstreicht.

Wir fanden zudem heraus, dass eine gezielte Anpassung des Explorationsverhaltens helfen kann, Leistungsunterschiede zwischen Action Spaces für bestimmte Aufgaben zu verringern. Diese Strategie ist jedoch nicht universell wirksam, was die aufgabenabhängige Natur der Exploration unterstreicht. Darüber hinaus können effektive Policies trotz Leistungsunterschieden zwischen Action Spaces oft mit ähnlichem Erfolg angepasst werden. Dies zeigt, dass die Charakteristiken eines Action Spaces zwar wichtig sind, aber nicht zwangsläufig die optimale Leistung bestimmt. Schließlich konnte eine enge Wechselwirkung zwischen der Abstimmung der Regelungsfrequenz und der Action Space Darstellung identifiziert werden, was die Komplexität der Optimierung von Action Spaces in Bezug auf zeitliche Steuerungsparameter verdeutlicht.

Insgesamt zeigen unsere Erkenntnisse, dass die Auswahl des Action Spaces die Lernleistung aufgabenabhängig stark beeinflussen kann. Die praktischen Auswirkungen von Action Spaces lassen sich primär auf eine verbesserte Initialisierung der Policies und das Verhalten zwischen Zeitschritten zurückführen. Dies liefert wertvolle Erkenntnisse zur Optimierung des robotischen Lernens und der Steuerung über verschiedene Plattformen und Aufgaben hinweg.

Weitere Details zur Methodik, den Benchmarking-Ergebnissen und dem Trainingssetup sind in der Open-Source Publikation aufgezeigt, welche auf der Conference on Robot Learning (CoRL) 2024 vorgestellt wurde.