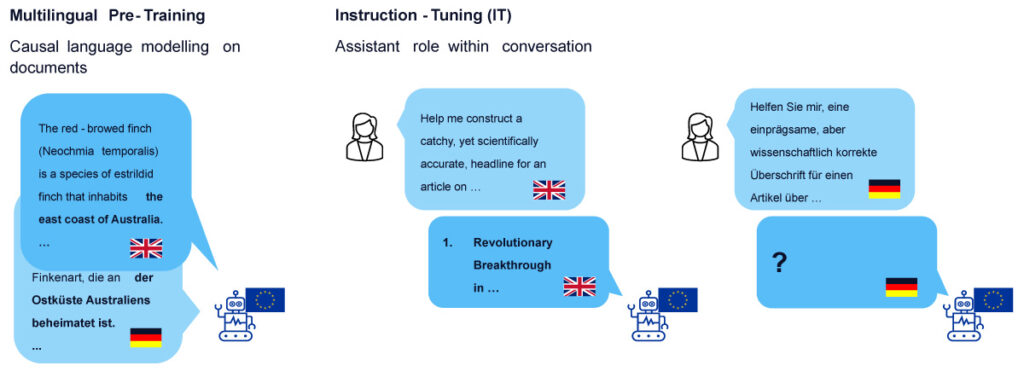

Einführung in das multilinguale Instruction-Tuning

Angesichts der sich stetig weiterentwickelnden Landschaft großer Sprachmodelle (LLMs) hat sich das Instruction-Tuning mit multilinguale Daten zu einem wichtigen Schwerpunktbereich entwickelt. Die Studie, die im Rahmen des OpenGPT-X-Projekts durchgeführt wurde – mit dem Ziel, ein europäisches mehrsprachiges LLM zu entwickeln, das auf die Bedürfnisse von Unternehmen und Forschung zugeschnitten ist -, untersucht die Auswirkung von mehrsprachigem Instruction-Tuning auf die Leistung mehrsprachiger Modelle und geht dabei auf drei wesentliche Herausforderungen ein:

- Datenverfügbarkeit: Wie können wir mehrsprachige Instruction-Tuning-Daten erstellen?

- Datenzusammensetzung: Wie kann man ein mehrsprachiges, vortrainiertes Modell mit Instruktionen optimieren?

- Modell-Auswertung: Wie kann man diese Modelle effektiv evaluieren?

Daraus ergab sich die zentrale Problemstellung:

Für ein mehrsprachiges Modell – d.h. ein Modell, das größtenteils auf nicht-englischen Dokumenten vortrainiert wurde – stellt sich die Frage, welche sprachliche Zusammensetzung der Konversation am besten geeignet ist, um das Modell in die Lage zu versetzen, Anweisungen in verschiedenen Sprachen zu befolgen.

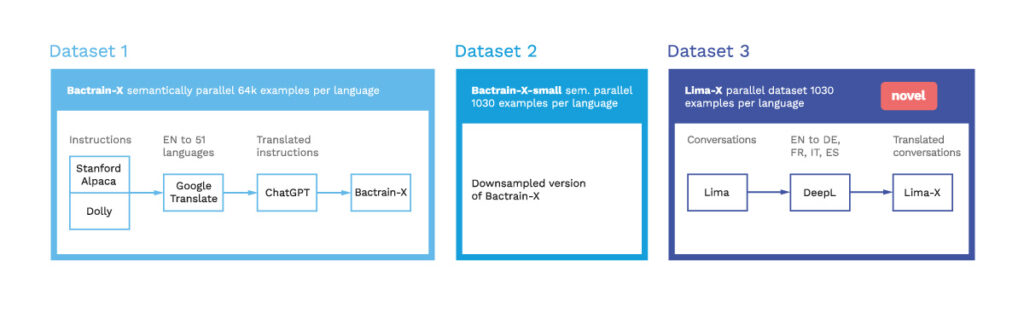

Die Entwicklung mehrsprachiger Datensätze für das Instruction-Tuning

Vor dem Hintergrund dieser zentralen Frage wurde der Bedarf an Datensätzen für die verschiedenen Zielsprachen evident. Während der Bactrian-X-Datensatz eine großartige Quelle quasi-paralleler Beispiele von Konversationen darstellte – indem die Antworten des GPT-3.5-Modells auf übersetzte Anweisungen zur Erstellung genutzt wurde – schlug das damals viel diskutierte LIMA-Papier, die Superficial Alignment Hypothesis, vor, dass ein kleiner, aber qualitativ hochwertiger Datensatz für instruction-tuning ausreicht, um zu lernen Anweisungen zu befolgen. Die Autoren stellten die hohe Qualität von LIMA sicher, indem der Datensatz manuell kuratiert wurde. Daher haben wir neben Bactrian-X auch Lima-X erstellt und veröffentlicht, indem wir die Anweisungen und Antworten übersetzten, um einen parallelen Datensatz für Englisch, Deutsch, Spanisch, Französisch und Italienisch zu erhalten.

Versuchsaufbau und Trainingsstrategie

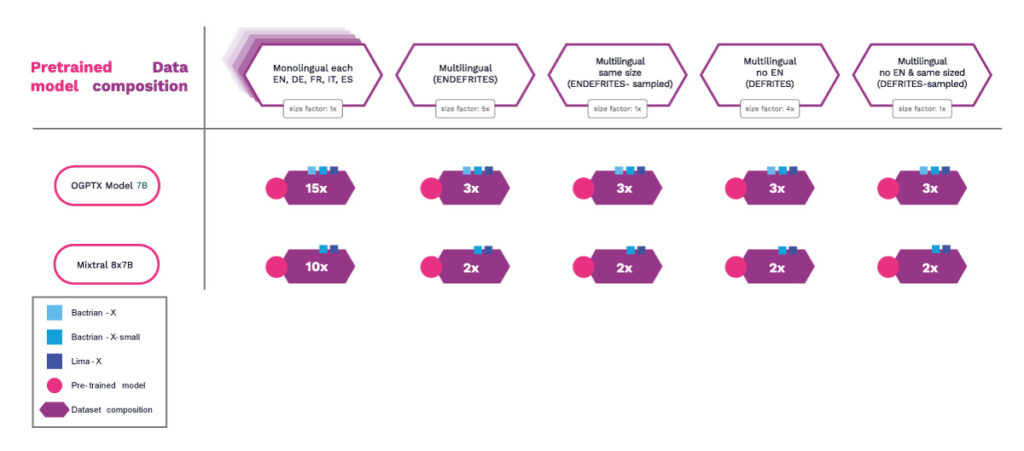

In Anbetracht dieser parallelen und semantisch parallelen Datensätze haben wir einen sorgfältigen Versuchsaufbau entworfen, um verschiedene Datensatzzusammenstellungen auf ihre Effektivität beim mehrsprachigen Training zu vergleichen. Die ausgewählten Datensätze ermöglichen es uns, verschiedene Aspekte zu untersuchen:

- Auswirkung der Art des Datensatzes: Vergleich des gleich großen, manuell kuratierten Datensatzes (Lima-X) mit dem synthetisch erzeugten Datensatz (Bactrian-X-small).

- Einfluss der Größe des Datensatzes: Da Bactrian-X-small 1.030 Konversationen enthält und der vollständige Bactrian-X-Datensatz 64.000 Konversationen umfasst, können wir beurteilen, wie sich eine Vergrößerung der Datenmenge, die aus der gleichen Verteilung stammt, auf die sprachübergreifende Leistung auswirkt.

- Auswirkungen der Sprachzusammensetzung: Die Bewertung einsprachiger Datensätze im Vergleich zu mehrsprachigen und semantisch parallelen Datensatzzusammensetzungen wie ENDEFRITES (Bedeutung: Englisch (EN), Deutsch (DE), Französisch (FR), Italienisch (IT) und Spanisch (ES)) und semantisch nicht überlappende Datensatzzusammensetzungen wie ENDEFRITES-sampled, um einen fairen Vergleich mit einsprachigen Datensätzen zu gewährleisten.

- Einfluss der vorherrschenden Sprache (Englisch): Untersuchung des Einflusses des Einbezugs oder Weglassens von Englisch in den Datensätzen (Vergleich von ENDEFRITES mit DEFRITES und ENDEFRITES-sampled mit DEFRITES-sampled).

- Einfluss der Modellgröße: Die Experimente wurden mit zwei Modell-Checkpoints durchgeführt: einem OpenGPT-X-Checkpoint mit 7B-Parametern, der auf 1 Milliarde Token trainiert wurde, und dem größeren 8x7B-Mixtral-Modell.

Wir haben jedes Modell auf jeder Datensatzzusammensetzung trainiert, mit Ausnahme von Mixtral-8x7B-Bactrian-X, da die verfügbaren Rechenressourcen nicht ausreichten, um das große Modell auf dem großen Datensatz zu trainieren, wie oben in Abbildung 3 gezeigt.

Bewertungsmethodik

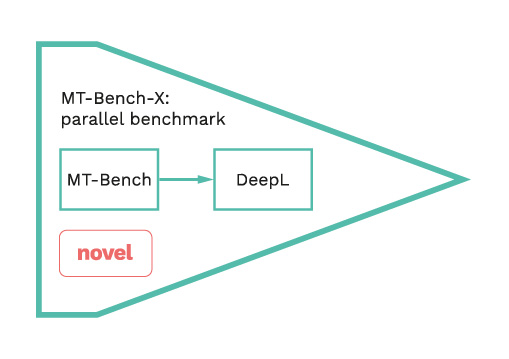

Um die Herausforderung einer effektiven Bewertung in mehreren Sprachen zu bewältigen, haben wir den damaligen De-facto-Standard MT-Bench übernommen und ihn zu MT-Bench-X erweitert. Der ursprüngliche Datensatz besteht aus 80 Konversationen mit jeweils zwei Nutzerfragen/ -instruktionen und jeweils zehn Beispielen aus den acht Kategorien:

- Mathematik

- Programmieren

- Schlussfolgern

- Extraktion

- Schreiben

- Rollenspiel

- MINT, und

- Geisteswissenschaften

Um MT-Bench auf mehrere Sprachen auszuweiten, haben wir 320 zusätzliche Beispiele hinzugefügt, indem wir die Fragen und Referenzen vom Englischen ins Deutsche, Französische, Italienische und Spanische übersetzt haben. Daraus entstand der neue Evaluierungs-Benchmark MT-Bench-X, der speziell für die Berwertung von mehrsprachigen Instruction-Tuning Modellen entwickelt wurde.

In Anbetracht der Bedeutung einer richtigen Bewertung und angesichts der Tatsache, dass die menschliche Bewertung der höchste Standard ist, haben wir die Übersetzungen manuell überprüft und kuratiert. Zusätzlich haben wir eine Studie zur Korrelation menschlicher Bewertung zu Berwertungen mit GPT-4 als Richter für die deutsche Sprache durchgeführt.

Die MT-Bench-Familie von Benchmarks verwendet das Konzept des LLM-as-a-judge, d.h. ein leistungsfähiges großes Sprachmodell (LLM) wird gebeten, die potenziell diversen Antworten zu bewerten, die von dem zu bewertenden Modell erzeugt werden. Bei komplexen Fragen mit eindeutiger Antwort wird dem LLM-as-a-judge die richtige Antwort gegeben.

Ergebnisse und Analyse

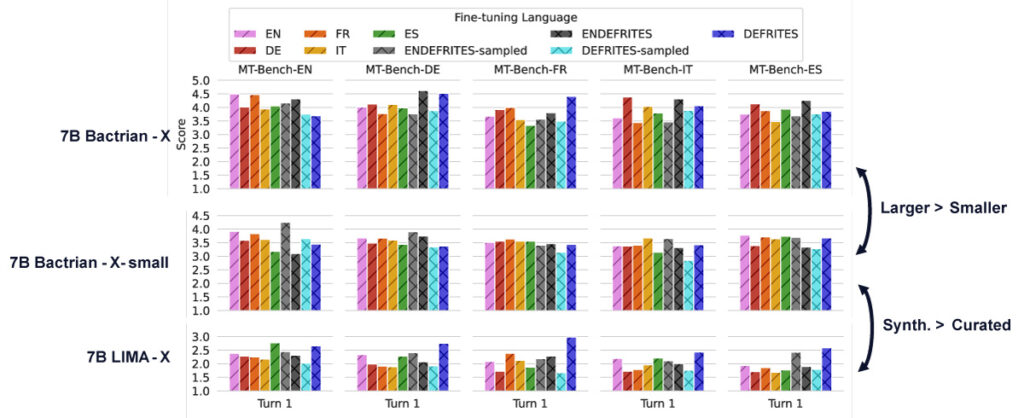

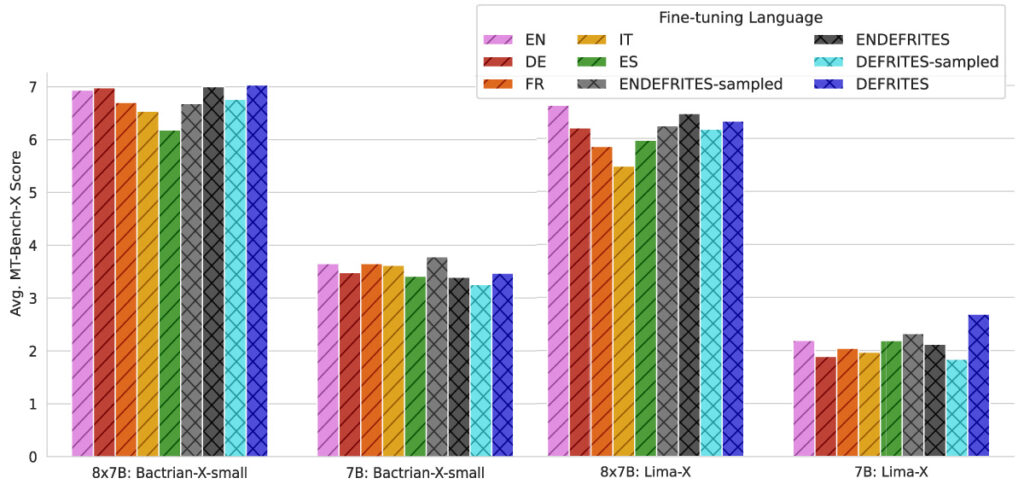

Wir haben alle Modellvarianten, die auf den verschiedenen Sprachmischungen trainiert wurden, in allen von MT-Bench-X unterstützten Sprachen evaluiert, mit folgenden Ergebnissen.

Einsprachige Auswertung

Die Ergebnisse in der Abbildung oben zeigen, dass Modelle, die auf einsprachigen Datensätzen in Sprachen wie Deutsch (Bactrian-DE), Italienisch (Bactrian-IT) und Spanisch (Bactrian-ES) trainiert wurden, im Vergleich zum mehrsprachigen Modell Bactrian-ENDEFRITES schlechter abschneiden. Gleichzeitig sticht Bactrian-EN hervor, was wahrscheinlich auf die größere Menge an englischen Daten in seinem Pre-Training zurückzuführen ist. Interessanterweise übertrifft Bactrian-FR das Modell Bactrian-ENDEFRITES in den französischen Benchmarks. Insgesamt ist kein klarer Vorteil für Modelle zu erkennen, die auf vollständig parallele gemischtsprachige Daten in der einsprachigen Auswertung optimiert wurden. Bactrian-X-small schneidet ähnlich ab, allerdings auf einem niedrigeren Niveau als Bactrian-X.

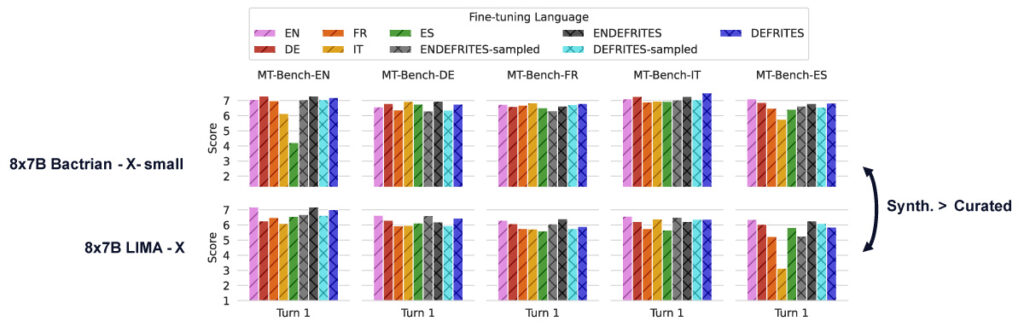

Die größeren Mixtral-8x7B-Modelleerreichen durchweg höhere Leistung als die 24EU-7B-Modelle, die aus dem OpenGPT-X-Checkpoint stammen. Während instruction-tuning auf sprachübergreifenden Datensätzen die einsprachige Leistung für einige Modelle, wie Bactrian-X-small und Lima-X, tendenziell verbessert, bleibt dieser Effekt bei der Verwendung von gemischtsprachigen Finetuning-Strategien wie DEFRITES oder ENDEFRITES sprachübergreifend inkonsistent. Insgesamt gibt es kein klares Muster in der einsprachigen Leistung.

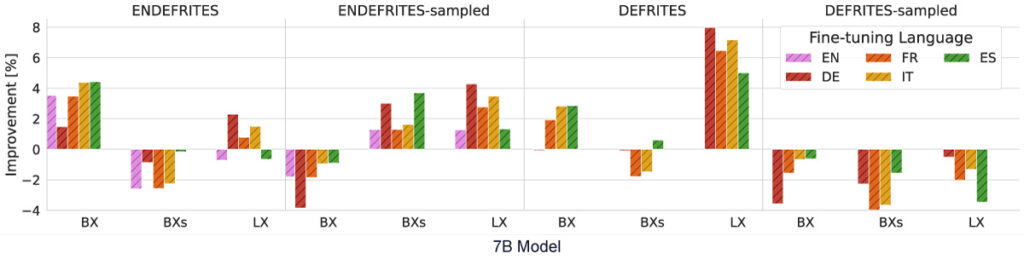

Sprachübergreifende Auswertung

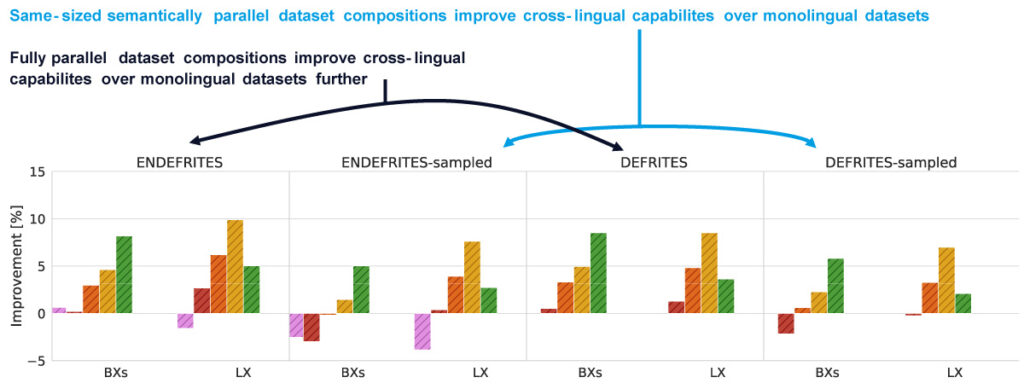

Vergleicht man die Modellleistung zwischen den Evaluierungssprachen anhand der durchschnittlichen MT-Bench-X-Ergebnisse, so zeigt sich ein klares Muster: Das sprachübergreifende instruction-tuning liegt vorn. Wenn wir diesen Trend in der folgenden Abbildung genauer untersuchen, in der wir die sprachübergreifende Leistung von Modellen, die auf einsprachigen Datenkompositionen trainiert wurden, von der sprachübergreifenden Leistung von Modellen, die auf mehrsprachigen Daten trainiert wurden, subtrahieren, sehen wir, dass die sprachübergreifende Abstimmung in den meisten Fällen besser abschneidet als einsprachige Ansätze.

In der Abbildung wird die Leistung von Modellen, die auf parallelen Sprachmischungen trainiert wurden, mit einsprachigen Datensätzen verglichen.

Jeder Balken stellt die prozentuale Verbesserung eines mehrsprachigen Instruction-Tunings ((EN)DEFRITES, (EN)DEFRITES-sampled) im Vergleich zu einem einsprachigen Modell (EN, DE, FR, IT, ES) auf der Datensatzvariante (BX: Bactrian-X, BXs: Bactrian-X-small, LX: Lima-X) dar.

Wichtige Beobachtungen

- Mehrsprachiges Tuning steigert die Leistung: Bei 24EU-7B-basierten Modellen steigert die mehrsprachige Abstimmung mit ENDEFRITES-Samples die Leistung von Lima-X und Bactrian-X-small, aber nicht von Bactrian-X. Modelle, die mit DEFRITES-geprüften Daten trainiert wurden, schneiden schlechter ab als ihre einsprachigen Gegenstücke, was wahrscheinlich auf einen geringeren Stichprobenumfang zurückzuführen ist. Mixtral-8x7B-Modelle zeigen mit wenigen Ausnahmen konsistente Gewinne durch paralleles instruction-tuning.

- Die Größe des Datensatzes spielt eine Rolle: Größere Datensätze, wie ENDEFRITES und DEFRITES in voller Größe, verbessern die Leistung in allen Sprachen, insbesondere für Bactrian-X und Lima-X.

- Einbeziehung von Englisch ist vorteilhaft: Die Einbeziehung der dominanten Pre-Trainingssprache (ENDEFRITES vs. DEFRITES) verbessert die Tuning-Ergebnisse. Down-sampled-Varianten schneiden schlechter ab, wahrscheinlich aufgrund eines geringeren Signal-Rausch-Verhältnisses in Bactrian-X.

- Die Modellgröße beeinflusst die Ergebnisse: Größere Modelle wie Mixtral-8x7B erzielen bis auf wenige Ausnahmen durchweg höhere Werte.

Im Gegensatz dazu sind sorgfältig kuratierte Datensätze wie LIMA-X widerstandsfähiger gegen diesen Leistungsabfall. Die größere Größe von Mixtral-8x7B kompensiert wahrscheinlich das Rauschen in kleineren Datensätzen wie Lima-X, mit maximalen Leistungsgewinnen von bis zu 9,9 % (0,99 Punkte) für Lima-ENDEFRITES gegenüber Lima-IT.

Insgesamt verbessert das Feintuning auf parallelen Daten das mehrsprachige instruction-tuning für mittelgroße bis große Modelle und übertrifft das einsprachige Training.

Synthetische vs. kuratierte Trainingsdatensätze

Um den Einfluss der Art des Datensatzes zu isolieren, haben wir die synthetischen Bactrian-X-Datensätze so verkleinert, dass sie der Größe der von Menschen kuratierten LIMA-X-Datensätze entsprechen, wodurch Bactrian-X-small entstand. Wie in Abbildung 10 dargestellt, übertrafen die synthetischen Bactrian-X-Datensätze LIMA-X bei beiden Datensatzgrößen. Beim Vergleich von LIMA-X mit Modellen, die auf Bactrian-X-small in voller Größe (Abbildung 9) abgestimmt wurden, zeigt sich ein klarer Trend: Die sprachübergreifende Leistung verbessert sich mit parallelem, Bactrian-X-basiertem instruction-tuning. Diese Ergebnisse unterstreichen die Vorteile der Verwendung synthetischer, semantisch paralleler Datensätze für die mehrsprachige Abstimmung.

Generalisierbarkeit der Superficial Alignment Hypothese

Wir untersuchten die Superficial Alignment Hypothese, die besagt, dass nur wenige Beispiele pro Instruktionstyp nötig sind, um einem Modell beizubringen, Anweisungen zu befolgen. Unsere Ergebnisse stellen diese Vorstellung jedoch in Frage. Die folgende Abbildung zeigt dies:

- Mid-Size-Modelle erfordern umfangreiche Daten: Modelle der gleichen Größe, die auf Bactrian-X-small abgestimmt sind, übertreffen durchweg diejenigen, die auf den kuratierten LIMA-X-Datensätzen abgestimmt sind.

- Größere Modelle zeigen andere Trends: Bei dem größeren Modell Mixtral-8x7B sehen wir eine hohe Leistung sowohl bei synthetischen als auch bei kuratierten Daten, was darauf hindeutet, dass die Superficial Alignment Hypothese mit größeren Modellen oder fortgeschrittenerem Pre-Training effektiver werden kann.

Ergebnisse der menschlichen Bewertung

Wir haben die Ergebnisse von Zheng et al. (2023) für das Deutsche erweitert und die Ähnlichkeiten und Unterschiede zwischen menschlicher Bewertung und der Bewertung mit GPT-4 als Richter analysiert. Wir stellen Unterschiede zwischen menschlichen Bewertungen und den von GPT-4 generierten Bewertungen in mehrsprachigen Chatszenarien fest. Weitere Details finden Sie in unserem Paper.

Key Takeaways

- Parallele Datensätze verbessern die sprachenübergreifende Leistung: Unsere Ergebnisse unterstreichen die Vorteile des instruction-tunings auf parallelen Datensätzen und zeigen Verbesserungen von bis zu 9,9% in der Fähigkeit, sprachübergreifenden Anweisungen zu folgen, im Vergleich zu einsprachigen Korpora.

- Synthetische Daten schneiden besser ab als kuratierte Daten: Synthetische Bactrian-X-Datensätze, die auf die Größe der kuratierten LIMA-X-Daten heruntergerechnet wurden, zeigten, dass Bactrian-X-small durchweg besser abschneidet als LIMA-X. Dies unterstreicht den klaren Vorteil synthetischer, semantisch paralleler Datensätze zur Verbesserung der sprachübergreifenden Leistung beim mehrsprachigen Tuning.

- Generalisierbarkeit der Superficial Alignment-Hypothese: Unsere Ergebnisse zeigen, dass umfangreiche instruction-tuning-Datensätze für mittelgroße mehrsprachige Modelle notwendig sind, aber nicht unbedingt für größere Modelle, was die Verallgemeinerbarkeit der Superficial Alignment Hypothesis in Frage stellt.

- Neue Ressourcen veröffentlicht: Wir veröffentlichen die mehrsprachige Trainingsressource Lima-X und die mehrsprachige Evaluierungsressource MT-Bench-X und leisten damit einen wertvollen Beitrag für die NLP-Gemeinschaft.

Ausblick und Einschränkungen

Obwohl unsere Studie wertvolle Einblicke in das mehrsprachige instruction-tuning von großen Sprachmodellen (LLMs) liefert, hat sie gewisse Einschränkungen. Wir haben uns darauf konzentriert, mehrsprachige instruction-tuning-Techniken zu erforschen, anstatt nach dem neuesten Stand der Technik zu streben. Außerdem beschränkte sich unsere Forschung auf germanische und Indogermanische Sprachen, so dass die Verallgemeinerbarkeit auf andere Sprachfamilien nicht getestet wurde.

Zukünftige Arbeiten sollten darauf abzielen, die Methoden des instruction-tuning auf ein breiteres Spektrum von Sprachen auszuweiten, um die globale Leistung mehrsprachiger LLMs zu verbessern. Die Untersuchung mehrsprachiger Multi-Turn-Datensätze könnte tiefere Einblicke in die komplexen Fähigkeiten zur Befolgung von Anweisungen bieten. Darüber hinaus wird die Verbesserung der Kosteneffizienz und Genauigkeit automatischer mehrsprachiger Evaluierungsmethoden der Natural Language Processing (NLP)-Gemeinschaft erheblich zugutekommen.