Zum Arbeitsalltag von vielen Unternehmen gehört das Erstellen und Überprüfen von Berichten, die finanzielle Kennzahlen – aus meist unzähligen Tabellen – in eine schriftliche Form bringen. Diese monotone und sich wiederholende Arbeit wird meist per Hand erledigt und bindet so viele zeitliche und finanzielle Ressourcen. Mit der zunehmenden Verfügbarkeit digitaler Finanz- und Rechtsdokumente ist die Forderung nach ihrer automatischen Verarbeitung von großer Bedeutung. Ziel ist es hierbei, zentrale Muster in den Texten zu extrahieren und die Benutzer*innen zu unterstützen. An dieser Stelle kann Künstliche Intelligenz (KI) ein gutes Hilfsmittel sein, um Teile dieser Arbeit zu begleiten oder komplett zu automatisieren.

Das Problem: Trotz der hohen Verfügbarkeit von Finanz- und Rechtsdokumenten werden Textverarbeitungs- oder Machine-Learning-Systeme nur selten eingesetzt. Dies liegt auch daran, dass in diesen Dokumenten sensible Informationen enthalten sind, die eine Nutzung und Verarbeitung ausschließlich für autorisierte Personen und Zwecke zulassen.

Anonymizer – ein Tool zur automatischen Anonymisierung von Berichten

Um dieses Problem zu lösen, haben wir zusammen mit PricewaterhouseCoopers (PwC) ein neues Projekt gestartet: den Anonymizer. Dieses Tool ermöglicht die automatische Anonymisierung von Finanzdokumenten. Es erkennt und zensiert empfindliche Daten, wie Orte, Personen- oder Firmennamen und andere Informationen (zum Beispiel Emails, Telefonnummern), die es ermöglichen würden, die Daten einem bestimmten Unternehmen zuzuordnen.

In unserer Zusammenarbeit und Entwicklung des Anonymizer-Tools ermöglichte PwC die Bereitstellung der Trainingsdaten, indem es die sensiblen Informationen in finanziellen Berichten vorab annotierte. Modelle des Maschinellen Lernens konnten in der Folge auf diesen Daten lernen, ohne dass vertrauliche Daten einen autorisierten Empfängerkreis verließen. Auf der Grundlage neuester Erkenntnisse aus dem Forschungsfeld maschineller Lernverfahren entwickelte ein Team des Lamarr Instituts und des Fraunhofer IAIS sodann neue Methoden, um sensible Informationen aus Finanzdokumenten automatisch zu anonymisieren. PWC-Mitarbeitende unterstützten die Entwicklung der ML-Verfahren mit ihrem domänenspezifischen Expertenwissen und evaluierten die Ergebnisse. Das so entstandene Anonymizer-Tool beschreiben wir im Folgenden.

Durch numerische Wortrepräsentationen Beziehungen zwischen Wörtern erkennen

Das Anonymizer-Tool soll empfindliche Daten, wie Orte, Personen- oder Firmennamen und andere Informationen automatisch erkennen und zensieren. In der Forschung ist dieses Problem unter dem Namen „Named Entity Recognition“ (NER) oder Eigennamenerkennung bekannt und bezeichnet die automatische Identifikation und Klassifikation von Eigennamen. Ein Eigenname ist eine Folge von Wörtern, die eine real existierende Entität beschreibt, zum Beispiel ein Firmenname.

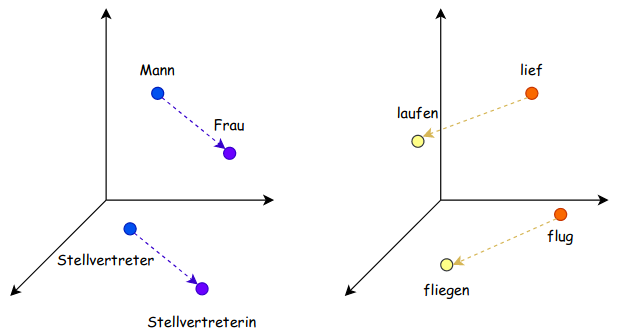

Der erste Schritt bei der Erstellung des Anonymizers konzentrierte sich auf die Einbettung der Wörter in einen Vektorraum. Die Idee dahinter ist es eine numerische Repräsentation für Wörter zu finden, in der Wörter mit ähnlicher Bedeutung auch ähnliche Repräsentationen besitzen. So sollten zum Beispiel die Wörter „Affe“ und „Schimpanse“ in diesem Raum nahe beieinander liegen. Außerdem ermöglicht die numerische Darstellung eine Durchführung mathematischer Operationen, die Wörter in Beziehung setzen (siehe Abbildung 1). Modelle, die auf diesen Repräsentationen trainiert werden, können diese Beziehungen lernen und in ihre Vorhersagen miteinbeziehen.

Diese Abbildung zeigt mögliche numerische Beziehungen zwischen Wortrepräsentationen in einem Vektorraum. Die linke Grafik zeigt, dass die Differenz zwischen dem Vektor für das Wort „Mann“ und dem Vektor für das Wort „Frau“ in etwa der Differenz entspricht (oberer violetter Pfeil), die sich aus den Vektoren der beiden Wörter „Stellvertreter“ und „Stellvertreterin“ ergibt (unterer violetter Pfeil).

Neben der klassischen Einbettung von Wörtern in einen Vektorraum, beziehen moderne Einbettungen zusätzlich auch den Kontext des Satzes mit ein. Diese Einbettungen basieren meist auf bekannten Sprachmodellen, die auf Millionen von Wörtern aus großen Textdatensätzen trainiert worden sind. Diese Sprachmodelle können Wörter, die mehrere Bedeutungen haben, anhand ihres Kontextes unterscheiden. Beispielsweise wird dem Wort „Vogel“ in den Sätzen „Der frühe Vogel fängt den Wurm.“ und „Mein Hausarzt ist Dr. Vogel.“ jeweils eine unterschiedliche Repräsentation zugewiesen. In unserer Anwendung verwenden wir Flair, welches zu den modernen, kontextbezogenen Einbettungen gehört.

Klassifikation mittels Rekurrenter Neuronaler Netze und Conditional Random Fields

Im zweiten Schritt der Anonynmizer-Entwicklung haben wir ein rekurrentes neuronales Netz (RNN) anhand der eingebetteten Wörter trainiert. Das RNN sagt hierbei vorher, zu welcher Entität die Wörter gehören (zum Beispiel per für Personen oder org für Organisation). Durch Rückkopplungen in der Architektur ermöglicht ein rekurrentes neuronales Netz eine Art Gedächtnis, indem vorherige Eingaben immer wieder in das neuronale Netz eingespeist werden. Ähnlich der modernen Einbettung können somit die bereits eingespeisten Wörter erneut in die Klassifizierung des jetzigen Wortes mit einbezogen werden.

Im dritten Schritt wurden die vorhergesagten Entitäten als Sequenz betrachtet und von einem Conditional Random Field (CRF) beurteilt. Ein CRF ist ein probabilistisches Modell, das bewertet wie wahrscheinlich es ist, dass die Elemente in der Eingabesequenz in dieser Abfolge auftauchen. Dazu wird dieses Modell zunächst auf den Trainingsdaten trainiert und lernt, welche Sequenzen häufig vorkommen und weist diesen bei der Vorhersage einen höheren Wert zu. Wenn beispielsweise das RNN für drei aufeinanderfolgende Wörter die Klassen per, per und org vorhersagt, könnte es sich hierbei um eine Sequenz handeln, die nur selten vorkommt. Vielleicht handelt es sich eher um einen Firmennamen, der einen Personennamen enthält (org, org, org) oder um eine Aufzählung von Personen (per, per, per). Dies lässt sich gut am Beispiel des „Robert-Koch-Instituts“ darstellen. Das CRF muss hier entscheiden, ob es sich um eine Organisation (org, org, org) oder um eine Aufzählung von Personen (per, per, per) handelt.

Ergebnisse und Qualität der Anonymisierung

Bei der Anonymisierung betrachten wir den binären Fall für die Klassifikation: Entweder gehört das Wort zur Klasse der empfindlichen Wörter und soll anonymisiert werden oder nicht. Dabei gibt es zwei wichtige Kriterien, an denen man die Qualität der Anonymisierung messen kann:

- Wie präzise ist die Klassifikation (Precision), das heißt, wie viele der Vorhersagen waren auch korrekt?

- Wie viele der empfindlichen Informationen wurden auch gefunden und zensiert (Recall)?

Diese beiden Metriken balancieren sich gegenseitig aus. Stützt man sich nur auf sichere Vorhersagen, kann man leicht die Präzision erhöhen, verliert aber im Gegenzug Punkte im Recall, weil sensible Wörter übersehen werden. Für jede ML-Anwendung müssen die passenden Kriterien ausgewählt und gewichtet werden. Im Anwendungsfall von Finanzberichten spielt so der Recall eine größere Rolle, da der Fokus darauf liegt, möglichst alle empfindlichen Daten zu finden. Denn, wenn das Tool es nicht schafft, die meisten sensiblen Daten zu erkennen, dann müssen die verbliebenden sensiblen Daten manuell entfernt werden, was den Nutzen dieser Automatisierung und dessen Skalierbarkeit stark verringert.

In unserem Tool erreicht das trainierte Modell auf den Testdaten eine nahezu perfekte Anonymisierung (99% Recall). Dabei ist erfreulich, dass trotz der Priorisierung des Recall das Gesamtmodell eine Präzision von über 90% hält. Das bedeutet, dass einerseits fast alle sensiblen Daten (99%) von dem Tool entdeckt und anonymisiert werden und andererseits selten Text fälschlicherweise anonymisiert wird.

Anonymizer: Anwendung in der Praxis

Um die Nutzung des Tools so handlich wie möglich zu machen, haben wir zwei Nutzungsmöglichkeiten erstellt: Der Anonymizer existiert als Command-Line-Tool oder kann über eine Web-Applikation bedient werden.

Dies ist ein Beispiel der Web-Applikation. Der linke Bereich enthält die Bedienelemente zum Hochladen des Dokuments und andere Einstellungen. Rechts befindet sich das Dokumentenfenster, das den Inhalt des Dokuments anzeigt. Die Web-Applikation zeigt farblich, welche Entitäten gefunden wurden und zu welcher Gruppe sie gehören, bevor sie anonymisiert werden. Anschließend ist das Dokument mit den zensierten sensiblen Informationen zu erkennen.

Die Web-Applikation ist eine webbasierte Anwendung, die es dem Benutzer ermöglicht, Textdokumente hochzuladen und die anonymisierten Inhalte zu visualisieren (siehe Abbildung 2). Die Oberfläche enthält zwei Bereiche: einen linken Bereich mit Steuerelementen und einen rechten Bereich, in dem das anonymisierte Dokument dargestellt wird. Die sensiblen Entitäten werden je nach Typ in verschiedenen Farben hervorgehoben. In der vorstehenden Abbildung sind die Namen von Personen, Unternehmen und Orten in rot, grün beziehungsweise blau hervorgehoben. Außerdem gibt das Tool den Benutzer*innen die Möglichkeit, die Maskierung zu aktivieren, sodass sensible Objekte komplett geschwärzt werden. Sobald das Dokument anonymisiert ist, ermöglicht das Tool den Benutzer*innen das verarbeitete Dokument herunterzuladen. Dieses ist frei von sensiblen Elementen ist.

Das Command-Line-Tool bietet den Benutzer*innen eine Schnittstelle zu den Funktionen des Anonymizers. Somit kann der Anonymizer leicht in andere Abläufe und Projekte eingebaut werden. Zusätzlich kann das Command-Line-Tool dazu verwendet werden, um im Schnelldurchgang Tausende von Dokumenten zu anonymisieren. Zu diesem Zweck können Anwender*innen eine Vorlage erstellen, welche die Einstellungen für den Vorgang festlegt oder diese über die Konsole mitgeben.

Zusammenfassend ermöglicht uns das Anonymizer Tool die Anonymisierung sensibler Informationen, zum Beispiel Namen von Personen, Orten, Organisationen, Nummern, Telefonnummern, Daten und URLs, in einem Schriftstück. Die sensiblen Informationen können sowohl durch Schwärzen von Text als auch durch Ersetzen von Textbausteinen mit generischen Tags in allen gängigen Dateiformaten anonymisiert werden. Dazu verwenden wir modernste Techniken des Deep Learning, der natürlichen Sprachverarbeitungstechniken sowie einer regelbasierten Nachbearbeitung. Schlussendlich löst der Anonymizer den Engpass in der Weitergabe von Dokumenten und erleichtert die Benutzung von KI-Lösungen im Finanzsektor und Unternehmen im Allgemeinen.

Mehr Informationen in der zugehörigen Publikation:

Leveraging Contextual Text Representations for Anonymizing German Financial Documents D. Biesner, R. Ramamurthy, M. Lübbering, B. Fürst, H. Ismail, L. Hillebrand, A. Ladi, M. Pielka, R. Stenzel, T. Khameneh, V. Krapp, I. Huseynov, J. Schlums, U. Stoll, U. Warning, B. Kliem, C. Bauckhage, R. Sifa. AAAI Workshop on Knowledge Discovery from Unstructured Data in Financial Services at KDF, 2020, PDF.