Bereits heute finden Methoden des Maschinellen Lernens in vielen Situationen des alltäglichen Lebens ihre Anwendung. Ob beim autonomen Fahren, wo eine Künstliche Intelligenz (KI) für die Identifizierung von Fußgängern und Kreuzungen eingesetzt wird, oder aber bei der Entsperrung von modernen Smartphones und Laptops mittels Gesichtserkennung. Sobald eine KI Entscheidungen über Menschen trifft, ist es essentiell wichtig, dass die Entscheidungsprozesse sowohl für Experten als auch Anwender nachvollziehbar sind.

Wird eine KI beispielsweise im Kontext des autonomen Fahrens eingesetzt, ist es für die Akzeptanz und den Einsatz der Technologien in der Bevölkerung unabdingbar, dass ein Vertrauen in die korrekte Entscheidung solcher Methoden besteht. Es muss zudem sichergestellt werden, dass der einer KI zugrunde liegende Algorithmus keine inhärenten Vorurteile gelernt hat. So darf etwa im Zuge einer automatisierten Entscheidung über die Kreditwürdigkeit eines Menschen keine Benachteiligung auf der Grundlage von Herkunft, Geschlecht o.ä. erfolgen. Auch die seit 2018 in allen Mitgliedsstaaten der Europäischen Union angewandte Datenschutz-Grundverordnung (DSGVO) ist Gegenstand einer aktuellen Debatte unter Experten*innen. Diskutiert wird in diesem Zusammenhang, ob die DSGVO allen Bürgerinnen und Bürgern das Recht auf eine Erklärung einräumt, sofern eine sie betreffende Entscheidung mittels automatisierter Verfahren – zum Beispiel Methoden des Maschinellen Lernens – getroffen wurde.

Komplexe Verfahren transparent machen

Im Forschungsbereich des Maschinellen Lernens taten sich in den letzten Jahren die sogenannten neuronalen Netze als beliebte Methode zur Lösung von Entscheidungsproblemen hervor. Beispielsweise können neuronale Netze aus Bildern lernen, welche Objekte im jeweiligen Bild abgebildet sind. Diese Art von Entscheidungsproblem wird als Klassifikation bezeichnet. Anders als für viele vorangegangene Methoden ist es für die konkreten Entscheidungsprozesse neuronaler Netze jedoch aufgrund ihrer Komplexität deutlich schwieriger bis nahezu unmöglich, diese direkt nachzuvollziehen. Im Kontrast zu anderen Methoden des Maschinellen Lernens, welche ebenfalls Bilder klassifizieren können, erreichen neuronale Netze allerdings häufig eine höhere Genauigkeit bei ihren Entscheidungen. Im Allgemeinen gibt es im Feld des Maschinellen Lernens eine Abwägung zwischen simplen, oft nicht ausreichend genauen Methoden und komplexen Methoden mit einer hohen Genauigkeit.

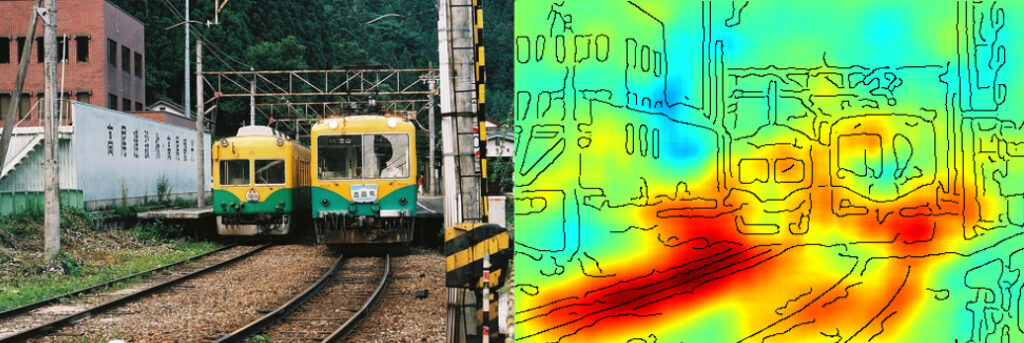

Heutige Forschung zur Erklärbarkeit Künstlicher Intelligenz fokussiert sich deshalb häufig darauf, den Entscheidungsprozess von komplexen neuronalen Netzen transparenter zu machen. Ein Ansatz zur Erklärbarkeit ist der Versuch, zu jedem für die Entscheidung relevanten Merkmal eine passende Gewichtung zu finden. Für eine einzelne Entscheidung, zum Beispiel ob ein Mensch kreditwürdig ist, können das Alter des Menschen, die Ausgaben im letzten Jahr sowie vorangegangene Bewertungen zur Kreditwürdigkeit ausschlaggebende Merkmale sein. Eine hohe und positive Gewichtung bedeutet dann, dass die Kreditwürdigkeit im positiven Zusammenhang zum Merkmal steht. Wenn die Merkmale in Bildform vorliegen, lassen sich solche Gewichtungen als Bild darstellen, in welchem jedem Pixel ein Gewicht zugeordnet wird. Hohe Gewichte werden hierbei oftmals in einem markanten Rot visualisiert, während niedrige Gewichte in Blautönen dargestellt werden.

Hohe Genauigkeit alleine reicht nicht aus

Die nachstehende Abbildung verdeutlicht eine Visualisierung von Entscheidungsgewichtungen. Im konkreten Anwendungsfall sollte ein System mittels automatisierter Lernverfahren entscheiden, ob das vorgelegte Foto einen Zug abbildet. Zunächst fiel den Forscher*innen auf, dass das neuronale Netz sehr genau Bilder mit Zügen von solchen ohne Züge unterscheiden konnte. Durch die transparente Aufschlüsselung des Entscheidungsprozesses zeigte sich jedoch, dass der Algorithmus nicht erfolgreich die Identifizierung von Zügen gelernt hatte. Stattdessen basierte seine Entscheidung vornehmlich auf dem Erkennen von Schienen. Obwohl der Algorithmus eine hohe Genauigkeit beim Erkennen von Bildern mit Zügen erreichte, traf er seine Entscheidung anhand falscher Merkmale.

Das neuronale Netz entschied zwar, dass in diesem Bild ein Zug abgebildet ist. Allerdings ergibt der Einblick in den Entscheidungsprozess (rechte Abbildung), dass das Modell lediglich gelernt hat, Schienen zu identifizieren.

In der Praxis sollte ein Modell wie das obige nicht eingesetzt werden, da es nicht gelernt hat, welche Merkmale einen Zug ausmachen. Für Bilder, welche lediglich Schienen und keine Züge abbilden, würde das Modell fälschlicherweise entscheiden, dass ein Zug zu sehen ist. Für sicherheitskritische Anwendungsfälle, wie das autonome Fahren, ist dieses Verhalten nicht akzeptabel. Man stelle sich den Fall vor, in dem ein solches neuronales Netz für die Erkennung von Fußgänger*innen eingesetzt wird. Würde das Modell einen Fußgänger oder eine Fußgängerin fälschlicherweise anhand des Pflasters auf einem Bürgersteig identifizieren, so ist es möglich, dass derselbe Fußgänger auf einem anders gefärbten Fahrradweg nicht erkannt wird. Solche Fehler zu erkennen, bevor das neuronale Netz in der Praxis angewendet wird, ist besonders für sicherheitskritische Anwendungsfälle essentiell.

Neuronale Netze sind aus der aktuellen Forschungslandschaft des Maschinellen Lernens aufgrund ihrer hohen Genauigkeit nicht mehr wegzudenken. Allerdings sind sie, zum jetzigen Zeitpunkt, noch nicht geeignet, um in sicherheitskritischen Bereichen angewendet zu werden. Eine notwendige Zertifizierung neuronaler Netze für den Einsatz in sicherheitskritischen Bereichen fällt schwer, da diese schnell zu komplex werden. Erste Ansätze, welche die Entscheidungsprozesse transparenter gestalten, existieren allerdings bereits. Ein Verfahren, um den Entscheidungsprozess anhand von bildlichen Darstellungen transparenter zu gestalten, liefert die obige Visualisierung mittels einer Gewichtung. Durch dieses Verfahrens ist es bereits möglich, zu überprüfen, ob das neuronale Netz konkrete Konzepte verinnerlicht hat (wie die visuellen Merkmale eines Zuges), oder ob es fälschlicherweise andere Merkmale zur Entscheidung benutzt, welche häufig zusammen auftreten (wie Schienen im obigen Beispiel). Die Weiterentwicklung dieser Ansätze zum Entschlüsseln von Entscheidungen komplexer Lernverfahren bildet deshalb ein zentrales Forschungsziel, um die Vorzüge der neuronalen Netze für die Allgemeinheit nutzbar zu machen.

Zum Nachlesen gibt es viele weitere Informationen zum Thema Erklärbarkeit der Künstlichen Intelligenz, so auch im Buch: „Interpretable Machine Learning – A Guide for Making Black Box Models Explainable„.