Große Sprachmodelle können die Bedeutung von Inhalten wie Texten und Bildern erfassen und selbst neue Texte und Bilder erzeugen. Wegen der riesigen Bandbreite an Anwendungen werden diese Modelle auch als Foundation-Modelle bezeichnet. Durch den enormen Stellenwert bewegter Bilder in unserem Alltag liegt es nahe, diese Ansätze auch auf Videos auszuweiten. Aufgrund ihrer hohen Relevanz ergeben sich außerdem vielfältige Anwendungsfälle für derartige Techniken. Im folgenden Beitrag zeigen wir, wie sich mithilfe großer Sprachmodelle aus Texten Videos erzeugen lassen.

Foundation-Modelle können Texte und Bilder erfassen

Seit vor zwei Jahren GPT-3 vorgestellt wurde, hat die generative KI enorme Fortschritte gemacht. Große Sprachmodelle sind mittlerweile in der Lage, einen Starttext in flüssiger und inhaltlich nahezu fehlerfreier Weise zu vervollständigen.

Ausgangspunkt ist die in dem tiefen neuronalen Netzwerk BERT vorgestellte Technik der kontextsensitiven Einbettungen. Dabei wird die Bedeutung eines Tokens durch einen langen numerischen Vektor beschrieben und es werden, je nach Kontext, unterschiedliche kontextsensitive Einbettungen generiert (mehr dazu im Beitrag: Die Bedeutung von Worten durch Vektoren erfassen).

Es hat sich gezeigt, dass man Bilder auch in eine begrenzte Menge von Token zerlegen kann, die aus kleinen Pixelbereichen von zum Beispiel 14×14 Pixeln bestehen. Der Vision Transformer (Dosovitsky et al. 2020) ordnet diesen Pixelbereichen eine Einbettung zu und nutzt dann den BERT-Algorithmus, um für diese Token kontextsensitive Einbettungen abzuleiten. Anschließend kann man das Verfahren verfeinern, beispielsweise mit einer Aufgabe der Bildklassifikation. Auf dem ImageNet-Testset konnte der Vision Transformer mit 88,5 % Genauigkeit alle bisherigen Modelle schlagen. Dies zeigt, dass bei umfangreichen Trainingsdaten Transformermodelle auch für Aufgaben der Bildverarbeitung vorteilhaft sind.

Auch Videos lassen sich durch Token repräsentieren

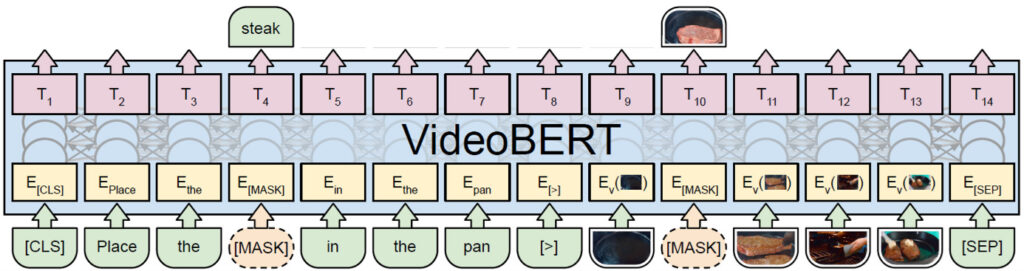

Videos bestehen nicht nur aus einem Bild, sondern aus vielen Bildern in zeitlicher Abfolge und erfordern daher die Berücksichtigung von sehr vielen Daten. VideoBERT (Sun et al. 2019) wendet das BERT-Modell auf eine gemeinsame Darstellung von Text und Videobildern durch Token an. Das Video wird in Clips von 30 Bildern (1,5 Sekunden) unterteilt, aus denen ein temporales Faltungsnetz Einbettungsvektoren der Länge 1.024 erzeugt. Die Clip-Einbettungen werden durch k-Means-Clustering in 20.736 Cluster gruppiert und durch „Videotoken“ repräsentiert. Die Sprache des Videos wird durch ein Spracherkennungsverfahren in Text überführt und in Sätze unterteilt. Gleichzeitig wird der Text durch einen Tokenisierungsalgorithmus, der auf ein Vokabular von 30.000 Token zurückgreift, in Token umgewandelt. Die Videotoken, die der Zeitperiode des Satzes entsprechen, werden in einer Video-Token-Sequenz gesammelt. Wie in Abb. 1 gezeigt, werden die Video-Token an die entsprechenden Texttoken angehängt und durch spezielle Token getrennt.

Abbildung 1: VideoBERT erweitert die Texttoken durch Videotoken und prognostiziert im Vortraining maskierte Token. Hierdurch wird die Beziehung zwischen Text und Bild/Videoinformation gelernt.

Das Modell wurde mit einem Videodatensatz von 312.000 Kochvideos mit einer Gesamtdauer von 966 Tagen vortrainiert. Gibt man ein Video und einen Text mit sehr vielen [MASK] Token ein, so beschreibt VideoBERT das Video durch einen Text. Die Qualität dieser Videountertitelung ist besser als bei den vorherigen Ansätzen.

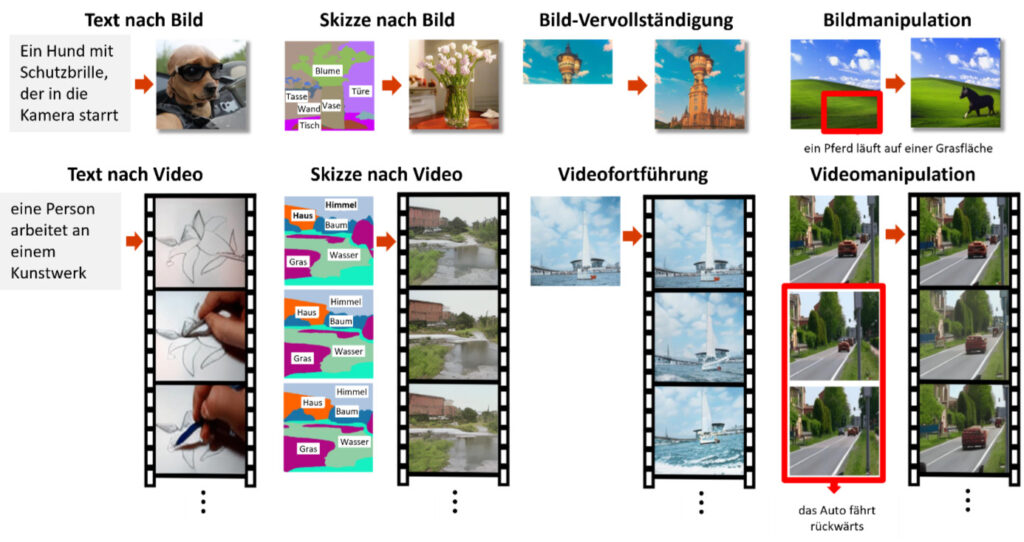

Mittlerweile gibt es eine Vielzahl von Systemen zur Verarbeitung von Videos zusammen mit anderen Medien. NÜWA (Wu et al. 2022) verwendet eine gemeinsame Token-Darstellung für Texte, Bilder und Videos und lernt im Vortraining den Zusammenhang zwischen den Token der einzelnen Medien. Anschließend kann es nach entsprechendem „Feintuning“ acht unterschiedliche Aufgaben erfüllen (siehe Abb.2), unter anderem die Erzeugung eines Videos zu einem Text. Hier konnte es die Leistung der bisherigen Modelle übertreffen. Allerdings ist die Auflösung der Videos noch niedrig.

Abbildung 2: Das NÜWA-Modell kann acht unterschiedliche Aufgaben erfüllen.

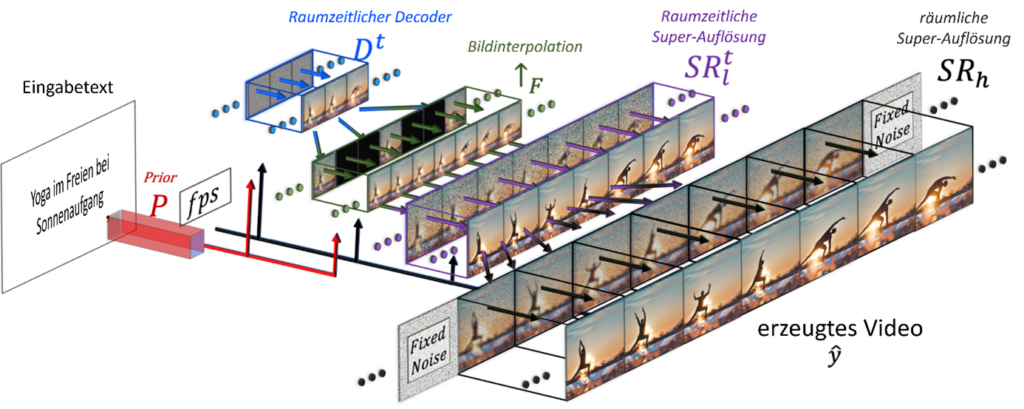

Make-a-Video erzeugt Videos hoher Auflösung zu einer textuellen Beschreibung

Im letzten Jahr wurden Modelle zur Videoerzeugung entwickelt, die Videos mit hoher Auflösung aus Text generieren können. Make-a-Video (Singer et al. 2022) baut auf Text-Bild-Modellen mit neuartigen räumlich-zeitlichen Modulen auf. Es beschleunigt das Training des Text-Video-Modells, ohne dass visuelle und multimodale Repräsentationen von Grund auf gelernt werden müssen, und benötigt keine gepaarten Text-Videodaten. Die generierten Videos übernehmen die Eigenschaften des Text-Bild-Modells und sein Wissen über vielfältige Bildtypen. Doch wie genau funktioniert das? Ein Text-nach-Bild-Basismodell erzeugt Bilder zu Texten und wird auf Text-Bild-Paaren trainiert. Ein Prior-Netzwerk [latex]P[/latex] generiert dabei Bildeinbettungen zu den vorgegebenen Texttoken (vgl. Abb. 3). Aus diesen produziert ein raum-zeitliches Decoder-Netzwerk [latex]D^t[/latex] eine Serie von 16 Videobildern mit einer Auflösung von 64×64 Pixeln. Diese werden dann durch die Bildinterpolation [latex]F[/latex] in eine höhere zeitliche Auflösung überführt. Anschließend werden mithilfe eines raum-zeitlichen Super-Auflösungsnetzwerks [latex]SR_{l}[/latex] die Bilder in eine höhere 256×256 Pixel-Auflösung erweitert. Zum Schluss generiert daraus das Super-Auflösungsnetzwerke [latex]SR_{h}[/latex] das Ausgabevideo in finaler 768×768 Pixel-Auflösungen (vgl. Abb. 3).

Abbildung 3: Architektur des Make-A-Video Modells. Diese Webseite zeigt eine Reihe von erzeugten Beispielvideos mit einer maximalen Länge von 5 Sekunden.

Imagen-Video nutzt Diffusionsmodelle zur Erhöhung der Auflösung

Imagen-Video (Ho et al. 2022) ist ein ähnliches Modell zur Erzeugung hochauflösender Videos. Es nutzt einen T5-Encoder-Decoder, um aus einem Eingabetext eine Reihe von 16 Videobildern der Auflösung 40×24 Pixel zu generieren. Anschließend wird eine Serie von 6 Modellen verwendet, um die zeitliche und räumliche Auflösung sukzessive auf 128 Videobilder mit 1280×768 Pixel zu erhöhen.

Zur Erhöhung der Auflösung werden Diffusionsmodelle verwendet. Ein Diffusionsmodell beschreibt den Prozess der systematischen und langsamen Zerstörung von Pixelbildern durch die schrittweise Abänderung der Pixelwerte durch unabhängige kleine Störungen. Dies gibt eine Serie von Bildern [latex]x^{[0]}, … , x^{[T]}[/latex] , die näherungsweise der Normalverteilung folgt. Man kann diesen Prozess nun umkehren, d.h. schrittweise aus einem verrauschten Bild [latex]x^{[t]}[/latex] ein weniger verrauschtes Bild [latex]x^{[t-1]}[/latex] erzeugen. Das zugehörige Diffusionsmodell kann durch die Rekonstruktion von schrittweise gestörten Bildern gelernt werden. Es zeigt sich, dass mithilfe dieser Technik kleine unscharfe Bilder mit einer hohen hohen Zuverlässigkeit in größere, detailgetreue Bilder expandiert werden können. Dieser Ansatz wird in vielen aktuellen Text-Bild Modellen, wie DALL-E, Stable Diffusion und Imagen mit Erfolg verwendet.

Ausblick

Die Einbeziehung von Bildern und insbesondere Videos ermöglicht es, die Bedeutung von Worten und Sätzen mit Abläufen in der realen Welt zu verknüpfen. Foundation-Modelle können daher als autonome Agenten betrachtet werden, die die Verbindung zwischen den Token eines Textes und den Sinneswahrnehmungen der Außenwelt herstellen können. In diesem Sinne können sie das Symbol Grounding Problem lösen, welches die Künstliche Intelligenz schon seit vielen Jahrzehnten beschäftigt (Bommasani et al. 2021, p.42). Damit können derartige Modelle weitere essenzielle Dimensionen der Bedeutung von Konzepten erwerben.

Derzeit sind fortgeschrittene Foundation-Modelle für Video in Europa nicht verfügbar, da die europäische Forschungslandschaft nicht über die Strukturen und die Rechenkapazität verfügt, um solche groß angelegten Modelle mit vielen Milliarden Parametern zu trainieren. Die LEAM Initiative (Large European Language Models) hat sich daher das Ziel gesetzt, eine solche Infrastruktur für Foundation-Modelle in Deutschland zu initiieren. Sie soll das Training und die Erforschung großer Sprachmodelle für den Europäischen Sprachraum ermöglichen. Als eines der wichtigsten Forschungsziele wurde hierbei die Erzeugung von hochqualitativen Videos zu vorgegebenen Texten gewählt.

Referenzen

On the opportunities and risks of foundation models.

Bommasani, R., Hudson, D. A., Adeli, E., Altman, R., Arora, S., von Arx, S., … & Liang, P. (2021). arXiv preprint

An image is worth 16×16 words: Transformers for image recognition at scale.

Dosovitskiy, A., Beyer, L., Kolesnikov, A., Weissenborn, D., Zhai, X., Unterthiner, T., … & Houlsby, N. (2020). arXiv preprint

Imagen video: High definition video generation with diffusion models.

Ho, J., Chan, W., Saharia, C., Whang, J., Gao, R., Gritsenko, A., … & Salimans, T. (2022). arXiv preprint

Make-a-video: Text-to-video generation without text-video data.

Singer, U., Polyak, A., Hayes, T., Yin, X., An, J., Zhang, S., … & Taigman, Y. (2022). arXiv preprint

Videobert: A joint model for video and language representation learning.

Sun, C., Myers, A., Vondrick, C., Murphy, K., & Schmid, C. (2019). In Proceedings of the IEEE/CVF International Conference on Computer Vision (pp. 7464-7473). Link

Nüwa: Visual synthesis pre-training for neural visual world creation.

Wu, C., Liang, J., Ji, L., Yang, F., Fang, Y., Jiang, D., & Duan, N. (2022). In European Conference on Computer Vision (pp. 720-736). Springer, Cham. Link