Narrative bzw. Erzählungen sind ein kraftvolles kognitives Werkzeug zur Strukturierung von Informationen und Förderung des Verständnisses – ein zentraler Bestandteil menschlichen Lernens und Denkens. Dieser Blog stellt Story of Thought (SoT) vor, ein neuartiges Framework, das diese Prinzipien anwendet, um die Denkfähigkeiten von Large Language Models (LLMs) zu verbessern.

Sie sind effektive Hilfsmittel, um Informationen zu organisieren und komplexe Konzepte in verschiedenen Bereichen wie wissenschaftlicher Kommunikation und Bildung verständlicher zu machen. Anders ausgedrückt: Sie helfen, Informationen einzuordnen, Kontexte zu schaffen und Verbindungen herzustellen, die durch isolierte Fakten oder Fragen oft schwerer zu erfassen sind.

© V. Sadiri Javadi

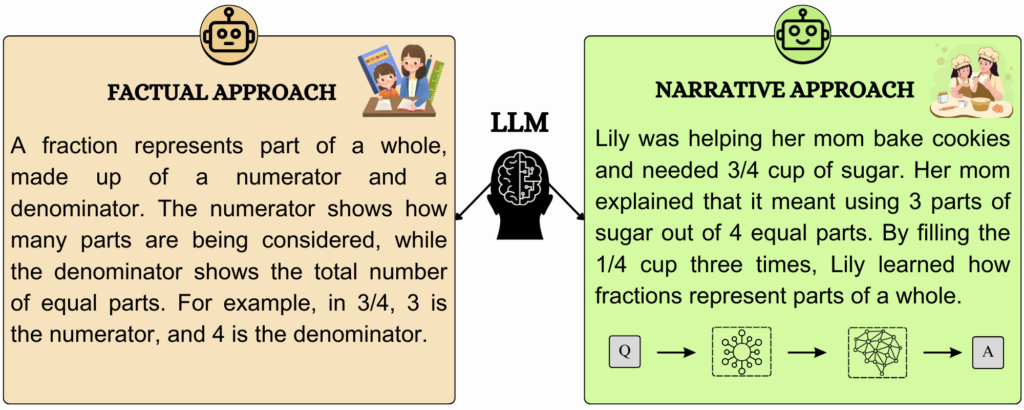

Ein Beispiel: Ein „Conversational Agent“ soll das Konzept der Bruchrechnung erklären. Im faktenbasierten Ansatz werden die Grundlagen direkt und klar vermittelt. Im narrativen Ansatz hingegen wird das Konzept in eine schrittweise entwickelte Geschichte eingebettet, die das Lernen durch einen Kontext und emotionale Bindung erleichtert.

Menschen verstehen die Welt durch Geschichten – wir teilen Wissen, lösen Probleme und geben Erfahrungen weiter, indem wir Narrative nutzen. Das brachte uns auf eine spannende Idee:

Könnten wir die Kraft des Geschichtenerzählens nutzen, um Large Language Models (LLMs) zu helfen, effektiver zu denken?

In unserem aktuellen Forschungsprojekt gehen wir genau dieser Frage auf den Grund. Unser Ziel ist es, herauszufinden, ob die Einbeziehung narrativer Elemente die Problemlösefähigkeiten von LLMs wie GPT-4 oder LLaMA bei wissensintensiven Reasoning-Aufgaben verbessern können.

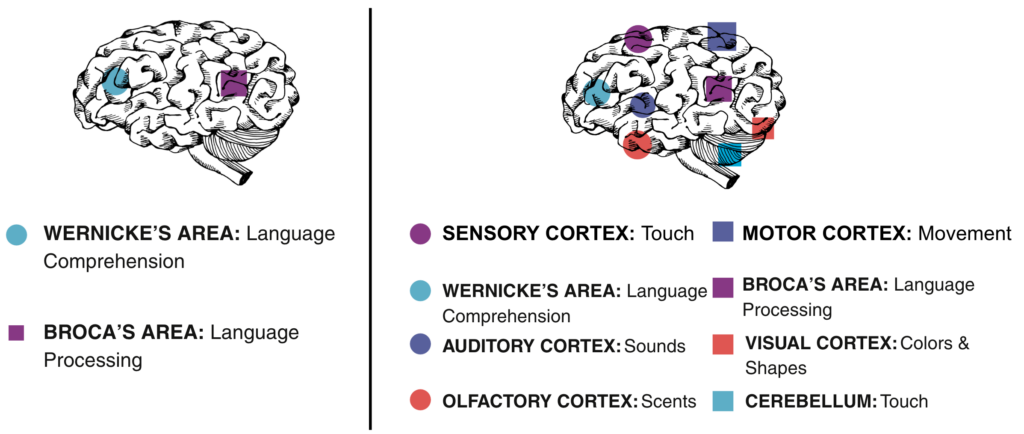

Warum Narrative? Inspiration aus der Kognitionswissenschaft

Die Idee, Geschichten einzusetzen, stammt aus der Kognitionswissenschaft. Ein „Narrativ“ beschreibt eine Abfolge von Ereignissen, die zu einer Geschichte verwoben werden. Das menschliche Gehirn reagiert auf Geschichten auf einzigartige Weise: Verschiedene Bereiche, vom Broca-Areal bis zu den sensorischen Kortizes, arbeiten zusammen, um Sprache zu verarbeiten und lebhafte mentale Bilder zu erzeugen – ein Effekt, der als „narrative transportation“ bekannt ist.

Geschichten sind nicht nur fesselnd, sondern auch äußerst effektiv, um Informationen zu strukturieren und abrufbar zu machen. Sie helfen uns, abstrakte Konzepte mit vertrauten Kontexten zu verknüpfen, und fördern so ein tieferes Verständnis und Erinnern.

Überträgt man diese Vorteile auf LLMs, lässt sich die Hypothese aufstellen, dass Narrative:

- Die Fähigkeit verbessern, relevante Informationen zu identifizieren,

- eine logische Struktur für komplexes Denken bieten,

- kausale Beziehungen und Abhängigkeiten innerhalb der Aufgabe verdeutlichen.

Diese Überlegungen führten zur Entwicklung unseres neuen Frameworks: Story of Thought (SoT).

Story of Thought (SoT): Wie Narrative LLMs helfen

Für LLMs ähnelt das Lösen von Problemen oft einem Puzzle: Einzelne, unzusammenhängende Fakten müssen zu einem sinnvollen Bild zusammengesetzt werden. Bestehende Methoden wie Chain of Thought (CoT) helfen Modellen dabei, Probleme in logische Schritte zu zerlegen – ein wertvoller Ansatz, aber mit starren Strukturen. Doch wir fragten uns:

Was wäre, wenn anstelle starrer Denkschritte eine Geschichte entstehen könnte?

Diese Geschichte würde nicht nur Struktur bieten, Sinn stiften undu Komplexität auflösen

So entstand unser Ansatz: Story of Thought (SoT). Dieses narrativgesteuerte Framework nutzt die Vorteile des Geschichtenerzählens – Kontextualisierung, Kohärenz und relationales Verständnis – und eröffnet LLMs eine neue, effektive Methode zur Lösung komplexer Aufgaben.

Wie funktioniert Story of Thought (SoT)?

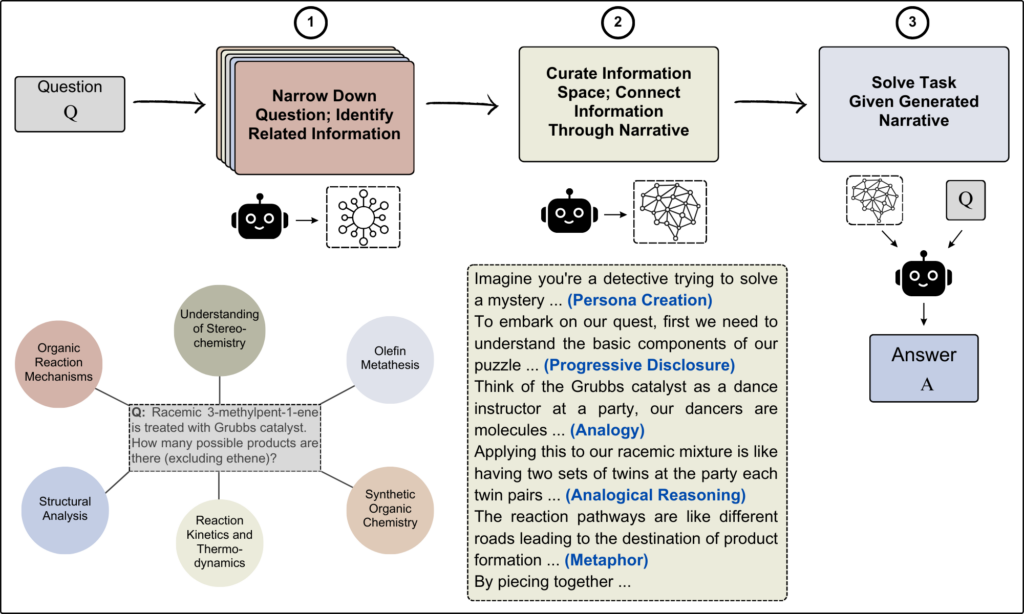

Um die Kraft narrativer Elemente in der Problemlösung voll auszuschöpfen, haben wir einen dreistufigen Ansatz entwickelt:

- Klärung der Fragestellung: Im Ersten Schritt wird das Problem in seine Kernelemente zerlegt. Mithilfe von LLMs identifizieren wir die zentralen Konzepte und Unterthemen, die für das Verständnis des Problems notwendig sind. Diese Diagnosephase legt das Fundament für die spätere Narrative.

- Erzeugung eines Narrativs: Aufbauend auf den geklärten Komponenten wird eine strukturierte Erzählung erstellt. Hierbei kommen Techniken wie Metaphern, analoges Denken (en. Analogical Reasoning) und progressive Offenlegung (en. Progressive Disclosure) zum Einsatz. Ziel ist es, das Problem so zu kontextualisieren, dass das Modell besser darauf zugreifen und es leichter lösen kann.

- Problemlösung: Das generierte Narrativ bildet schließlich die Grundlage für das LLM, um das Problem zu lösen. Die durch die Geschichte bereitgestellten Kontextinformationen und die logische Struktur erleichtern dem Modell das “Denken” und erhöhen die Problemlösefähigkeit erheblich.

Praxistest: SoT im Einsatz

Um den Erfolg unseres Ansatzes zu bewerten, haben wir SoT an zwei anspruchsvollen Datensätzen getestet, die logisches Denken und fachspezifisches Wissen:

- GPQA: Ein Datensatz mit Aufgaben aus den Bereichen Physik, Chemie und Biologie auf Hochschulniveau.

- JEEBench: Ein Datensatz der Aufgaben aus der JEE-Advanced-Prüfung (Joint Entrance Examination), in Physik, Chemie und Mathematik auf Abiturniveau umfasst.

Wichtige Erkenntnisse

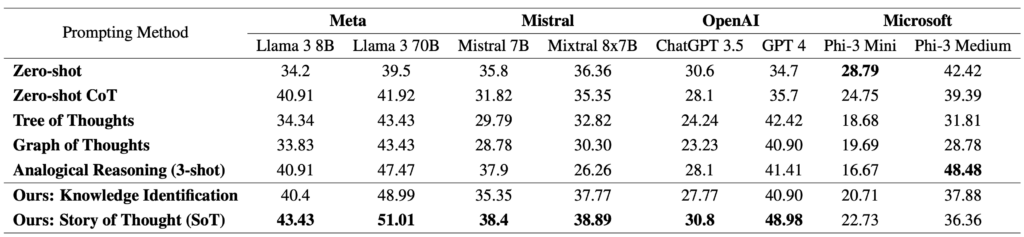

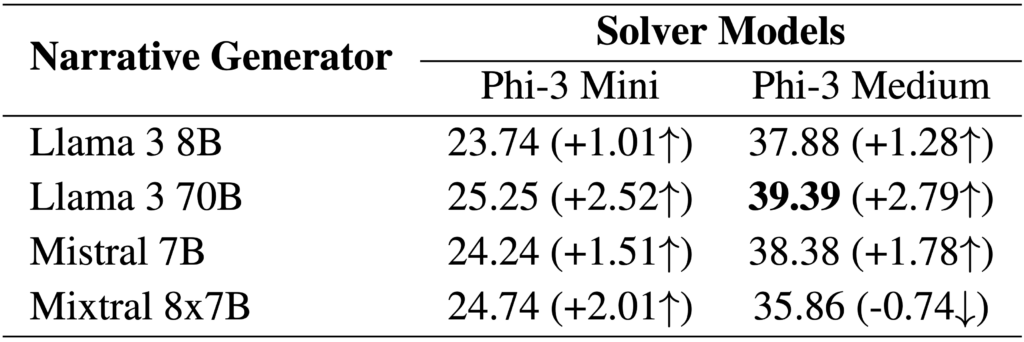

Performancesteigerung: Über verschiedene LLMs hinweg –einschließlich Versionen von LLaMA, Mistral, GPT und Microsofts Phi-Modellen – zeigte SoT konsistent eine bessere Leistung als traditionelle Prompting-Methoden wie Zero-Shot– und Chain-of-Thought-Techniken (CoT). Beispielsweise erreichte das Open-Source-Modell Llama 3 (70B Parameter) die höchste Genauigkeit bei GPQA unter Verwendung der SoT-Methode und erzielte eine Punktzahl von 51,01 %. Bei GPT-4 führte der Einsatz von SoT zu einer Verbesserung der Genauigkeit bei GPQA um 14,28 Prozentpunkte im Vergleich zu Zero-Shot-Prompting.

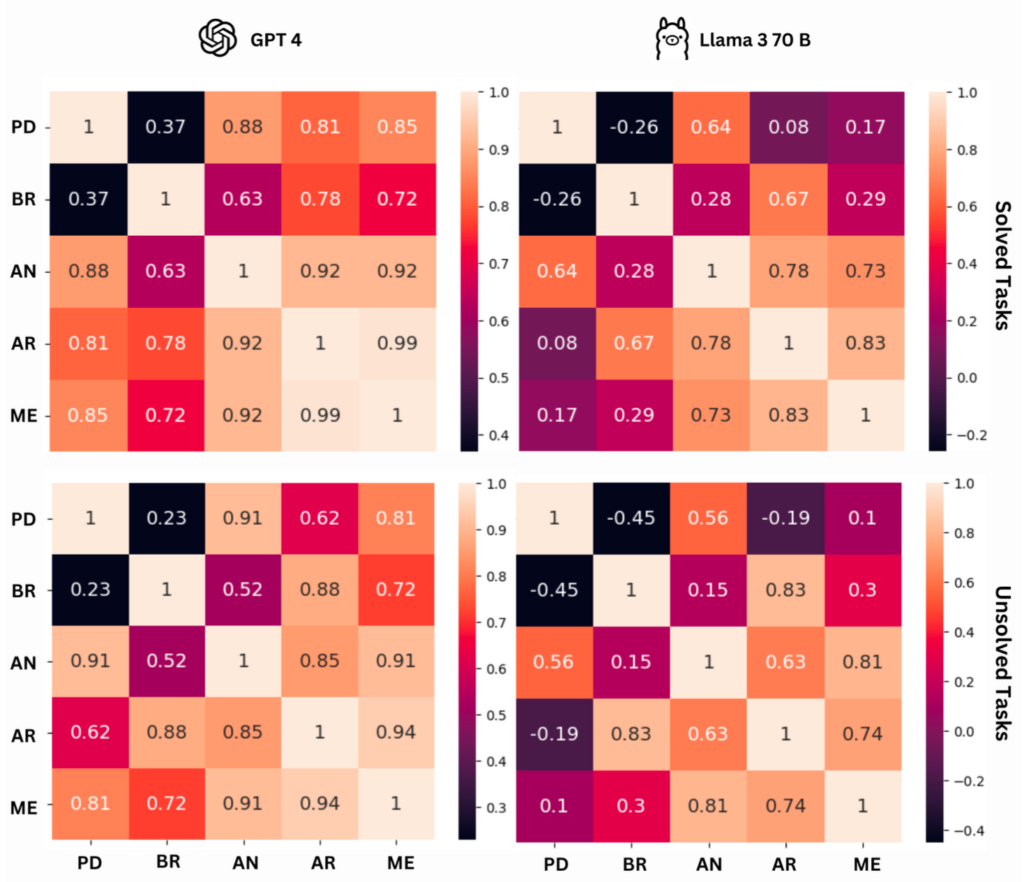

Robustheit: Auch kleinere Modelle profitierten erheblich von dem narrativen Ansatz, was die Skalierbarkeit der Methode unterstreicht. Besonders interessant: on leistungsstärkeren Modellen generierte Erzählungen verbesserten die Leistung kleinerer Modelle – ein Hinweis darauf, dass Geschichten ein effektives Mittel zur Wissensübertragung zwischen LLMs sein können.

Fachspezifische Verbesserungen: Besonders in Fächern wie Biologie und Chemie, die ein hohes Maß an kontextuellem Verständnis erfordern, zeigte SoT herausragende Ergebnisse. Narrative vereinfachen hier komplexe Zusammenhänge und verbessern die Problemlösung signifikant.

Ausblick: Die Zukunft von Story of Thought (SoT)

Unsere bisherigen Ergebnisse sind vielversprechend, doch sie werfen ebenso viele Fragen auf, wie sie beantworten. Besonders spannend ist für uns die grundlegende Frage:

Warum sind Narrative so effektiv?

Bieten sie lediglich eine strukturiertere Möglichkeit, Informationen für LLMs zu organisieren? Oder verbirgt sich in der Struktur von Erzählungen ein fundamentaler Mechanismus, der das Argumentationsvermögen (Reasoning) von Modellen verbessert?

Grenzen und Herausforderungen

Wir erkennen, dass SoT nicht für alle Arten von Aufgaben gleichermaßen geeignet ist. Probleme, die stark auf spezifischem Faktenwissen basieren oder Multiple-Choice-Optionen enthalten, profitieren möglicherweise weniger von einem narrativen Ansatz. Hier könnte eine Kombination aus traditionellen Prompting-Methoden und SoT vielversprechend sein.

Neue Horizonte für LLMs

Der Einsatz von Narrativen in der Problemlösung eröffnet nicht nur neue Möglichkeiten, sondern könnte auch den Denk- und Problemlösungsansatz von KI-Agenten auf ein neues Niveau heben. Indem wir LLMs helfen, in Geschichten zu „denken“, schaffen wir die Grundlage für eine tiefere Integration menschlicher Denkmechanismen in KI-Systeme – eine Entwicklung, die das Potenzial hat, die Art und Weise, wie wir KI nutzen, grundlegend zu verändern.