Neue Publikation von Lamarr PI Prof. Jürgen Bajorath analysiert den wissenschaftlichen Nutzen prädiktiver KI-Modelle

Die Anwendung von Künstlicher Intelligenz in den Naturwissenschaften wächst stetig – insbesondere in Disziplinen wie Chemie, Biologie oder Medizin. Doch wie aussagekräftig und vertrauenswürdig sind KI-generierte Vorhersagen in einem wissenschaftlichen Kontext wirklich?

Dieser Frage widmet sich eine neue Publikation von Prof. Dr. Jürgen Bajorath, Principal Investigator am Lamarr-Institut für Maschinelles Lernen und Künstliche Intelligenz. Zudem verantwortet er das Life Science Informatics Programm am Bonn-Aachen International Center for Information Technology (b-it) der Universität Bonn. Der Beitrag mit dem Titel From Scientific Theory to Duality of Predictive Artificial Intelligence Models ist kürzlich in Cell Reports Physical Science erschienen.

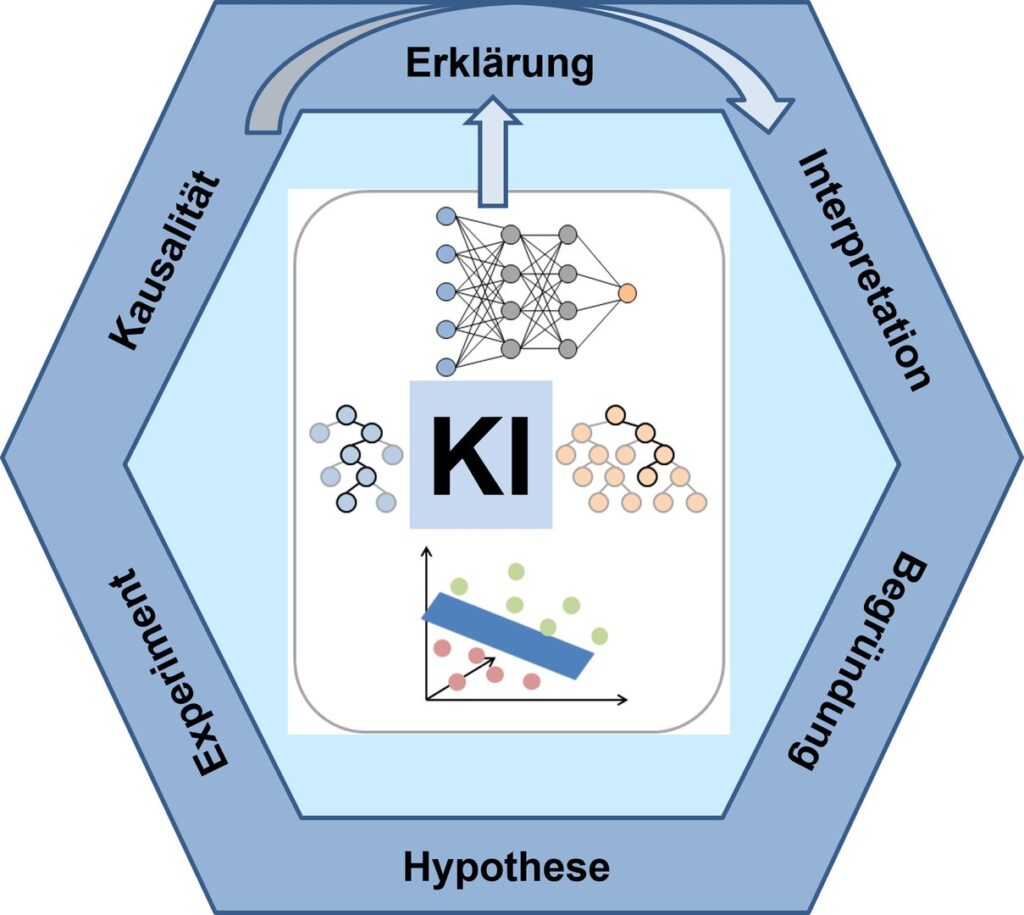

Die Studie formuliert ein theoretisches Rahmenwerk, das zeigt: Die Erklärung von KI-Vorhersagen ist nicht mit deren wissenschaftlicher Interpretation gleichzusetzen – und schon gar nicht mit dem Nachweis kausaler Zusammenhänge.

Vertrauenswürdige KI in den Naturwissenschaften: Forschung am Lamarr-Institut

Am Lamarr-Institut leitet Prof. Bajorath den Forschungsbereich Life Sciences. In seiner Arbeit verbindet er Methoden des maschinellen Lernens mit Anwendungen in der Chemieinformatik, medizinischen Chemie und Wirkstoffforschung. Die aktuelle Publikation adressiert eines der zentralen Anliegen des Lamarr-Instituts: die Entwicklung erklärbarer, vertrauenswürdiger KI-Systeme mit realer Anwendungsperspektive.

Bajorath beschreibt darin die „Dualität prädiktiver Modelle“: Je nachdem, ob ein Modell auf einer wissenschaftlich fundierten Hypothese basiert oder rein datengetrieben ist, unterscheidet sich seine Eignung für experimentelle Folgeforschung erheblich. Nur wenn ein Modell auf nachvollziehbaren wissenschaftlichen Prinzipien beruht, kann es laut Bajorath als Ausgangspunkt für Hypothesenbildung, Kausalitätsanalyse und experimentelles Design dienen.

Klarer Unterschied: Erklärung ≠ Interpretation ≠ Kausalität

Die Studie grenzt zentrale Begriffe der KI-Forschung systematisch voneinander ab:

- Modellerklärung (explanation): Welche Merkmale nutzt das Modell für seine Vorhersage?

- Interpretation: Wie bewertet der Mensch diese Merkmale im wissenschaftlichen Kontext?

- Kausalität: Lässt sich ein ursächlicher Zusammenhang zwischen einer Vorhersage und eines natürlichen Prozesses experimentell belegen?

Fehlt die wissenschaftliche Rationalität im Modellansatz, drohen Fehlinterpretationen – ein Risiko, das Bajorath unter anderem am Beispiel sogenannter „Clever Hans Predictors“ illustriert: Modelle, die scheinbar korrekte Ergebnisse liefern, deren Entscheidungsgrundlage aber irreführend ist. Gerade im Bereich der KI in den Naturwissenschaften kommt es häufig zu Missverständnissen – etwa, wenn Modelle scheinbar zutreffende Ergebnisse liefern, aber auf irrelevanten oder nicht nachvollziehbaren Kriterien basieren.

Relevanz für die KI-Forschung am Lamarr-Institut

Die Studie ist ein Beitrag zur Grundlagenforschung im Bereich vertrauenswürdiger und erklärbarer KI – einem der Leitprinzipien des Lamarr-Instituts. Sie verdeutlicht, unter welchen Bedingungen Künstliche Intelligenz in den Naturwissenschaften mehr sein kann als ein reines Vorhersagewerkzeug: nämlich ein methodisch fundiertes Instrument zur Hypothesenbildung und Erkenntnisgewinnung.

Zugleich liefert sie wichtige Impulse für andere Lamarr-Forschungsbereiche, etwa Trustworthy AI, Hybrid ML und Life Sciences, die erklärbare und wissenschaftlich fundierte KI-Modelle entwickeln – im Sinne der Triangulären KI, die Daten, Wissen und Kontext systematisch miteinander verknüpft.

Publikation: Jürgen Bajorath: From Scientific Theory to Duality of Predictive Artificial Intelligence Models. Cell Reports Physical Science (2025). DOI: 10.1016/j.xcrp.2025.102516