Automatisches Erkennen von Widersprüchen in Texten stellt eine sehr anspruchsvolle Aufgabe dar – vor allem in anderen Sprachen als Englisch. Damit ein System für maschinelles Lernen (ML) widersprüchliche Aussagen erkennen kann, erfordert es eine große Menge an menschenähnlichem Textverständnis. Dennoch sollte es dem System, wenn es diese Aufgabe erfolgreich gelöst hat, nicht allzu schwerfallen, auch andere Aspekte der Sprache zu verstehen (wie bspw. Kausalität und semantische Ähnlichkeit von Sätzen). Wir schauen uns das Problem, welches auch „Natural Language Inference“ genannt wird, anhand der deutschen Sprache an.

Ein ML-System, das Widersprüche erkennt

Es gibt bereits eine Vielzahl an Anwendungsmöglichkeiten für das Erkennen von Widersprüchen. Zum einen könnte man beispielsweise Fake News erkennen, indem man Online-Posts mit den zuverlässigen Nachrichtenquellen abgleicht. Zum anderen könnte im Finanzbereich und bei der Rechnungsprüfung ein solches Modell genutzt werden, um Unstimmigkeiten innerhalb eines Jahresberichts oder zwischen mehreren Finanzdokumenten zu ermitteln (siehe auch „Towards Automated Auditing with Machine Learning“). Ebenfalls könnte man es als automatische Evaluation für den Output anderer ML-Systeme nutzen, zum Beispiel um die Leistung eines Chatbots oder einer Sprachassistenten-Anwendung zu bewerten.

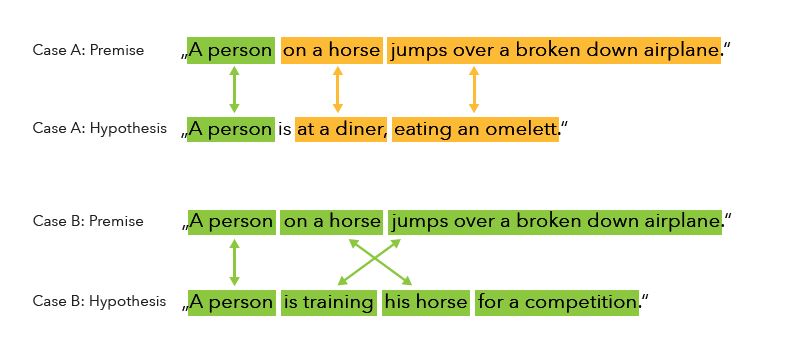

Ziel unserer Forschung ist es, ein ML-System zu entwickeln, welches voraussagen kann, ob zwei vorgegebene deutsche Sätze oder Absätze widersprüchlich sind oder nicht. Wir wollen herausfinden, welches Lernparadigma die beste Leistung für diese Aufgabe erreicht und ob die Modelle mit verschiedenen Arten von Daten umgehen können. Diese beiden Textschnipsel werden üblicherweise als „Prämisse“ und „Hypothese“ bezeichnet. Da wir nicht viele Trainingsdaten in deutscher Sprache vorliegen hatten, haben wir einen großen Teil englischer Datensätze (SNLI) maschinell übersetzt. In diesen Daten gehören Prämisse und Hypothese zu einem Bild. Dabei ist die Prämisse eine genaue Beschreibung des Bilds, die Hypothese hingegen wurde von einem Kommentator geschrieben. Es wurden etwa 1/3 der Beispiele als widersprüchlich erkannt, während bei 2/3 kein Widerspruch gefunden werden konnte.

Beispiel zweier Prämissen und Hypothesen

Vektordarstellungen für Prämissen und Hypothesen

Ein Schlüsselproblem zur Lösung dieser Aufgabe ist es, gute Vektordarstellungen für Prämisse und Hypothese zu finden, welche all die Informationen, die ein Modell zur Vorhersage eines Widerspruchs braucht, codiert. In jedem Fall wird die finale Repräsentation dem Klassifizierungsmodell übergeben, welches eine Voraussage zur Klasse ausgibt („Widerspruch“ oder „Kein Widerspruch“). Zu diesem Zweck haben wir zwei verschiedene Paradigmen verglichen:

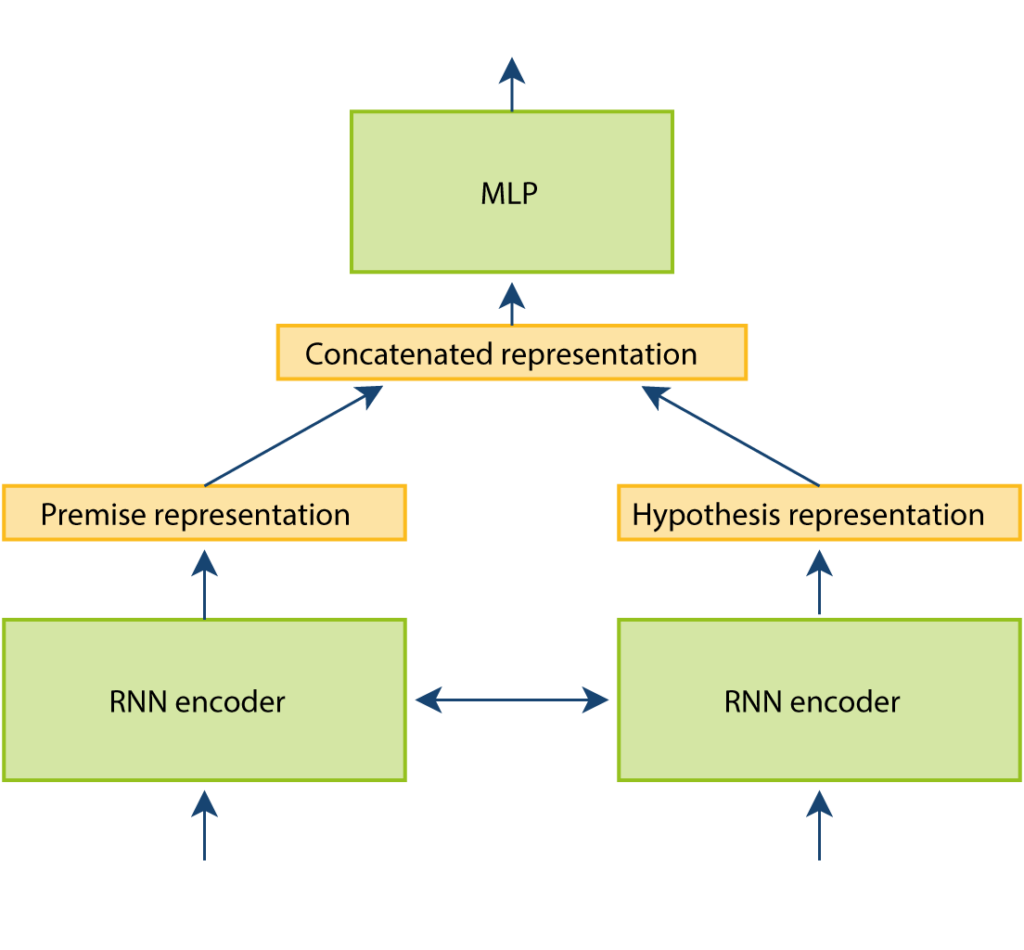

Modell 1: Rekurrente neurale Netze (RNNs) ohne Attention:

In diesem Beispiel wurde ein rekurrentes neuronales Netz darauf trainiert, Vektordarstellungen für Prämisse und Hypothese zu erstellen. Das RNN liest den Absatz als eine Liste von Token (Wörter) und aktualisiert seinen Hidden State (inneren Status) mit jedem Wort, das es sieht. Die finale Ausgabe ist der letzte Hidden State, nachdem die ganze Sequenz gelesen wurde. Der Output kann dann als Repräsentation für den Absatz interpretiert werden. In diesem ersten Ansatz werden die Repräsentationen für Prämisse und Hypothese separat berechnet und dann in einem langen Vektor verbunden. Diese Ausgabe wird von einem Multilayer Perzeptron (MLP), einem einfachen neuronalen Netz ohne rekurrente Verbindungen, verarbeitet.

Vereinfachte Darstellung des Workflows für Modell 1 (ohne Attention)

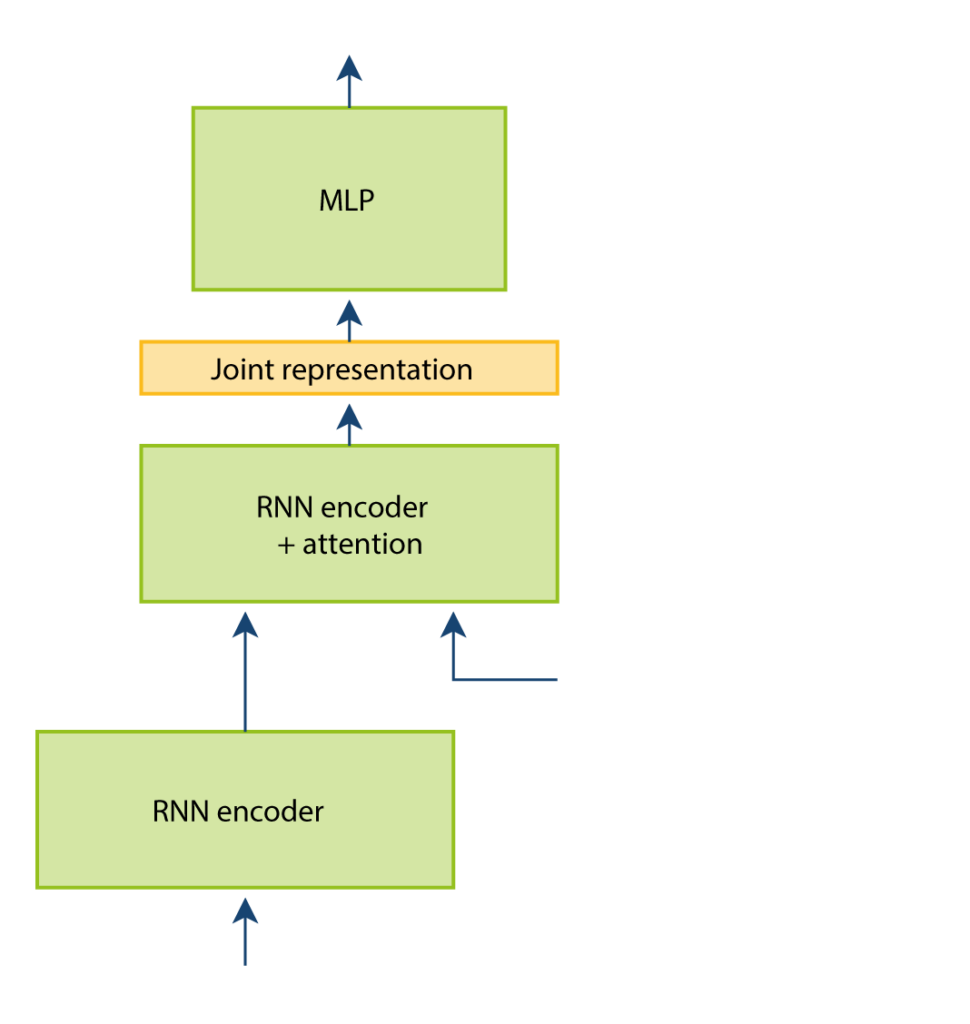

Modell 2: Rekurrente neurale Netze (RNNs) mit Attention:

Die zweite Möglichkeit besteht darin, eine Pipeline aus zwei RNNs zu bilden. Während das erste RNN die Prämisse liest und seinen letzten Hidden State an das zweite RNN weitergibt, macht dieses mit dem Lesen der Hypothese weiter. Es berechnet sogenannte „Attention“-Values zwischen jedem Wort in der Prämisse und jedem Wort in der Hypothese. Diese Werte sollen anzeigen, welche Wörter sich auf dieselben Einheiten in den beiden Sätzen beziehen, und es den folgenden Berechnungsschritten ermöglichen, den Schwerpunkt auf diese zu legen. Der Output des zweiten RNNs ist eine gemeinsame Repräsentation für Prämisse und Hypothese.

Vereinfachte Darstellung des Workflows für Modell 2 (mit Attention)

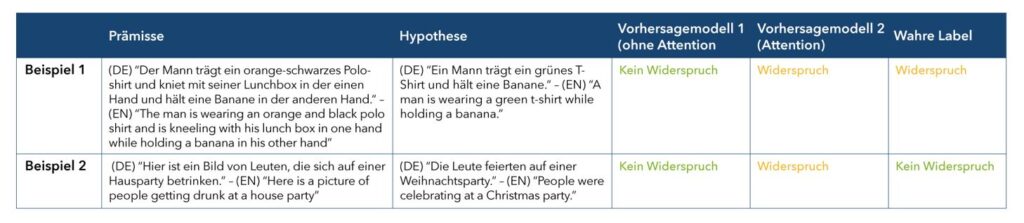

RNN-basierte Modelle sind anderen Herangehensweisen überlegen

Eines unserer Hauptergebnisse ist, dass die RNN-basierten Modelle alle anderen Methoden der Datencodierung übertreffen. Ebenfalls zeigen die Ergebnisse, dass die maschinell übersetzten Datensätzen ähnlich zu den Originaldaten sind, was nahelegt, dass die Datenqualität nicht unter der Übersetzung gelitten hat. Es gibt noch Raum für Verbesserungen, wie ein Blick auf zwei Beispiele für Vorhersagen der beiden Modelle zeigt: Beide Modelle sind konkurrenzfähig, so gibt es keinen klaren „Gewinner“ dieses Wettkampfs. Das Aufmerksamkeit-basierte Modell kann Widersprüche erkennen, welche an bestimmte Wörter geknüpft sind (Beispiel 1), aber es macht auch falsche Vorhersagen, zum Beispiel wenn die Zuordnung von Wörtern zwischen den Sätzen nicht hilfreich oder irreführend ist (Beispiel 2). Wenn ein tieferes Weltverständnis nötig ist, können beide Paradigmen mit diesen Fällen nicht umgehen. In einem empirischen Anwendungsfall muss man also vor der Wahl eines Modells darüber nachdenken, welche Art von Widerspruch am typischsten für den zu analysierenden Text ist.

Fazit

Wir können zusammenfassen, dass wir ein gut funktionierendes erstes Benchmark-System für die Erkennung von Widersprüchen in der deutschen Sprache erstellt haben. Es ist nur noch zu klären, ob die Modelle auf einen breiteren Bereich verallgemeinert werden können. In unserer weiteren Arbeit planen wir, verschiedene Herangehensweisen und Datensätze, sowie einige Aspekte des Informed Machine Learning zu untersuchen.