In unserer Welt gibt es mehr als 7.000 Sprachen und eine noch größere Anzahl an Dialekten und Akzenten, was die außergewöhnliche kulturelle und sprachliche Vielfalt der menschlichen Gesellschaften widerspiegelt. Diese Vielfalt ist jedoch ungleich verteilt: Eine kleine Anzahl von Sprachen wird von der überwiegenden Mehrheit der Weltbevölkerung gesprochen, während die meisten Sprachen weit weniger Sprecher haben und viele vom Aussterben bedroht sind.

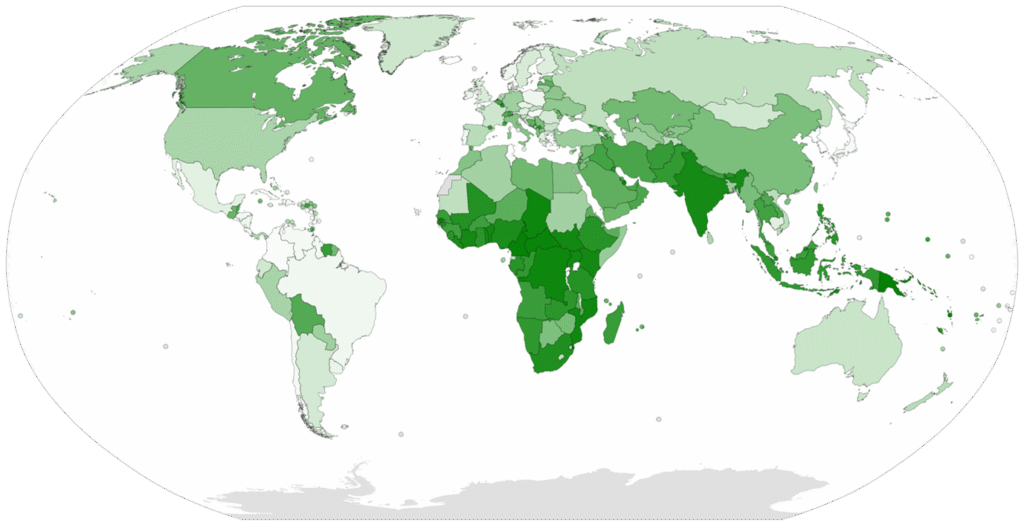

Die obige Karte zeigt, dass die meisten südostasiatischen Länder und viele afrikanische Länder eine große Sprachenvielfalt aufweisen. Der bekannte Greenberg-Diversitätsindex (LDI) der die Wahrscheinlichkeit angibt, dass zwei zufällig aus der Bevölkerung ausgewählte Personen unterschiedliche Muttersprachen haben, hat sich weltweit verändert, da immer mehr Sprachen aussterben. Doch ganz so einfach ist es nicht. Es ist auch anzumerken, dass die Klassifizierung von Sprachen subjektiv sein kann und verschiedene Wissenschaftler Sprachen und Dialekte unterschiedlich gruppieren können. Beispielsweise betrachten einige Hindi und Urdu als zwei separate Sprachen, während andere sie als Dialekte einer einzigen Sprache, Hindustani, betrachten.

Insgesamt gibt es weltweit wahrscheinlich Zehntausende von Sprachen, Dialekten und Akzenten, die die reiche sprachliche Vielfalt der menschlichen Gesellschaften widerspiegeln, auch wenn es schwierig ist, eine genaue Zahl anzugeben. Weitere Informationen und Daten zu Sprachen, wie z. B. Daten nach Ländern, Anzahl der lebenden vs. ausgestorbenen Sprachen und verschiedene Sprachfamilien weltweit, findest du hier: Ethnologue.

In den letzten drei Jahrzehnten hat sich Natural Language Processing (NLP) von regelbasierten Methoden zu datengesteuerten und Deep-Learning-Ansätzen verlagert – dennoch konzentrieren sich die meisten Forschungsarbeiten und kommerziellen Tools nur auf 20 der 7.000 Sprachen der Welt. Die übrigen werden als Low-Resource Languages (LRLs) klassifiziert und sind oft durch begrenzte Datensätze, knappe Rechenressourcen und komplexe Variationen von Dialekten beeinträchtigt.

Dieser Blogbeitrag befasst sich mit den Herausforderungen und Chancen beim Aufbau von ASR-Systemen für LRLs, untersucht die sprachliche Vielfalt, die Datenknappheit und die Rolle der Modelloptimierung bei der Überbrückung dieser Lücke. Am Beispiel von Marathi diskutieren wir, warum die Unterstützung von Sprachen mit geringen Ressourcen sowohl eine technologische Herausforderung als auch eine kulturelle Verantwortung darstellt.

Eine persönliche Perspektive: Mehrsprachig aufwachsen in einem Low-Resource-Sprachumfeld

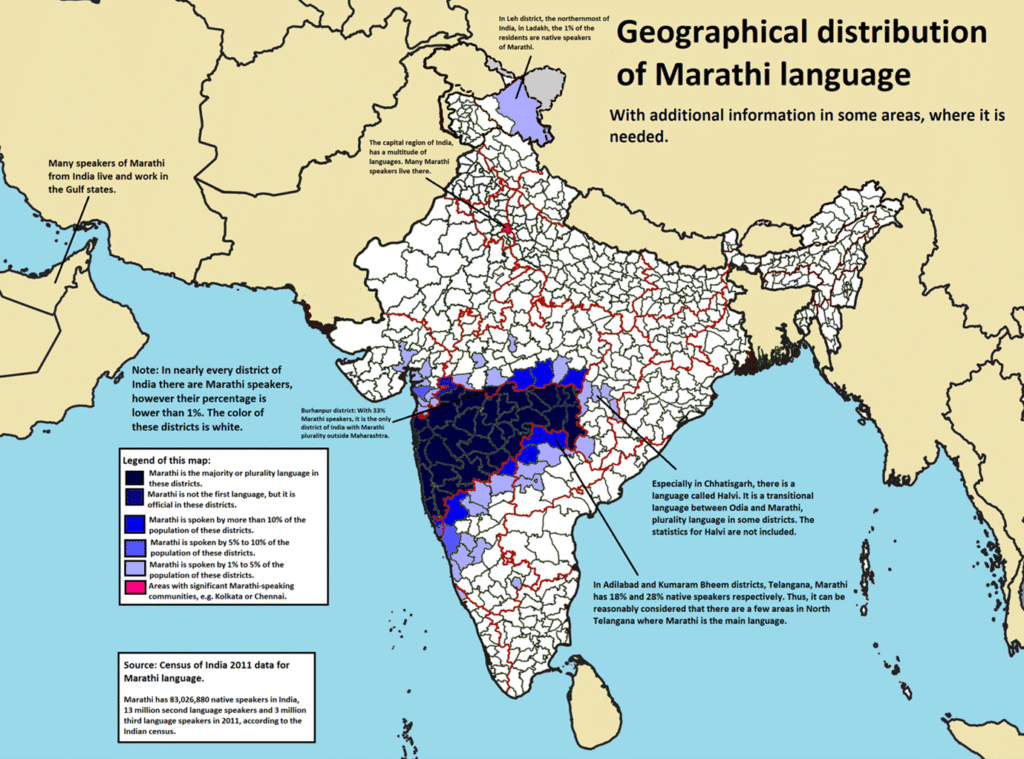

Ich bin in einer kleinen Stadt in Indien aufgewachsen, einem Land mit vielfältigen Kulturen und einer langen Geschichte verschiedener Zivilisationen. Mit heute über 22 offiziellen (institutionellen) Sprachen und etwa 424 lebenden indigenen Sprachen ist es sehr wahrscheinlich, dass eine Person, die an einem solchen Ort aufwächst, zwei- oder mehrsprachig ist. Meine Muttersprache ist Marathi, aber durch meine Ausbildung habe ich sowohl Englisch als auch Hindi gelernt. Englisch und/oder Hindi können in vielen Bundesstaaten und Regionen des Landes als gemeinsame Sprachen dienen. Ich habe es immer geschätzt, mich mit verschiedenen Sprachen und ihren umgangssprachlichen Nuancen zu beschäftigen, und bin oft fasziniert von fremden Schriften, denen ich auf meinen Reisen begegne.

Meine Neugierde weckte in mir ein tieferes Interesse daran, die Bedeutung von Low-Resource-Sprachen in der Technologie zu untersuchen.

Dieser Beitrag stützt sich sowohl auf mein technisches Fachwissen als auch auf meine persönlichen Erfahrungen und befasst sich mit der Entwicklung Automatische Spracherkennung (ASR) für weltweit unterrepräsentierte Sprachen wie Marathi. Er untersucht die Auswirkungen der Einstufung einer Sprache als „Low-resource“ und wie sich diese Einstufung auf ihre Darstellung in digitalen Technologien auswirkt. Marathi ist eine von mehreren indischen Sprachen, darunter Assamesisch, Bengali, Gujarati, Kannada, Urdu, Malayalam, Punjabi, Tamil, Oriya und Telugu. Nichtsdestotrotz haben die linguistische Forschung und die computergestützte Entwicklung an führenden indischen Universitäten in den letzten zehn Jahren in Verbindung mit einer erhöhten Finanzierung durch staatliche und private Einrichtungen, die durch die globale Expansion der künstlichen Intelligenz vorangetrieben wurde, zu einer erheblichen Bereicherung der Daten zur Verarbeitung natürlicher Sprache für viele dieser Sprachen beigetragen (siehe Artikel und Links: [1], [2], [3], [4], [5]).

Wenn wir jedoch zu einem breiteren technologischen Kontext übergehen, wird die Realität der Low-Resource-Sprachen deutlich, wenn man modernste Modelle oder Tools vergleicht, die für Englisch, Französisch, Spanisch usw. präzise funktionieren.

Im NLP hängt eine effektive Mensch-Computer-Interaktion von der Verfügbarkeit umfangreicher digitaler Daten ab. Sprachen, für die keine umfangreichen digitalen Ressourcen wie große Mengen an annotierten ASR-Daten (einschließlich Text und Audio) zur Verfügung stehen, werden als Low-Resource-Sprachen klassifiziert. Diese Knappheit ist in der Regel eher auf historische und strukturelle Faktoren zurückzuführen als auf die inhärenten Eigenschaften dieser Sprachen. In der digitalen Landschaft Indiens sind Hindi und Tamil in Sprachtools, Schnittstellen und ASR-Datensätzen stark vertreten. Urdu und Bengali (Bangla) haben ihren Ursprung zwar in Indien und werden dort seit langem gepflegt, sind aber auch Landessprachen benachbarter Nationen und haben daher ihre digitale Präsenz auf dem globalen Markt beschleunigt. Marathi – trotz seiner reichen literarischen Geschichte und obwohl es von über 85 Millionen Menschen gesprochen wird – verfügt oft nur über begrenzte Datenverfügbarkeit und Unterstützung für die Digitalisierung seiner sprachlichen Ressourcen. Bestehende Sprachassistenten und ASR-Systeme stehen weiterhin vor Herausforderungen wie falschen Aussprachen und ungenauen Transkriptionen. Selbst fortschrittliche ASR-Modelle wie Whisper, die auf „Multilingual Benchmarks“ trainiert wurden, haben Schwierigkeiten mit der dialektalen Vielfalt und skriptspezifischen Merkmalen. Folglich sind Interaktionen mit Technologie in Marathi möglicherweise nicht so effektiv oder nahtlos wie diejenigen in Englisch oder Hindi.

Was wir über das Fine-Tuning von ASR-Modellen wissen

Im ersten Teil dieser Blogserie haben wir uns mit der Funktionsweise des Fine-Tunings von ASR-Modellen befasst. Wir haben untersucht, dass vorab trainierte Spracherkennungsmodelle mithilfe domänenspezifischer Daten an bestimmte Domänen, Akzente, Sprachen und Umgebungen angepasst werden können, ohne dass ein Training von Grund auf erforderlich ist. Anhand einer Analogie zu den fein abgestimmten Parametern des Universums haben wir die entscheidende Rolle dieses Prozesses für die Wirksamkeit von Sprachtechnologie in vielfältigen und lokalisierten Anwendungen hervorgehoben, z. B. in klinischen Umgebungen oder bei regionalen Dialekten.

Wie wir gelernt haben, ermöglicht das Fine-Tuning eine bessere Anpassungsfähigkeit und Genauigkeit von ASR-Modellen, insbesondere in schwierigen Szenarien wie der Erkennung starker Akzente oder der Sprache von Kindern. Der Blogbeitrag hob auch wichtige Methoden und die Vorteile des Fine-Tunings bei der Erstellung kostengünstiger, domänenspezifischer Lösungen hervor.

Auf dieser Grundlage geht dieser Beitrag noch einen Schritt weiter.

Wir werden uns eingehender mit den Herausforderungen befassen, die sich beim Fine-Tuning von ASR-Modellen ergeben, insbesondere für Low-Resource-Sprachen. Wir werden uns mit den besonderen Schwierigkeiten befassen, die sich aus begrenzten Datenmengen und regionalen Dialekten ergeben, und Strategien zur Überwindung dieser Hindernisse untersuchen, um die ASR-Technologie in unterrepräsentierten Sprachen inklusiver und effektiver zu machen. Dies führt zu der entscheidenden Frage: Wie hoch sind die tatsächlichen „Datenkosten“ dafür? Finden wir es heraus!

Warum ASR für Low-Resource-Sprachen zählt: Zugang, Chancengleichheit und Teilhabe im Alltag

Automatische Spracherkennung (ASR) wird nicht nur für Live-Transkriptionen oder Untertitelung eingesetzt, sondern auch als praktisches Hilfsmittel, um das Mitschreiben zu erleichtern oder freihändige Kommunikation zu ermöglichen. Für zahlreiche Gemeinschaften, insbesondere in Regionen mit niedrigen Alphabetisierungsraten oder begrenzten digitalen Kenntnissen, ist die Stimme jedoch eine wichtige Schnittstelle für den Zugang zu Technologie. Mit anderen Worten: Für viele Menschen ist die Stimme das Tor zur digitalen Welt.

Beispielsweise sind Millionen von Menschen im heutigen „Digital India“ auf gesprochene Anweisungen und regionale Sprachassistenten angewiesen, um Dienstleistungen in den Bereichen Gesundheitswesen, Bildung und Notfallhilfe in Anspruch nehmen zu können.

Wenn sprachbasierte Systeme diese Sprachen nicht genau interpretieren können, laufen sie Gefahr, für diejenigen, die am meisten auf sie angewiesen sind, unzugänglich und unbrauchbar zu werden. In diesem Zusammenhang stellt die Entwicklung einer robusten ASR für Sprachen mit geringen Ressourcen nicht nur eine bedeutende technische Herausforderung dar, sondern ist auch ein entscheidender Faktor für die Förderung eines fairen Zugangs zu digitalen Diensten.

Von dieser gesellschaftlichen Perspektive aus wenden wir uns nun dem technischen Kern zu: Wie ermöglicht Fine-Tuning eine solche Inklusion?

Ein technischer Leitfaden: Fine-Tuning im Anwendungskontext

Wie wir bereits wissen, beinhaltet Fine-Tuning die Anpassung eines generischen ASR-Modells, um in bestimmten, oft eng definierten Kontexten eine bessere Leistung zu erzielen. Anstatt bei Null anzufangen, nehmen wir ein vortrainiertes Modell – wie OpenAI’s Whisper – und trainieren es neu mit neuen, domänen- oder sprachspezifischen Daten.

Die allgemeine ASR-Fine-Tuning-Pipeline umfasst:

1. Datenaufbereitung: Beschaffung und Bereinigung relevanter Audio-Text-Paare, Normalisierung von Transkripten, Trimmen oder Segmentieren von Clips, gegebenenfalls Ergänzung.

2. Datenvorverarbeitung: Vorbereitung von Trainings- und Validierungs-Batches und deren Verarbeitung durch Merkmalsextraktion (Log-Mel-Spektrogramme), Tokenisierung und Rückgabe trainierbarer Encoder-Decoder-Komponenten.

3. Modelltraining: Auswahl eines vortrainierten Checkpoints, Konfiguration von Hyperparametern, Laden von Trainings- und Validierungsbatches, Verwendung von Features wie Gradient Loss Optimization und Learning-rate Scheduling mit geeigneter Optimierungsmethode.

4. Bewertung: Messung der Genauigkeit anhand der Word Error Rate (WER) oder benutzerdefinierter Metriken und iterative Verfeinerung des Modells, bis die gewünschte Genauigkeit erreicht ist.

Dieser Ansatz ist effizient, skalierbar und besonders nützlich in Umgebungen mit geringen Ressourcen, in denen Rechenbudgets und Datenverfügbarkeit begrenzt sind

Fine-Tuning von ASR mit Whisper

Das im September 2022 veröffentlichte Whisper-Modell ist ein transformatorbasiertes, „schwach überwachtes” ASR-System, das auf 700.000 Stunden mehrsprachiger Daten trainiert wurde und aufgrund seiner Transkriptions-, Übersetzungs- und Nachbearbeitungsfunktionen sowie seiner Anpassungsfähigkeit an Low-Resource-Sprachen mit domänenspezifischen Daten schnell an Popularität gewann.

Diese Anpassungsfähigkeit ist besonders wichtig bei Sprachen wie Marathi, wo Standarddatensätze klein und Dialekte vielfältig sind.

Zum Fine-Tuning von Whisper stehen zahlreiche Ressourcen zur Verfügung, darunter Plattformen wie HuggingFace (siehe auch: HF-Blog, Medium 1, Medium 2). Diese Tutorials führen Sie Schritt für Schritt durch das Fine-Tuning des Whisper-Modells mit zusätzlichen Datensätzen, wobei häufig Open-Source-Datensätze wie CommonVoice, Multilingual-Librispeech und Google Fleurs verwendet werden. In der Praxis können jedoch benutzerdefinierte Datensätze erforderlich sein, die speziell auf den jeweiligen Anwendungsbereich zugeschnitten sind.

Der erste Schritt besteht darin, diese Datensätze gründlich zu untersuchen, um ihre Verwendbarkeit und Sauberkeit sicherzustellen. Faktoren wie die Signal-to-Noise-Ratio (S/N) im Audio, das Audioformat und die Abtastrate, die Abstimmung von gesprochenem Wort und Text, die Textkodierung (insbesondere für Ultra-Low-Resource-Sprachen, die Nicht-ASCII-Schriften verwenden) und die Audiodauer müssen berücksichtigt werden. Die Architektur von Whisper ist für Audioaufnahmen mit einer Länge von 3 bis 30 Sekunden optimiert, sodass das Trimmen oder Verknüpfen von Audiodateien oft notwendig ist. Darüber hinaus kann der Einsatz von Audio-Augmentationsverfahren die Robustheit verbessern und zu einer besseren Generalisierung des Modells beitragen.

Ausblick auf unsere Fallstudie zum Fine-Tuning von Whisper für die Low-Resource-Sprache Marathi

Um die realen Herausforderungen des Fine-Tunings von ASR für Low-Resource-Sprachen zu veranschaulichen, betrachten wir Marathi als Beispiel. Im nächsten Blogbeitrag tauchen wir in eine Fine-Tuning-Demo ein, die den Marathi-Trainingskorpus von Mozilla Common Voice und das Hugging Face Whisper-Fine-Tuning-Notebook verwendet. Im Rahmen des Beitrags liegt der Schwerpunkt weiterhin auf der Darstellung der Herausforderungen beim Fine-Tuning einer Low-Resource-Sprache und nicht auf der Präsentation eines vollständigen technischen Tutorials.

Bleib dran für den nächsten Teil der Reihe – in dem wir am Beispiel von Marathi zeigen, welche Rolle Tokenisierung spielt und wo dabei die größten Herausforderungen liegen.