Die rasanten Entwicklungen im Bereich der Künstlichen Intelligenz (KI) seit Anfang der 2010er Jahre haben in der Welt ihre Spuren hinterlassen. Unzählige neue Anwendungen sind entstanden, deren Höhepunkt in der Veröffentlichung von ChatGPT mündete. Die Auswirkungen auf die Gesellschaft sind immens: Modelle des Maschinellen Lernens helfen bei kritischen Prozessen wie der Krebsdiagnose, Betrugserkennung oder Vorhersage von Proteinstrukturen.

Die Modelle, die den KI-Anwendungen zugrunde liegen, werden verwendet, um in realen Situationen Entscheidungen zu treffen und Empfehlungen zu geben. In dem Bemühen, diese Situationen so genau wie möglich abzubilden, werden die Modelle mit riesigen Datenmengen trainiert, die in der realen Welt gesammelt wurden. Die Menge der Daten hängt von vielen Faktoren ab und variiert stark je nach Anwendungsfall. Ein prominentes Beispiel ist das LLM LLama3 von Meta, das auf 15 Billionen Token trainiert wurde und derzeit eines der besten Open-Source-LLMs ist.

Obwohl dieser Ansatz zur Lösung vieler Probleme gut geeignet ist, ist er mit mehreren ethischen Bedenken verbunden.

Ein Mangel an sorgfältiger Datenaufbereitung kann zu unerwünschten Ergebnissen führen. Bias in Datensätzen führt zu Fairness-Problemen, zur Aufrechterhaltung gesellschaftlicher Ungleichheiten und zur Diskriminierung von Minderheiten. Schlimmer noch, es besteht die Gefahr, dass private und vertrauliche Informationen durch Modellausgaben offengelegt werden und in die falschen Hände geraten. Darüber hinaus ist es aufgrund der Komplexität und Undurchsichtigkeit von Deep Learning Modellen oft schwierig, die Ursachen dieser Probleme zu ermitteln. All diese Probleme erfordern Maßnahmen von politischen Entscheidungsträger*innen und Entwickler*innen, um die ethische Nutzung von Daten zu gewährleisten.

In den folgenden Abschnitten beleuchten wir die oben genannten Probleme und zeigen auf, wie sie überwunden werden können. Außerdem gehen wir auf den rechtlichen Rahmen ein, der einen fairen und transparenten Handlungsspielraum für alle Beteiligten schaffen soll.

Bias und Fairness in KI-Trainingsdaten: Ethische Herausforderungen bewältigen

KI-Modelle stützen sich bei ihren Entscheidungen auf Daten aus der realen Welt. Diese Daten spiegeln jedoch häufig gesellschaftliche Vorurteile wider, was zu impliziten und expliziten Vorurteilen in Datensätzen führt. Diese Voreingenommenheit kann bestimmte Gruppen benachteiligen und zu unfairen Modellergebnissen führen, wenn bei der Datenauswahl und -bereinigung nicht auf die Vermeidung von Bias geachtet wird. Folglich können solche verzerrten Modelle für eine ethische Verwendung ungeeignet sein. Im Folgenden werden einige Beispiele für verschiedene Formen von Bias erläutert.

Was ist Bias in Trainingsdaten?

Bias in Trainingsdaten bezieht sich auf die systematische Bevorzugung bestimmter Entitäten oder Gruppen, während andere benachteiligt werden. Beim Maschinellen Lernen kann Bias durch verschiedene Faktoren entstehen, steht aber in der Regel in Zusammenhang mit Trainingsdaten. Es gibt mehrere Quellen von Verzerrungen (Bias):

- Systemischer Bias: Entsteht durch gesellschaftliche Bedingungen, in denen bestimmte Vorurteile in den Daten inhärent sind.

- Datenerfassung und -annotation: Bias kann während des Prozesses der Datenerfassung oder -Annotation entstehen.

- Algorithmus- oder Systemdesign: Manchmal entsteht Bias durch die Wahl des Algorithmus oder des Systemdesigns.

Das folgende Video bietet eine kurze Einführung in Bias und einige Faktoren, die dazu beitragen:

In der Vergangenheit gab es mehrere Fälle von Bias in KI-Anwendungen, die zu ethischen Problemen führten. Die nächsten Abschnitte zeigen zwei Beispiele, um verschiedene Arten von Bias zu veranschaulichen.

COMPAS-Algorithmus und rassistischer Bias

Einer der am häufigsten zitierten Fälle von Bias in der KI ist der COMPAS-Algorithmus, der verwendet wird, um die Rückfallwahrscheinlichkeit unter straffälligen Angeklagten in den Vereinigten Staaten zu messen. Der Algorithmus stuft schwarze Angeklagte im Vergleich zu weißen Angeklagten als überproportional rückfallgefährdet ein.

Das folgende Video enthält eine umfassende Kritik am COMPAS-Algorithmus, die dessen rassistische Ausrichtung hervorhebt und auf die ursprüngliche ProPublica-Studie verweist.

Der COMPAS-Fall ist besonders bemerkenswert, weil die Datenerhebung in einem kontrollierten Rahmen erfolgte. Wie in dem Video erwähnt, basieren die Vorhersagen auf einer Reihe von Fragen, die die Angeklagten beantworten müssen. Obwohl diese Fragen nicht offen diskriminierend zu sein scheinen, werden implizit Eigenschaften abgefragt und verurteilt, die eher mit schwarzen Personen in Verbindung gebracht werden. Dieser Designfehler des Algorithmus und des Fragebogens führte zu erheblichen algorithmischen und messtechnischen Verzerrungen (Bias). Zwar sollte das KI-Tool die Wahrscheinlichkeit einer Wiederholungstat vorhersagen, jedoch wurden die Fragen durch die Zuordnung zu einer ethnischen Gruppe verzerrt, anstatt das beabsichtigte Phänomen genau zu messen.

COMPAS ist nur eines von vielen KI-Tools, bei denen rassistischer Bias festgestellt wurde. Andere Beispiele sind ein Facebook-Bilderkennungstool, das schwarze Männer fälschlicherweise als „Primaten“ einstufte, und ein Optum-System, das die Gesundheitsbedürfnisse schwarzer Patienten aufgrund systematischer Ungleichheiten beim Zugang zu Pflege und Behandlung unterschätzte.

Amazon-Rekrutierungstool und Gender-Bias

Amazons Einsatz eines KI-Rekrutierungstools zur Unterstützung interner Einstellungsentscheidungen ist ein weiteres auffälliges Beispiel für Bias in der Technologie. Das Modell wurde mit Lebensläufen aus dem vergangenen Jahrzehnt trainiert, die überwiegend von männlichen Bewerbern verfasst wurden. Folglich stufte das KI-Modell Lebensläufe herab, die das Wort „Frauen“ enthielten oder reine Frauenhochschulen erwähnten.

Das folgende Video bietet einen Bericht über das Amazon-Tool:

Dieser Fall zeigt systemischen Bias, der aus der historischen Dominanz von Männern in der Technologiebranche resultiert. Er demonstriert auch, dass eine schlechte Kuratierung der Trainingsdaten zu Selektionsverzerrungen (Selection Bias) führt. Dies bedeutet, dass die Trainingsdaten aufgrund der Unterrepräsentation einer bestimmten Gruppe nicht repräsentativ für die gesamte Bevölkerung sind. In extremen Fällen kann sich dies als Ausschlussverzerrung (Exclusion Bias) manifestieren, was bedeutet, dass eine Gruppe vollständig ausgelassen wird.

Um solche Verzerrungen zu vermeiden, müssen Entwickler*innen bei der Datenerfassung auf ein ausgewogenes Geschlechterverhältnis achten. Dieser Ansatz könnte jedoch eine weitere Herausforderung darstellen: Die Ausgewogenheit der Lebensläufe beider Geschlechter hätte die Gesamtzahl der für das Training verfügbaren Lebensläufe (Daten) verringern können, was die Zuverlässigkeit des Modells beeinträchtigen könnte. Dieses Szenario veranschaulicht die Schwierigkeit, Verzerrungen aufgrund von Ressourcenbeschränkungen vollständig zu eliminieren.

Der Artikel “Amazon ditched AI recruitment software because it was biased against women” im MIT Technology Review bietet weitere Einblicke.

Erkennung und Reduktion von Bias

Bias in Modellen des Maschinellen Lernens kann in verschiedenen Formen auftreten und bleibt oft unbemerkt, bis die Modelle eingesetzt werden. Um solche Biases zu verhindern und unvoreingenommene Modelle zu trainieren, sind sorgfältige Überlegungen und systematische Ansätze erforderlich. Nachfolgend die wichtigsten Schritte, um diese Aufgabe zu bewältigen:

Überlegungen vor dem Training:

- Bewertung der Auswirkungen: Prüfen Sie, wie stark Ihr System das Leben der davon Betroffenen beeinflussen wird.

- Ethische Implikationen: Bestimmen Sie, ob es ethisch vertretbar ist, ein KI-System für die jeweilige Aufgabe Entscheidungen treffen zu lassen.

- Eignung der Daten: Stellen Sie sicher, dass Sie genügend und repräsentative Daten für alle betroffenen Gruppen haben.

Best Practices zur Erkennung und Vermeidung von Bias in KI-Systemen:

- Problemverständnis: Verstehen Sie das Problem, das Sie lösen wollen, vollständig.

- Überprüfung der Datenerhebung: Analysieren Sie Ihre Datenerhebungsmethode, um potenzielle Biases zu identifizieren und abzuschwächen

- Datenüberprüfung: Prüfen Sie die Daten sorgfältig, um latente Variablen wie Herkunft oder Geschlecht zu identifizieren, die möglicherweise nicht explizit angegeben werden.

- Vielfältige Testgruppen: Verwenden Sie Testgruppen, die die gesamte Datenpopulation genau repräsentieren und auch Ausnahmen abdecken.

- Ausgewogenheit der Gruppen: Versuchen Sie, Ungleichgewichte zwischen Gruppen so weit wie möglich zu vermeiden.

- Kreuz-Validierung: Verwenden Sie Techniken der Kreuz-Validierung, um das Modell auf verschiedenen Datensätzen zu testen.

- Overfitting vermeiden: Stellen Sie sicher, dass Ihr Modell gut generalisiert, indem Sie Overfitting verhindern.

- Kontinuierliches Monitoring: Überwachen Sie Modelle im Einsatz und sammeln Sie Feedback, um sie kontinuierlich zu verbessern und Bias zu minimieren.

Durch die Einhaltung dieser Vorgehensweisen können Sie das Risiko von Bias in Ihren KI-Systemen erheblich reduzieren und fairere und ethischere Modelle entwickeln.

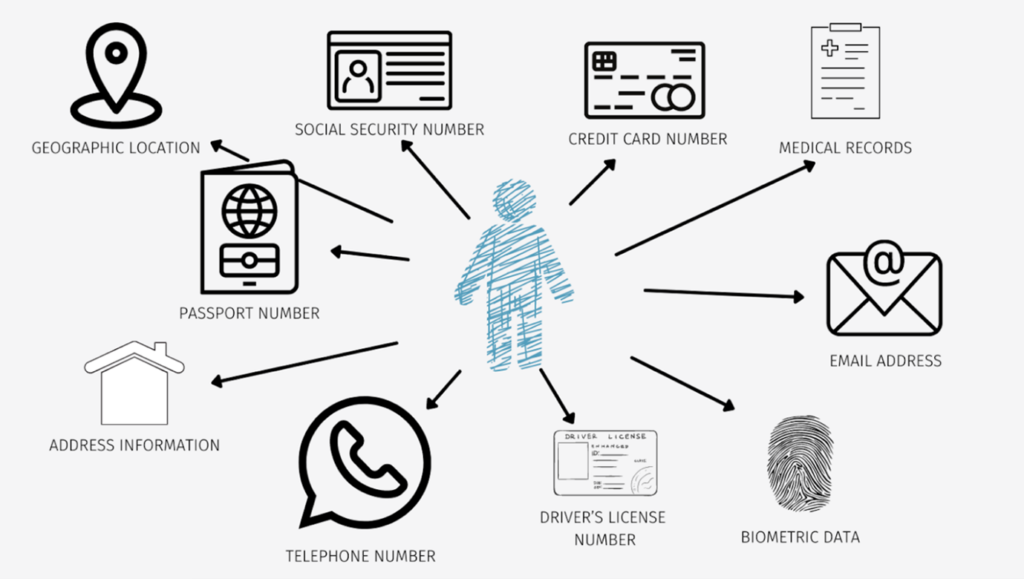

Datenschutz und Sicherheit

Gesetze zum Datenschutz und zum Schutz der Privatsphäre sind von entscheidender Bedeutung, um sicherzustellen, dass personenbezogene Daten ethisch korrekt und sicher behandelt werden. Einer der wichtigsten rechtlichen Rahmen ist die Datenschutz-Grundverordnung (DSGVO), die 2018 von der Europäischen Union erlassen wurde. Die DSGVO legt strenge Richtlinien für die Erhebung, Verarbeitung, Speicherung und Weitergabe personenbezogener Daten fest.

Die Kernprinzipien der DSGVO:

- Rechtmäßigkeit, Fairness und Transparenz: Entsprechend der Rechtsgrundlage müssen Sie klar darlegen, welche Daten erhoben werden und warum, um eine faire Nutzung der Daten ohne Benachteiligung einer Gruppe zu gewährleisten.

- Zweckbindung: Sammeln Sie Daten für festgelegte, eindeutige und legitime Zwecke und verarbeiten Sie sie nicht weiter auf eine mit diesen Zwecken unvereinbare Weise.

- Datenminimierung: Sammeln und verarbeiten Sie nur die Daten, die für den beabsichtigten Zweck notwendig sind.

- Richtigkeit: Halten Sie personenbezogene Daten genau und auf dem neuesten Stand.

- Speicherbegrenzung: Speichern Sie Daten nur so lange, wie es für den beabsichtigten Zweck notwendig ist.

- Integrität und Vertraulichkeit: Verarbeiten Sie Daten auf sichere Weise, um sie vor unbefugter oder unrechtmäßiger Verarbeitung und versehentlichem Verlust zu schützen.

- Rechenschaftspflicht: Organisationen müssen die Einhaltung dieser Datenschutzgrundsätze nachweisen können.

Das kürzlich erlassene EU-KI-Gesetz baut auf der DSGVO auf und klassifiziert KI-Systeme auf der Grundlage ihrer Risikostufen. Zu den „verbotenen KI-Systemen“ gehören zum Beispiel solche, die Personen auf der Grundlage biometrischer Daten kategorisieren, um bestimmte Arten sensibler Daten abzuleiten. Zusammen bieten die DSGVO und das EU-KI-Gesetz robuste Leitplanken für den Schutz der Privatsphäre und der Daten des Einzelnen.

Um diese gesetzlichen Vorschriften einzuhalten und personenbezogene Daten zu schützen, können verschiedene technische Maßnahmen ergriffen werden:

- Anonymisierung: Daten so ändern, dass persönliche Identifikatoren entfernt oder verschleiert werden, sodass sie nicht mehr auf eine Person zurückgeführt werden können.

- Federated Learning: Jede teilnehmende Einheit behält ihren Datensatz lokal, um ein maschinelles Lernmodell zu trainieren. Die Modellparameter werden geteilt und aggregiert, um sicherzustellen, dass die Daten dezentral und privat bleiben.

- Aktive Datenbesitzer-Beteiligung: Einbeziehung der Datenbesitzer in die Vorverarbeitung, das Training und die Bereitstellung. Die Vorverarbeitung und das anfängliche Training können lokal durchgeführt werden, um sicherzustellen, dass Rohdaten nie exponiert werden. Bei Bedarf kann das Training auf Servern erfolgen, mit lokalem Feintuning. Das endgültige Modell kann lokal bereitgestellt werden, um sensible Daten sicher zu halten.

Durch die Einhaltung dieser Praktiken und rechtlichen Rahmenbedingungen können wir personenbezogene Daten besser schützen und die Privatsphäre in der Ära der KI und des maschinellen Lernens wahren.

Potenzieller Missbrauch von personenbezogenen Daten: Ein anschauliches Beispiel

Ein potenzieller Datenschutzverstoß trat nach der Enthüllung des neuesten Flaggschiffmodells GPT-4o von OpenAI auf. Während der Präsentation demonstrierte das Modell eine Interaktion mit einer Stimme, die der von Schauspielerin Scarlett Johansson sehr ähnlich war. Trotz der Ablehnung von OpenAIs Angebot, für die Demo zu kooperieren, glaubt Johansson, dass ihre Stimme für GPT-4o geklont wurde. Obwohl der Nachweis, dass ihre Stimme im Training des Modells verwendet wurde, schwierig ist, ist die Ähnlichkeit auffallend.

Transparenz und Rückverfolgbarkeit

Über Fairness, Sicherheit und Vertraulichkeit hinaus fehlt es KI-Anwendungen oft an Transparenz. Moderne Deep Learning-Modelle sind komplex und auf großen Datenmengen trainiert, was ihre Entscheidungsprozesse schwer nachvollziehbar macht. In der Branche spricht man manchmal sogar von maschinellen Lernmodellen als „Black Boxes“, was problematisch ist, weil Benutzer und Kunden oft verstehen wollen, wie Systeme zu bestimmten Schlussfolgerungen gelangen, um ihnen zu vertrauen oder sie zu lenken.

Verbesserung der Datentransparenz und Rückverfolgbarkeit

Um Transparenzprobleme zu mindern, werden Strategien unter dem Begriff „Erklärbare KI“ eingesetzt. Ein Ansatz zur Erklärbarkeit besteht darin, Modellarchitekturen zu analysieren, um zu verstehen, wie Komponenten sich auf relevante Konzepte beziehen. Ein Beispiel dafür ist die Arbeit von Anthropic im Bereich der Erklärbarkeit von großen Sprachmodellen (LLMs): https://www.anthropic.com/news/mapping-mind-language-model.

Da die Daten in modernen Deep-Learning-Anwendungen oft einen größeren Einfluss auf die Ergebnisse haben als die Modellarchitektur, ist der interessantere Ansatz für diesen Blogbeitrag, wie man Trainingsdaten besser rückverfolgbar und transparent machen kann.

Ein wichtiger Schritt ist die Registrierung der Datenherkunft, was die Dokumentation bestimmter Arten von Informationen über die Daten bedeutet.

Es beantwortet die folgenden und verwandten Fragen:

- Woher stammen die Daten?

- Wo wurden die Daten gesammelt?

- Wie wurden die Daten gesammelt?

- Wer hat die Daten gesammelt?

- Zu welchem Zweck wurden die Daten gesammelt?

- Wie wurden die Daten vorverarbeitet?

- Welche spezifischen Eigenschaften haben die Daten?

- Welche möglichen Einschränkungen haben die Daten?

Zusätzlich ist es hilfreich, die Data Lineage (Entstehung und Veränderung der Daten) zu verfolgen, d. h. Änderungen in den Datensätzen aufgrund Datenerfassung oder Entfernung schädlicher Proben zu überwachen. Das genaue Wissen darüber, auf welche Daten ein Modell trainiert wurde, ist entscheidend für die Rückverfolgung der Ergebnisse.

Um eine präzisere Kontrolle zu erhalten, ist es sinnvoll, einzelne Datenpunkte überprüfbar und schnell durchsuchbar zu machen. Um noch einen Schritt weiterzugehen, empfiehlt es sich auch, detaillierte Informationen über falsch klassifizierte Daten während eines Trainingslaufs bereitzustellen. Beides hilft bei der Identifizierung problematischer Datenpunkte, die entfernt oder geändert werden können.

Durch die Einhaltung dieser Praktiken kann die Transparenz von KI-Systemen erhöht werden, was dazu beiträgt, Bias zu bekämpfen, Informationslecks nachzuverfolgen und Sicherheitsverletzungen zu erkennen. Wenngleich diese Schritte die Transparenz verbessern, bleibt es eine Herausforderung, die Ergebnisse von Machine-Learning-Modellen nachzuvollziehen und zu verfolgen. Entwickler sollten sich dieser Einschränkungen bewusst sein, wenn sie neue Modelle trainieren.

Fazit: Ethische Datenverarbeitung bei der Entwicklung von KI sicherstellen

Wie gezeigt, ist der ethische Umgang mit Daten in KI-Systemen entscheidend, um Fairness, Sicherheit und Transparenz zu gewährleisten. Indem wir diese Aspekte angehen, können wir Bias minimieren und personenbezogene Daten schützen, während wir Vertrauen aufrechterhalten. Dieser Beitrag soll das Bewusstsein für den ethischen Umgang mit Daten schärfen und Gespräche zwischen Benutzern, Entwicklern, Forschern und politischen Entscheidungsträgern anregen. Die behandelten Probleme sind weit davon entfernt, gelöst zu sein, und bleiben aktive Forschungsfelder. Wir hoffen, dass dieser Blogbeitrag Jeder und Jedem eine Orientierung bietet, um ethisch fundierte Modelle zu trainieren.