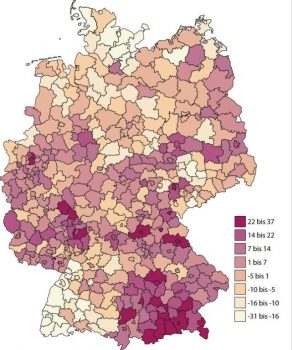

Im Strafrecht hängt das Sanktionsmaß eines Urteils von einer Vielzahl von Kriterien ab, wie der Schwere der Tat oder dem Vorstrafenregister des Täters. Allerdings konnte in Analysen, die von Wissenschaftler*innen des Max-Planck-Instituts zur Erforschung von Kriminalität, Sicherheit und Recht (MPI-CSL) durchgeführt wurden, ein weiterer Zusammenhang festgestellt werden: Die Strafmaße bei gleichem Tatbestand variieren in einigen Regionen Deutschlands mitunter stark. So fallen Urteile in Regionen Bayerns im Schnitt ca. 37% härter aus als im deutschlandweiten Durchschnitt.

Resultate einer Studie des MPI-CSL: Die Karte zeigt die prozentuale Abweichung der Sanktionshärte in juristischen Urteilen je Gerichtsbezirk vom Bundesdurchschnitt.

Um diesen Umstand weitergehend zu untersuchen, bedarf es einer eingehenderen Analyse von Urteilstexten. Hier begegnet man jedoch vielen Herausforderungen. Zum einen sind Informationen zum Tathergang und zur Strafzumessung nicht strukturiert abgelegt, sondern müssen je Fall aus dem Dokument zur Urteilsbegründung erschlossen werden. Zum anderen werden jährlich ca. 800.000 Urteile gefällt und der Aufwand, diese manuell zu bearbeiten, ist nicht tragbar. Hier setzt die Informationsextraktion an, die sich mit Verfahren zur automatisierten Erkennung von Informationen im Text beschäftigt und das Ziel verfolgt, unstrukturierte in strukturierte Informationen zu überführen.

Dokumentenklassifikation und Informationsextraktion: Vom Text zum Tabelleneintrag

Prof. Dr. Dr. Frauke Rostalski, Inhaberin des Lehrstuhls für Strafrecht, Strafprozessrecht, Rechtsphilosophie und Rechtsvergleichung, und ihre Mitarbeitenden an der Universität zu Köln widmen sich bereits seit 2018 der Fragestellung, wie Informationen aus Gerichtsurteilen extrahiert werden können. Seit 2019 arbeiten wir im Rahmen des ML2R gemeinsam an der Anwendung und Evaluierung von Technologien zur Automatisierung dieses Prozesses.

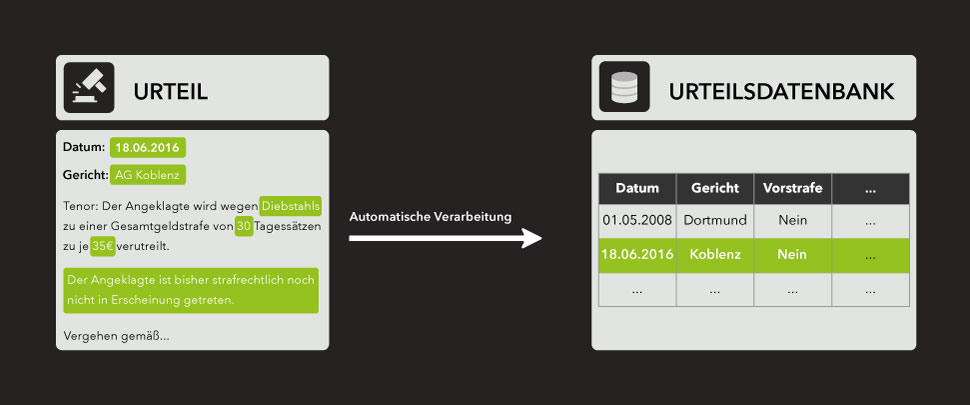

Bei der automatischen Verarbeitung möchten wir, wie in Abbildung 2 dargestellt, zwei Arten von Informationen erschließen:

(1) Einige Informationstypen, wie der Strafurteilstyp (Freispruch, Geldstrafe, Freiheitsstrafe) oder das Vorliegen einer Vorbestrafung der Angeklagten (ja / nein), können dabei nur eine feststehende Anzahl und Ausprägung von Werten annehmen. Bei diesen Informationstypen ist das Ziel, automatisiert für jedes Dokument zu entscheiden, welcher dieser Werte zugeordnet wird. Wir bezeichnen dies als Dokumentenklassifikation.

(2) Für einige andere Informationstypen, wie das Datum der Urteilsverkündung oder die Höhe der Strafe, gibt es keine solche Einschränkung. Sie können prinzipiell jeden beliebigen Wert annehmen. Um diese Information aus dem Text zu extrahieren, muss die Passage identifiziert werden, in der die Information steht. Dazu wird jedem Wort eine Klasse zugeordnet, die aussagt, ob das Wort die entsprechende Information enthält oder nicht.

Extraktion strukturierter Informationen aus Urteilstexten

Zwischen diesen Informationstypen können zusätzliche Zusammenhänge bestehen. So wird in einem Urteil, in dem eine Freiheitsstrafe verhängt wurde, keine Information zur Höhe einer Geldstrafe aufgeführt. Außerdem ist für diese Anwendungsdomäne bekannt, dass zum Beispiel vorbestrafte Täter*innen häufiger eine Gefängnisstrafe erhalten als nicht vorbestrafte Täter*innen. Dieses Hintergrundwissen soll zusätzlich berücksichtigt werden. Man bezeichnet diese wissensintegrierenden ML-Verfahren als Informed Machine Learning.

Im Folgenden beschreiben wir, wie wir mit Hilfe von Klassifikationsverfahren automatisch Informationen in Urteilstexten erkennen und sicherstellen, dass bereits bestehendes Hintergrundwissen berücksichtigt wird.

Mit Machine Learning den richtigen Inhalt finden

Wir halten fest: Um für jedes Dokument alle Informationen zu extrahieren, müssen zwei Arten von Entscheidungen getroffen werden: auf Dokumentenebene – zum Beispiel, ob im Urteil ein Vorstrafenregister erwähnt wird – und auf Wortebene – zum Beispiel, ob es sich bei einem Wort um eine der gesuchten Informationen, wie die Höhe der Strafe, handelt. Zur Automatisierung dieser Klassifikationsentscheidungen können verschiedene Arten von überwachten maschinellen Lernverfahren eingesetzt werden. Diese erfordern das Vorliegen von Trainingsdaten. Das bedeutet, dass zum Anlernen der Modelle Urteilstexte benötigt werden, in denen bereits vorannotiert (gelabelt) wurde, welche Klassen den Dokumenten und Wörtern zugeordnet wurden. Anhand dieser Beispiele lernt das Modell, die getroffene Entscheidung möglichst gut zu reproduzieren und dabei auf ungesehene Dokumente zu generalisieren.

Profitieren von Transfer-Lernen und Sprachmodellen

Um aus annotierten Texten zu lernen, wie die zugrundeliegenden Entscheidungsprobleme gelöst werden, muss in einem ersten Schritt eine vektorielle Repräsentation für den Text gefunden werden. Dazu wird jedes Wort im Dokument auf einen numerischen Vektor gemappt, der auch als Einbettungsvektor bezeichnet wird. Viele Verfahren, die auf neuronalen Netzen basieren, sind aufgrund ihres komplexen, in Schichten gelagerten Aufbaus sehr gut darin, zuerst eine solche Repräsentation für Wörter oder Sätze zu finden und dann darauf aufbauend zu lernen, das Klassifikationsproblem zu bewältigen. Ein Nachteil solcher Verfahren ist, dass sie eine große Menge an Trainingsdaten benötigen, die uns in der Praxis nur selten zur Verfügung stehen.

Deswegen wenden wir sogenanntes Transfer-Lernen an. Das bedeutet, dass wir das Modell zuerst auf einem Problem vortrainieren, für das uns bereits viele Trainingsdaten zur Verfügung stehen und dann auf ein anderes Problem nachlernen. In unserem konkreten Fall verwenden wir zur Repräsentation ein Modell, welches auf einem sehr großen deutschsprachigen Textkorpus vortrainiert wurde. Der Algorithmus lernt hierbei selbstüberwacht: Die Trainingsdaten werden direkt aus eigentlich ungelabelten Texten erzeugt, indem einzelne Passagen entfernt wurden, die ein Modell anschließend rekonstruieren soll.

Daten alleine reichen nicht: Mit Logik zum optimalen Ergebnis

Mit den obig beschriebenen Verfahren kann ein Modell gelernt werden, das in der Lage ist, jede Information in einem Urteilstext zu identifizieren. Klassifikationsentscheidungen werden hier allerdings unabhängig voneinander getroffen. Um je Urteilsdokument eine globale Lösung zu finden, sprich eine Reihe von in sich widerspruchsfreien Entscheidungen, verwenden wir ein Verfahren aus dem Bereich des statistischen relationalen Lernens: Probabilistic Soft Logic. Diese ermöglicht es, mit logischen Regeln ein probabilistisches graphisches Modell zu beschreiben. Wir nutzen dies, um Hintergrundwissen über Abhängigkeiten auf verständliche Weise in das Modell zu integrieren. So stellen wir zum Beispiel sicher, dass in einem Urteil, in dem eine Freiheitsstrafe verhängt wurde, kein Geldstrafen-Betrag erwartet wird oder eine Bewährung nur im Zusammenhang mit einer Freiheitsstrafe antizipiert wird. Zusätzlich werden Unsicherheiten bei der Vorhersage der einzelnen Klassen berücksichtigt, um eine möglichst konsistente globale Lösung zu finden.

Jenseits von datengetriebenem Lernen: Mit Hintergrundwissen zum besten Ergebnis

Wie man sieht, erlaubt uns die Kombination aus den vorgestellten Methoden eine Transformation der anfangs unstrukturierten Daten in strukturierte Daten. Das vorgestellte Projekt bildet damit die Basis für eine langfristige Zusammenarbeit mit den Fachexpert*innen der Universität zu Köln und ist ein wichtiger erster Schritt in Richtung einer transparenteren Strafzumessung in Deutschland. Durch die Anwendung von Verfahren, die nicht ausschließlich datengetrieben arbeiten, sind wir in der Lage, vorhandenes Expertenwissen direkt in den maschinellen Lernprozess zu integrieren. Die Erforschung von Methoden zur Extraktion von Informationen ist dabei nicht nur in dieser Domäne von Relevanz. Weitere mögliche Anwendungsbeispiele sind unter anderem die Aufbereitung oder Zusammenfassung von Patienteninformationen oder die Analyse von Verträgen im Finanzsektor.

Mehr Informationen in dem dazugehörigen Paper: Using Probabilistic Soft Logic to Improve Information Extraction in the Legal Domain. Birgit Kirsch, Sven Giesselbach, Timothée Schmude, Malte Völkening, Frauke Rostalski, Stefan Rüping: LWDA, 2020, PDF.