Nachdem wir uns in dem ersten und zweiten Blogbeitrag dieser Reihe mit den „Zutaten“ und „Rezepten“ des ASR-Fine-Tunings beschäftigt haben, wagen wir uns nun an ein reales Beispiel: Marathi, meine Muttersprache. Dieses Mal wollen wir sehen, wie sich die Transkriptionsqualität durch das Fine-Tuning des Whisper-Modells auf Marathi-Daten verbessern lässt – und welche Herausforderungen dabei auftreten.

Um die Nachvollziehbarkeit zu gewährleisten, verwenden wir ein Standard-Whisper-Modell („off-the-shelf“) und öffentlich verfügbare Daten aus Mozilla Common Voice. Ziel dieses Beitrags ist es nicht, ein vollständiges technisches Tutorial zu bieten, sondern die zentralen Herausforderungen beim Fine-Tuning eines ASR-Modells für eine Low-Resource-Sprache wie Marathi zu beleuchten.

Wer den praktischen Prozess selbst ausprobieren möchte, findet das vollständige Hugging-Face-Tutorial zum Fine-Tuning von Whisper hier.

Das aktuell verfügbare Common-Voice-Korpus für Marathi umfasst weniger als 30 Stunden Sprachdaten, von denen nur rund 70 % validiert sind.

Ein Fine-Tuning eines modernen Whisper-Modells auf etwa 25 Stunden Daten kann die Word Error Rate (WER) zwar deutlich senken, reicht aber nicht aus, um nahezu fehlerfreie Transkriptionen zu erreichen.

Neben der begrenzten Datenmenge ist auch die dialektale Vielfalt eine große Herausforderung. Marathi weist eine hohe sprachliche Diversität auf, insbesondere in ländlichen Regionen mit geringer digitaler Abdeckung. Dialekte wie Varhadi, Ahirani, Marathwada, Satara-Karad, Kolhapuri und Malvani unterscheiden sich stark in Aussprache, Wortwahl und Intonation. Ein Modell, das nur auf „Standard-Marathi“ trainiert wird, hat daher Schwierigkeiten, über Dialektgrenzen hinweg zu generalisieren – insbesondere im Vergleich zu den heute deutlich ausgereifteren ASR-Systemen für Englisch oder Hindi.

Herausforderungen der Tokenisierung in Marathi

Wie bereits in der ASR-Fine-Tuning-Pipeline beschrieben, erfolgt vor dem Training die Tokenisierung der Datensätze.

Ein Tokenizer zerlegt Text in kleinere Einheiten – sogenannte Tokens –, die anschließend vom Whisper-Transformer-Modell verarbeitet werden.

Dieser Schritt ist entscheidend, da eine ungenaue Tokenisierung die Erkennungsleistung bei Low-Resource-Sprachen deutlich mindern kann.

Für Marathi und ähnliche Sprachen entwickeln Forschende derzeit spezialisierte Tokenizer, etwa im Rahmen universitärer Projekte auf GitHub.

Marathi verwendet wie Hindi die Devanagari-Schrift, hat jedoch eigene phonologische Besonderheiten. Nasalierung, Diakritika (Matras), aspirierte Konsonanten und zusammengesetzte Grapheme erschweren die Tokenisierung und Ausrichtung. Die meisten ASR-Pipelines – selbst mehrsprachige – gehen von einer konsistenten Zuordnung von Zeichen und Lauten aus. Dies ist bei Marathi jedoch nicht immer der Fall.

Bei der englischen Tokenisierung wird Text in der Regel anhand von Leer- und Satzzeichen in Wörter unterteilt. Bei der Marathi-Tokenisierung erfolgt die Unterteilung dagegen auf Zeichen-, Wort- oder Teilwort-Ebene. Dabei werden Matras, also Symbole, die bei der Anwendung auf Konsonanten in Vokale umgewandelt werden, besonders berücksichtigt.

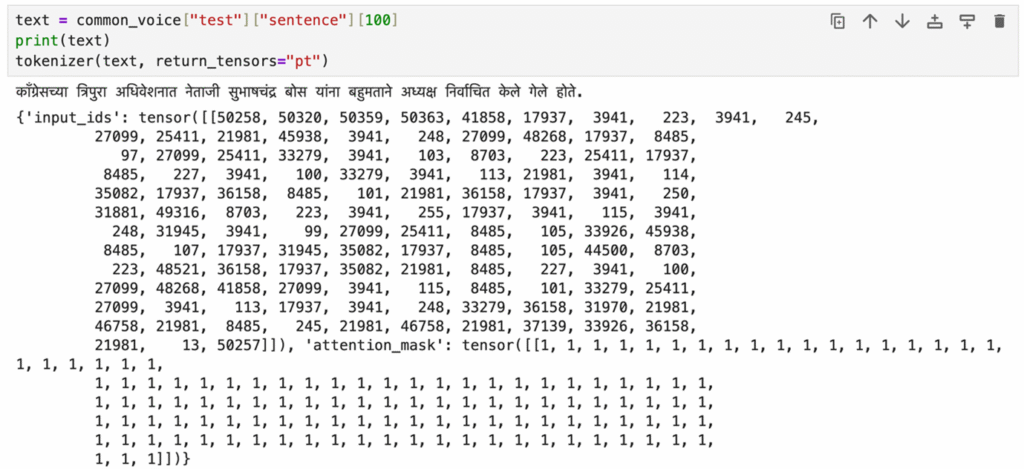

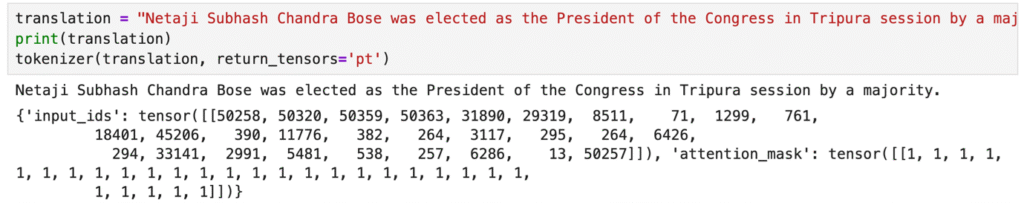

Um das Thema besser zu verstehen, vergleichen wir das Verhalten der Tokenisierung im Englischen und Marathi.

- Englische Tokenisierung: Die Aufteilung des Textes in einzelne Wörter erfolgt anhand von Leer- und Satzzeichen. Der Satz „This is a mouse.“ würde beispielsweise in „[This“, „is“, „a“, „mouse“, „.]“ tokenisiert werden. Eine andere Form der Tokenisierung findet auf der Ebene einzelner Zeichen statt. Der gleiche Satz würde in diesem Fall in [„T“, „h“, „i“, „s“, „ “, „i“, „s“, „ “, „a“, „ “, „m“, „o“, „u“, „s“, „e“, „.“] tokenisiert werden. Im nächsten Schritt wird jedem Token eine entsprechende ID (eine Zahl) zugewiesen, die dann in das Modelltraining übernommen wird.

- Marathi-Tokenisierung: Die Tokenisierung erfolgt in Marathi auf Zeichenebene. Das kann problematisch sein, da dadurch Matras von ihren Basiszeichen getrennt werden können. Die richtige Behandlung der Matras ist entscheidend, um die Bedeutung von Marathi-Wörtern zu erhalten. Standard-Tokenizer für Devanagari-basierte Schriften sind eher auf Hindi ausgerichtet. Marathi ist eine morphologisch reiche Sprache, das heißt, Wörter haben komplexe Formen. Die Teilwort-Tokenisierung kann besonders hilfreich sein, um den Kontext in solchen Sprachen zu bewahren.

Beispiele:

- Englisch: Das Wort „to ask“ würde vermutlich als ein einziges Wort tokenisiert werden.

- Marathi: Das Wort „विचारणे“ (vicharNe) könnte als [„व“, „ि“, „च“, „ा“, „र“, „ण“, „े“] (Zeichen) oder als [„विचार“, „णे“] (Teilwort, das ein Verb enthält, also ein Substantiv mit Infinitivsuffix) tokenisiert werden. Letzteres wird im Allgemeinen bevorzugt, da es die Bedeutung des Wortes bewahrt. Sowohl die englische als auch die Marathi-Tokenisierung zielen im Wesentlichen darauf ab, Text in für NLP-Modelle verarbeitbare Einheiten zu zerlegen. Aufgrund ihrer Morphologie und der Bedeutung von Diakritika stellt die Marathi-Tokenisierung jedoch besondere Herausforderungen dar. Einige dieser Herausforderungen werden in den zuvor erwähnten Open-Source-Tokenizern für indische Sprachen gelöst.

Die Abbildung 1 zeigt die Tokenisierung auf Zeichenebene für Marathi im Vergleich zum Englischen. In Whisper können die Einschränkungen des Zeichentokenisierers, insbesondere die maximale Tokenlänge, das Training beeinträchtigen, da sie die Fähigkeit des Modells zur Verarbeitung langer Text- oder Audiosequenzen einschränken. Dies ist besonders kritisch bei dialogorientierter oder narrativer Sprache, bei der die Kontinuität des Kontexts von entscheidender Bedeutung ist. Dies kann zu einem Verlust des Kontexts in längeren Gesprächen oder Audiosegmenten führen und insbesondere bei Aufgaben, die detaillierte Transkriptionen oder weitreichende Abhängigkeiten erfordern, zu einer verminderten Genauigkeit führen. Um dieses Problem zu mindern, passen Forschende häufig den Parameter „max-length“ in den Trainingsargumenten an, sodass das Modelle längere Sequenzen verarbeiten können und somit bessere Fine-Tuningsergebnisse erzielen.

Nachdem wir die Herausforderungen der Tokenisierung analysiert haben, ist es wichtig, das umfassendere Daten-Ökosystem für Low-Resource-Sprachen zu betrachten. Schließlich mangelt es an allgemein verfügbaren annotierten Sprachkorpora. Initiativen wie Mozillas Common Voice umfassen zwar Marathi, aber die Abdeckung ist minimal und oft auf geskriptete Sprache ausgerichtet. Diese Einschränkung unterstreicht, wie wichtig es ist, alle verfügbaren Ressourcen effizient zu nutzen, wenn man mit Low-Resource-Sprachen arbeitet. Durch die Verwendung der Whisper-Pipeline von HuggingFace und die Feinabstimmung des „large-v2”-Modells mit dem Common Voice 11.0 Marathi-Korpus lässt sich eine erhebliche Verbesserung der WER erzielen (siehe Abbildung 2), die jedoch bei weitem nicht an die Qualität moderner englischer ASR-Systeme heranreicht.

Da Common Voice auf freiwilligen Beiträgen basiert, sind spontane Sprachmuster und dialektale Variationen tendenziell unterrepräsentiert. Es kann zu Unstimmigkeiten in der Audioqualität, der Genauigkeit der Annotationen sowie der Vielfalt der Sprecher:innen kommen. Wie bereits erwähnt, handelt es sich jedoch um ein laufendes Projekt und die WER, die in der obigen Tabelle angegeben ist, könnte mit mehr Daten insgesamt verbessert werden. Die Frage nach den Dialekten bleibt jedoch offen und es sind erhebliche Anstrengungen im Rahmen von Crowdsourcing- und gemeinnützigen Projekten erforderlich, um mehr Daten zu sammeln. Viele Projekte wie ai4bharat, OpenSLR und GramVaani wurden bereits durchgeführt, um Sprachen wie Marathi im Bereich NLP und ASR auf eine Stufe mit Englisch, Französisch, Deutsch usw. zu stellen. Das jüngste Projekt des Indian Institute of Science (IISc Bengaluru) ist ambitioniert und umfasst den bislang größten Datensatz, der nach seiner Fertigstellung 150.000 Stunden Audioaufnahmen aus allen Distrikten Indiens enthalten wird.

Schlüsselmethoden zur Sprachanpassung in ASR-Modellen

Nachdem wir uns mit den Herausforderungen der Tokenisierung sowie den Einschränkungen von Datensätzen befasst haben, ist es wichtig zu verstehen, wie sich ASR-Systeme an neue Sprachen und Kontexte anpassen lassen. Die Sprachanpassung umfasst die Integration einer neuen Sprache in die Wissensbasis des Modells, wodurch sich dessen Leistung in verschiedenen Umgebungen verbessert. Die drei wichtigsten Arten der Anpassung sind:

- Anpassung an Akzente und Dialekte: Fine-Tuning eines Modells mit verschiedenen ASR-Daten, die Akzente und Dialekte enthalten. Dies ist für eine höhere Genauigkeit bei unterschiedlichen regionalen Daten unerlässlich.

- Umgebungsanpassung: Anpassung eines ASR-Modells an unterschiedliche Umgebungsbedingungen wie Hintergrundgeräusche oder mehrere Sprecher*innen. Dies erhöht die Robustheit des Modells und ermöglicht eine gute Leistung in lauten oder schwierigen Umgebungen.

- Domänenanpassung: Ein ASR-Modell wird auf einen bestimmten Bereich oder eine bestimmte Branche, z. B. das Gesundheitswesen, das Finanzwesen oder den Kundenservice, abgestimmt. Dadurch kann das Modell Fachvokabular und Fachjargon erkennen, was seine Leistung in kontextspezifischen Anwendungen erheblich verbessert. Alternativ kann auch der Ansatz der Entitätserkennung genutzt werden, um das Modell an den erwarteten Bereich anzupassen.

Diese Anpassungsmethoden tragen gemeinsam dazu bei, die Genauigkeit und Robustheit von ASR-Modellen zu verbessern. Dadurch werden sie vielseitiger und effektiver für verschiedene Sprachen, Akzente und Dialekte sowie Umgebungen und Branchen.

Herausforderungen beim Fine-Tuning für Low-Resource-Sprachen und wie man diese überwindet

Das Fine-Tuning von ASR-Modellen für Low-Resource Sprachen ist besonders herausfordernd:

- Datenknappheit: Die Erfassung hochwertiger, annotierter Daten für unterrepräsentierte Sprachen ist eine große Herausforderung. Für diese Sprachen fehlen oft die notwendigen Ressourcen, um effektive Modelle zu trainieren.

- Vielfalt der Dialekte: Wie bereits erwähnt, ist die Erfassung dialektisch vielfältiger Daten entscheidend, um das Modell anwendbarer und realistischer zu machen. Die eigentliche Herausforderung besteht darin, statistisch faire Stichproben aus verschiedenen Regionen zu erhalten, da sonst die Gefahr einer Verzerrung des Modells (Bias) besteht.

- Ressourcenbeschränkungen: Die Erfassung und Verarbeitung von Daten sowie die Vorverarbeitung und das Training von ASR-Modellen erfordern hochwertige Geräte und GPU-basierte Rechenressourcen. In einigen Regionen, in denen diese Sprachen gesprochen werden, sind diese möglicherweise nicht ohne Weiteres verfügbar.

- Verstärkung von Verzerrungen (Bias): Begrenzte Datenmengen können auch Verzerrungen verstärken, was zu unfairen oder ungenauen Ergebnissen bei Spracherkennungsaufgaben führen kann.

Ein Bewusstsein für diese Probleme ist Voraussetzung, um wirksame Lösungsstrategien zu entwickeln.

Strategien zur Verbesserung von ASR-Modellen für Low-Resource Sprachen

Zur Bewältigung dieser Herausforderungen können verschiedene Ansätze kombiniert werden:

- Datenvergrößerung: Techniken wie Rauschaddition, Tonhöhenmodulation und Text-to-Speech-Generierung können dazu beitragen, kleine Datensätze zu erweitern und vielfältiger sowie robuster zu machen.

- Sprachübergreifender Transfer: Die Nutzung von Modellen, die zuvor auf phonetisch oder linguistisch verwandten Sprachen trainiert wurden, kann dabei helfen, Modelle für neue Low-Resource Sprachen zu optimieren, selbst wenn nur begrenzt Daten verfügbar sind. Diese Technik wird von ASR-Forschenden für viele Low-resource Sprachen in großem Umfang angewendet.

- Einbindung der Gemeinschaft: Die Zusammenarbeit mit lokalen Gemeinschaften bei der Erfassung und Kommentierung von Daten gewährleistet eine bessere Repräsentation und genauere Modelle für Low-resource Sprachen.

Durch die Kombination dieser Strategien lässt sich die Leistungsfähigkeit von ASR-Systemen in Low-Resource-Sprachen erheblich steigern – ein Schritt zu mehr digitaler Inklusion.

Zukünftige Entwicklungen beim Fine-Tuning von ASR-Modellen: Brücken bauen für Low-Resource-Sprachen

Das Fine-tuning modernster ASR-Modelle ist ein dynamisches und sich ständig weiterentwickelndes Forschungsgebiet. Von den historischen Anfängen bei der Anpassung akustischer und sprachlicher Modelle bis hin zu den aktuellen Herausforderungen durch Low-Resource Sprachen ist das Fine-Tuning ein entscheidender Faktor, um die nächste Leistungsstufe der Automatischen Spracherkennung (ASR) zu erreichen. Obwohl weiterhin Herausforderungen bestehen, bieten Fortschritte in den Bereichen Datenvergrößerung, Transferlernen, entitätsbasiertes Fine-Tuning (Vokabularerweiterung) und parametereffiziente Fine-Tuning-Methoden (z. B. LoRA oder Adapter) vielversprechende Wege zu höherer Genauigkeit und Domänenverallgemeinerung.

Die entscheidende Frage für die Forschungsgemeinschaft lautet nun, wie diese Methoden genutzt werden können, um Modelle zu erstellen, die nicht nur in kontrollierten Benchmarks gut abschneiden, sondern sich auch in realen Szenarien effektiv verallgemeinern lassen.

Das Fine-Tuning ist nach wie vor ein leistungsstarker Mechanismus, um ASR-Modelle an bestimmte Domänen, Sprachen oder akustische Umgebungen anzupassen. Im Zusammenhang mit Low-Resource Sprachen ist dieser Prozess aufgrund begrenzter Korpora und hoher dialektaler Unterschiede nicht nur technisch anspruchsvoll, sondern auch unerlässlich, um die sprachliche Abdeckung in globalen KI-Anwendungen zu verbessern. Strategien wie Datenvergrößerung, selbstüberwachtes Vortraining und sprachübergreifender Transfer unter Nutzung typologisch verwandter Sprachen dürften zu weiteren Verbesserungen führen.

Aus wissenschaftlicher Sicht ist die Integration von Community-basierten Korpora mit robusten Bewertungsrahmen für das Verständnis des Modellverhaltens über die Standard-WER-Metriken hinaus entscheidend, insbesondere für spontane Sprache und dialektreiche Kontexte. Durch die Konvergenz von groß angelegten Vortrainings, effizienten Fine-Tuningsmethoden und kollaborativer Datenerfassung wird erwartet, dass ASR-Systeme in verschiedenen Sprachen und in realen Szenarien effektiver werden.

Langfristig werden diese Entwicklungen nicht nur die Anwendbarkeit von ASR erweitern, sondern auch zu einem gerechteren Zugang zu Sprachtechnologien beitragen. Zudem werden sie eine spannende Forschungsagenda an der Schnittstelle von NLP, Sprachverarbeitung und mehrsprachiger KI bieten.