Computer-Vision-Systeme werden mit großen Datensätzen trainiert, die aus Hunderttausenden von Bildern bestehen. Viele dieser Bilder wurden zuvor von menschlichen Datenannotator*innen interpretiert, klassifiziert und gekennzeichnet. Durch die Datenannotation legen Menschen fest, was Maschinen „sehen“ lernen und wie sie die Welt interpretieren werden.

Formell beinhaltet die Datenannotation für Computer Vision Aufgaben wie Kuratierung, Kennzeichnung, Verschlagwortung sowie semantische Segmentierung, die darin besteht, die verschiedenen Objekte in einem Bild zu markieren und zu trennen. Aber über formale Aufgabenbeschreibungen hinaus geht es bei der Annotation im Wesentlichen darum, Daten zu verstehen, also die in jedem Bild enthaltenen Informationen zu interpretieren. Nicht nur die Daten selbst, sondern auch ihre Interpretationen sind grundlegend für Computer Vision.

Genauso wie Trainingsdaten Systeme konditionieren, werden Datensätze durch die Produktionskontexte, in denen sie erstellt, entwickelt und eingesetzt werden, beeinflusst. Neben technischer Übung und Betrieb erfordert die Arbeit mit Computer-Vision-Datensätzen das Beherrschen von Interpretationsformen. Daher ist die Untersuchung der Datenherkunft und der Arbeitspraktiken bei der Datenproduktion unerlässlich, um die subjektiven Weltanschauungen und Annahmen zu erforschen, die in Datensätzen und Modellen eingebettet sind.

Subjektivität der Arbeiter*innen oder Top-Down-Vorgaben?

In einem kürzlich in den Proceedings of the ACM on Human-Computer Interaction veröffentlichten Artikel haben wir eine Studie zu den Arbeitspraktiken der Bildannotation in industriellen Umgebungen vorgestellt. Die Forschungsarbeit basiert auf mehreren Wochen Beobachtungen und Interviews, die in Argentinien und Bulgarien bei zwei auf Datenannotation für Computer Vision spezialisierten Unternehmen durchgeführt wurden. Wir untersuchten die Rolle der Subjektivität der Arbeiter*innen bei der Klassifizierung und Kennzeichnung von Bildern und beschrieben Strukturen und Standards, die die Interpretation von Daten prägen.

Wie viele andere Untersuchungen stellt auch unsere Studie die oft der algorithmischen Systeme zugeschriebene rechnerische Neutralität in Frage, indem sie den Fokus auf die Menschen hinter der Maschine legt. Während sich jedoch frühere Forschungen weitgehend auf die Analyse und Minderung von Voreingenommenheiten der Arbeitskräfte konzentrieren, zeigen unsere Ergebnisse, dass Annotator*innen in ihren Interpretationen nicht völlig frei sind und daher Voreingenommenheiten nicht eigenständig in die Daten einbringen können.

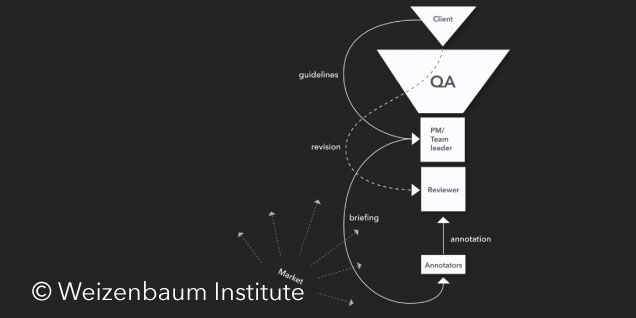

Mehrere als Voreingenommenheit gerahmte Probleme sind tatsächlich Manifestationen von Machtgefällen, die die Daten grundlegend prägen. Solche Machtgefälle sind so trivial wie der Kunde, der die Annotationen anfordert und bezahlt, oder der Annotator, dessen Job auf dem Spiel steht, wenn er den Anweisungen nicht folgt. In diesen Kontexten folgen die Annotator*innen den genauen Anweisungen der Kunden, annotieren Daten gemäß vordefinierten Labels und vertrauen auf das Urteil der Manager, wenn Unklarheiten auftreten. Kunden haben die Macht, ihre bevorzugten Interpretationen durchzusetzen und zu definieren, welche Labels jedes Bild am besten beschreiben, weil sie diejenigen sind, die für die Annotationen bezahlen. Daher ist die Interpretation von Daten, die Annotator*innen vornehmen, tiefgehend durch die Interessen, Werte und Prioritäten derjenigen Stakeholder eingeschränkt, die mehr (finanzielle) Macht haben.

Kurz gesagt, Machtgefälle prägen Computer-Vision-Datensätze viel mehr als die Subjektivität der Annotator*innen. Daten werden durch hierarchische Strukturen und nach vordefinierten Erwartungen und Interessen annotiert. Briefings, Richtlinien, Managementaufsicht und Qualitätskontrolle zielen darauf ab, die Anforderungen der Kunden zu erfüllen. Interpretationen und Labels werden vertikal den Annotator*innen und durch sie den Daten auferlegt.

Diese Vorgabe wird meist als selbstverständlich hingenommen, da es als gesunder Menschenverstand erscheint, dass Annotationen gemäß den Präferenzen zahlender Kunden durchgeführt werden. Allerdings verschleiert die Verinnerlichung solcher hierarchischen Prozesse die Tatsache, dass Computer-Vision-Systeme lernen, die Realität gemäß den Interessen derjenigen zu „sehen“ und zu beurteilen, die über die finanziellen Mittel verfügen, ihre Weltanschauungen den Daten aufzuzwingen.

Implikationen für Industrie und Forschung

Die Datenannotation wird oft als technische Angelegenheit dargestellt. Diese Untersuchung zeigt jedoch, dass es sich in der Tat um eine Machtausübung mit vielfältigen Implikationen für Systeme und Gesellschaft handelt. Was bedeuten unsere Ergebnisse also für Industrie und Forschung?

Erstens zeigen diese Ergebnisse, dass Computer-Vision-Systeme durch menschliche Arbeit geschaffen und von kommerziellen Interessen geprägt werden. Leider wird diese Tatsache oft durch den Enthusiasmus der Technolog*innen unsichtbar gemacht. Bevor das intelligenteste System „sehen“ kann, müssen Menschen zuerst die Daten, die es speist, verstehen. Die Industrie sollte die menschliche Arbeit anerkennen, die in die Erstellung von Computer-Vision-Systemen einfließt, und die Forschung sollte tiefer in die Arbeitsbedingungen und die Machtverhältnisse eintauchen, die Datensätze, Kennzeichnungsprozesse und Systeme tiefgehend prägen.

Zweitens argumentieren wir, dass Techniken und Methoden zur Minderung der Voreingenommenheit von Annotator*innen nur teilweise wirksam bleiben, solange Produktionskontexte und Machtdynamiken unberücksichtigt bleiben. Von der Annahme auszugehen, dass Machtungleichgewichte das Problem sind und nicht individuelle Voreingenommenheiten, führt zu grundlegend anderen Forschungsfragen und Untersuchungsmethoden. Ein Perspektivwechsel in der Forschung ist notwendig, um über Ansätze hinauszugehen, die tendenziell die Verantwortung für datenbezogene Probleme ausschließlich den Datenannotator*innen zuweisen.

Schließlich plädieren wir für die systematische Dokumentation von Computer-Vision-Datensätzen. Die Dokumentation sollte natürlich die technischen Merkmale der Datensätze widerspiegeln, aber auch die Akteure, Hierarchien und Rationalitäten hinter den vergebenen Labels explizit machen. Denn wenn der Kontext, in dem Daten annotiert wurden, undurchsichtig bleibt, werden wir nicht in der Lage sein, die Annahmen und Vorgaben zu verstehen, die in Datensätzen kodiert und von Computer-Vision-Systemen reproduziert werden.

Weitere Informationen zur Studie finden Sie in den entsprechenden Veröffentlichungen:

Between Subjectivity and Imposition: Power Dynamics in Data Annotation for Computer Vision.

Milagros Miceli, Martin Schuessler, and Tianling Yang. Proc. ACM Hum.-Comput. Interact. 4, CSCW2, Article 115 (October 2020), 25 pages. PDF

Documenting Computer Vision Datasets: An Invitation to Reflexive Data Practices.

Milagros Miceli, Tianling Yang, Laurens Naudts, Martin Schuessler, Diana Serbanescu, Alex Hanna. FAccT ’21: Proceedings of the 2021 ACM Conference on Fairness, Accountability, and Transparency, 2021. PDF