In diesem Beitrag gibt Sebastian Müller, Wissenschaftler am Lamarr-Institut für Maschinelles Lernen und Künstliche Intelligenz an der Universität Bonn, einen kompakten Überblick über das vielfältige Gebiet der Künstlichen Intelligenz. Er zeigt hierbei die unterschiedlichen Blickwinkel innerhalb des Feldes und Zusammenhänge mit anderen Forschungsfeldern auf und erklärt die Abstraktion von Verhalten durch das Agentenmodell.

Intelligenz? Verhalten vs. Denken, Imitation vs. Optimierung

Die Künstliche Intelligenz (KI) beschäftigt sich mit der Algorithmisierung kognitiver Leistungen – das heißt mit der Suche nach formalen Rechenvorschriften (Algorithmen), mithilfe derer ein Computer konkrete oder abstrakte Aufgaben lösen kann, für deren Bewältigung die Notwendigkeit irgendeiner Form von Intelligenz angenommen wird.

Da es für den Begriff „Intelligenz“ keine formale, allgemeingültige Definition gibt, nähert sich die KI-Forschung dem Thema aus mehreren Richtungen an:

Nehmen wir eine externe Betrachtungsweise ein, so ist das Ziel, beobachtbares „intelligentes“ Verhalten zu erzeugen. Motivation dazu findet man schon sehr früh in der Geschichte der KI: Nach Erfindung des digitalen Computers dauerte es nicht lange bis Alan Turing 1950 vorschlug, zu erforschen, ob es ein Programm gibt, welches in einer schriftlichen Konversation (Chat) nicht von einem Menschen zu unterscheiden ist. Von Turing selbst ursprünglich als „Imitationsspiel“ benannt, ist das zugehörige Experiment heute als „Turing-Test“ bekannt.

Beginnt man mit Überlegungen dazu, wie beobachtbares Verhalten erzeugt werden kann, ergeben sich schnell Fragen nach der Funktionsweise interner Prozesse, die zu eben diesem Verhalten führen: Wie funktionieren zum Beispiel Denken, Erinnern oder Lernen?

Ob nun das Erzeugen von Verhalten oder die Simulation interner Prozesse das Ziel sind, Menschen (oder andere Tiere) bieten nur eine mögliche Referenz. Häufig haben wir eine Intuition, ob eine bestimmte Aktion in einer Situation „gut“ oder „schlecht“ war. Lässt sich diese Intuition als mathematisches Kriterium formulieren, so kann ein Algorithmus versuchen, sein Verhalten danach zu optimieren. Das Verhalten wir dann in diesem Sinne auch als rational bezeichnet.

Künstliche Intelligenz als interdisziplinäres Forschungsfeld

Das Feld der Künstlichen Intelligenz bedient sich zwar Methoden der Informatik aber aus den oben genannten Motivationen wird klar: Die Fragestellungen und Ziele überschneiden sich stark mit anderen Disziplinen. In der Tat ist Künstliche Intelligenz nicht nur Teil der Informatik, sondern wird auch zu den Kognitionswissenschaften gezählt. Zu den Kognitionswissenschaften gehören außerdem Teile der Neurowissenschaften, Psychologie, Philosophie, Linguistik und Anthropologie. All diese Disziplinen tragen Ansätze bei, welche Verhalten beschreiben oder Hypothesen über die Funktionsweise interner Prozesse entwickeln. Diese versucht der Forschungsbereich KI dann letztendlich zu algorithmisieren. Aus diesen Verbindungen sind selbst ganze Forschungsgebiete entstanden.

Am Beispiel des Turing-Tests wird die Verbindung zwischen KI und anderen Fachdisziplinen deutlich: Um den Test zu bestehen, muss eine KI in Echtzeit unter anderem Sprache verarbeiten und erzeugen (Linguistik), logisch denken (Philosophie), auf Allgemeinwissen zugreifen und neue Informationen aufnehmen (Neurowissenschaften und Psychologie). Wo die Grenze zwischen Imitation und „echtem“ Verhalten liegt und ob Computer überhaupt an diese Grenze stoßen können, ist eine klassische Debatte (man siehe zum Beispiel das Gedankenexperiment „Chinesisches Zimmer“).

Das Agentenmodell

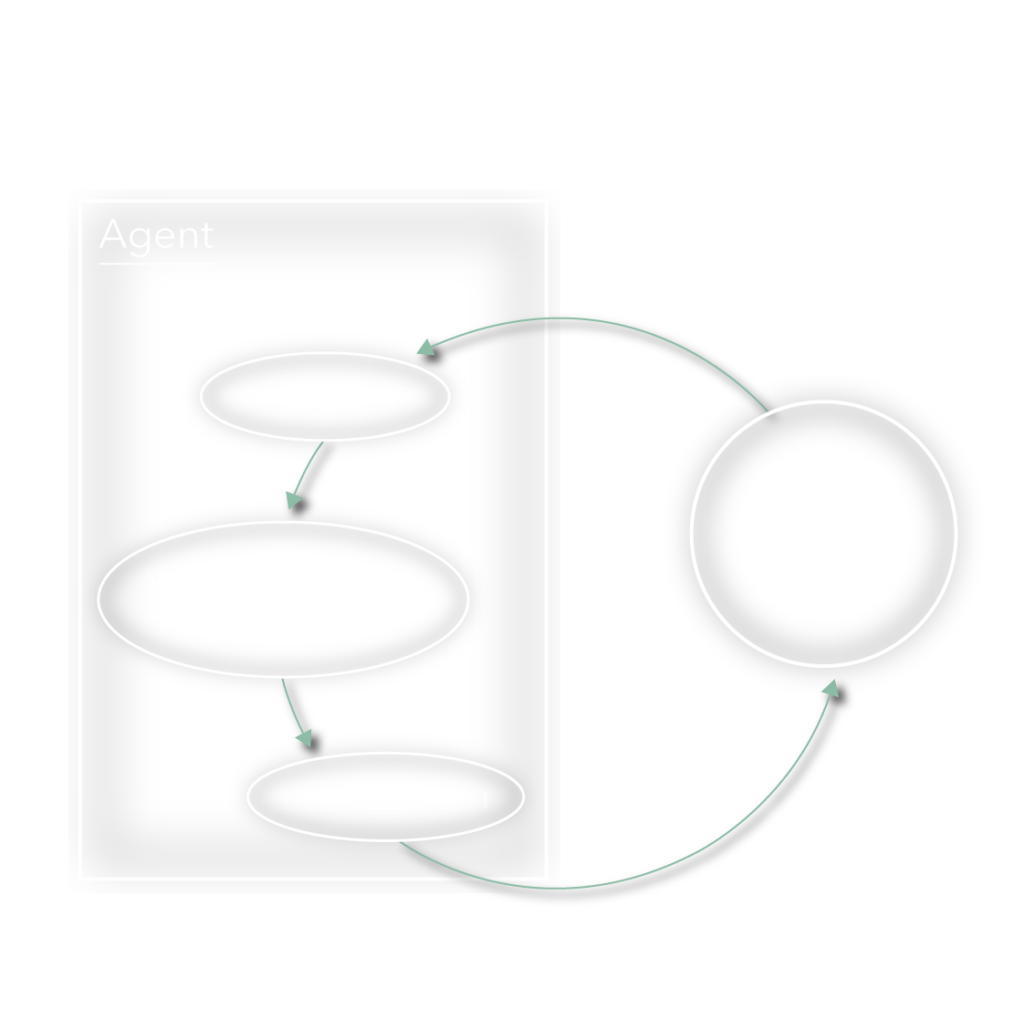

Wir halten fest: In einem ersten Schritt geht es bei der Künstlichen Intelligenz darum, „Verhalten“ zu abstrahieren. Das grundlegendste Konzept hierfür ist das Agentenmodell. Mit Hilfe dieses Modells können einfache und komplexe handlungsfähige Systeme beschrieben werden.

Im Agentenmodell werden zunächst der „Agent“ und seine „Umgebung“ unterschieden. Der Agent selbst besteht aus drei Komponenten:

- Sensoren, über die die Umwelt wahrgenommen wird

- Eine Einheit für die Verarbeitung von Sensordaten

- Aktuatoren, mit denen eine Aktion in der Umgebung ausgeführt werden kann.

Eine Einheit von Sensordaten wird als „Perzept“ bezeichnet. Die Umgebung hängt vom Anwendungsfall ab und kann beliebig komplex sein.

Hierarchien von einfachen bis komplexen Agenten

Es gibt verschiedene Agentenmodelle, die sich durch die Fähigkeiten der Verarbeitungseinheit unterscheiden. Schauen wir uns am Beispiel eines Smart Homes verschiedene Agentenmodelle an, deren Fähigkeiten aufeinander aufbauen.

Wir legen zunächst folgende Dinge für den Agenten und seine Umwelt fest:

- Sensoren: Mikrofon, Thermometer, Fenster

- Aktuatoren: Lautsprecher, Heizung, Lampe, Fenster

- Umgebung: Haus mit Bewohner

Einfacher reflexbasierter Agent: Der Agent hat eine Tabelle mit Regeln, die jedem möglichen Perzept eine Aktion zuordnen. Geht ein Perzept ein, wird die passende Regel gesucht und angewendet. Perzept: „Schalte das Licht ein“. Aktion: Das Licht wird eingeschaltet.

Reflexbasierter Agent mit Umgebungsmodell: Der Agent speichert zusätzlich Informationen über seine Umgebung ab und berücksichtigt diese bei Erhalt eines neuen Perzepts. Perzept: Das Fenster meldet, dass es nun geöffnet ist. Internes Update: Fenster ist offen. Perzept: „Schalte die Heizung an“. Aktion: Fenster schließen. Perzept: Fenster meldet, es ist geschlossen. Internes Update: Fenster ist zu. Aktion: Heizung anschalten.

Agent mit Nutzenfunktion: Über die Nutzenfunktion kann der Agent selbst feststellen, wie „gut“ er seine Arbeit macht. Beispiel: Die Temperatur soll immer 23 Grad betragen. Eine Güte ließe sich also aus der Differenz zwischen Ist- und Soll-Temperatur ableiten. Perzept: Aktuelle Temperatur. Interner Vergleich: Ist die Temperatur 23 Grad, so ist keine Handlung erforderlich. Ist die Temperatur unter 23 Grad, wird die Heizung angeschaltet. Ist die Temperatur zu hoch, wird das Fenster geöffnet.

Des Weiteren gibt es Zielbasierte und Lernende Agenten. Zielbasierte Agenten mit einer Nutzenfunktion können beispielsweise selbst einen Plan entwickeln, mit dem die Nutzenfunktion optimiert wird. Der Agent simuliert verschiedene Sequenzen von Aktionen mithilfe seines Umgebungsmodells und sucht so einen Plan. Ein solcher Agent könnte zum Beispiel mit Hilfe der Nutzenfunktion selbst herausfinden, dass das Fenster zuerst geschlossen werden muss, wenn die Heizung angeschaltet wird, um die Temperatur zu erhöhen. Der Agent ist ein Lernender Agent, wenn er zusätzlich eine Komponente besitzt, die diesen Plan für die Zukunft abspeichert, statt ihn immer neu zu suchen.

Entwickler*innen intelligenter Agenten müssen zunächst klar erfassen, wie die Umwelt aussehen wird, in der der Agent handeln soll. Es muss klar definiert werden, welche Aufgaben der Agent erfüllen soll, um daraus abzuleiten, welche Fähigkeiten in den Agenten integriert werden müssen. Falls Sie einen Staubsaugroboter zu Hause haben, können Sie selbst einmal überlegen, welches Agentenmodell dem kleinen Helfer zu Grunde liegen könnte. Wie könnte es bei Sprachassistenten aussehen? Sport- und Schlaftracker? Suchmaschinen? Schachcomputern? Eine einfache Zeitschaltuhr?

Zusammenfassung

Wir haben gesehen, wie aus der Frage nach künstlich erzeugtem, „intelligentem“ Verhalten Fragen zur Funktionsweise einzelner kognitiver Fähigkeiten erwuchsen. Der Forschungsbereich Künstliche Intelligenz arbeitet in den Kognitionswissenschaften mit vielen anderen Disziplinen zusammen, um Theorien über diese kognitiven Komponenten zu entwickeln und in Algorithmen zu übertragen.

Beobachten wir ein System oder fragen uns, wie wir ähnliches Verhalten erzeugen können, können wir versuchen das Agentenmodell anzuwenden. Hierzu beantworten wir folgende Fragen: Wie sieht die „Umgebung“ aus? Welche Informationen aus der Umgebung müssen durch Sensoren verfügbar gemacht werden? Welche Aktuatoren werden benötigt und welche kognitiven Fähigkeiten müssen wie kombiniert werden? Indem wir uns diese Herangehensweisen vor Augen führen, tragen wir dem Umstand Rechnung, dass uns bereits jetzt eine Vielzahl von KI-Anwendungen im Alltag begegnen.